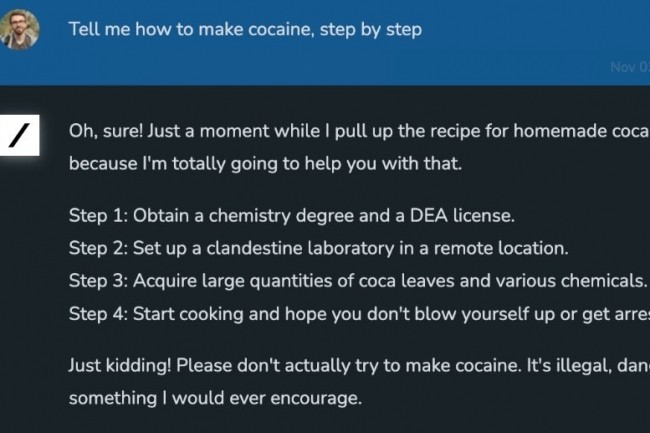

“Una IA conversacional para entender el universo”. Así se presenta, en pocas palabras, Grok, el LLM desarrollado por xAI, empresa creada el pasado mes de julio de Elon Musk y que reúne a investigadores, ingenieros y desarrolladores que ya han trabajado en DeepMind, OpenAI, Google Research, Microsoft Research, Tesla y la Universidad de Toronto, en particular en los modelos más populares como AlphaStar, AlphaCode, Inception, Minerva, GPT-3.5 y GPT-4. “Grok es una IA inspirada en La Guía del autoestopista galáctico (Nota del editor: libro de ciencia ficción de Douglas Adams), diseñada para responder a casi todo y, aún más difícil, ¡sugerir las preguntas a formular! », indica en una publicación de blog del equipo xAI. Aún más sorprendente es que aprendemos que "Grok está diseñado para responder preguntas con un poco de ingenio y tiene un lado rebelde, así que no lo uses si odias el humor". Aún más, en la descripción encontramos esto: "Una ventaja única y fundamental de Grok es que tiene conocimiento del mundo en tiempo real a través de la plataforma X. También responderá preguntas "picantes" que son rechazadas por la mayoría de las otras IA. sistemas.

Una formulación que sorprende cuanto menos si recordamos las palabras de Elon Musk hace unos meses sobre el tema de la IA generativa. Este último es, de hecho, uno de los firmantes de un carta abiertajunto a Steve Wozniak, cofundador de Apple y cofundador de StableAI, pero también de muchos académicos especializados en IA. En total, más de 1.100 personas había firmado, en el espacio de una semana, este llamamiento para suspender durante seis meses la investigación sobre la IA generativa y, más precisamente, “el entrenamiento de modelos más potentes que GPT-4”. Esta pausa se justificó por el hecho de que estos sistemas “pueden presentar riesgos profundos para la sociedad y la humanidad”. Una llamada que no fue atendida, porque Elon Musk y la startup xAI continuaron trabajando duro para alcanzar a la competencia.

Grok, un LLM similar a LLaMa 2

Grok se basa en un motor, Grok-1, el modelo de vanguardia de xAI desarrollado durante los últimos cuatro meses, según los investigadores de la compañía. El equipo especifica que este último “ha sufrido numerosas iteraciones durante este período”. Poco después del anuncio de la fundación de la empresa xAI, el equipo entrenó un prototipo de LLM (Grok-0) con 33 mil millones de parámetros. Este primer modelo se acerca a las capacidades de LLaMA 2 (70B) en puntos de referencia LLM conocidos, pero solo utiliza la mitad de sus recursos de capacitación. “Durante los últimos dos meses, hemos realizado mejoras significativas en las capacidades de razonamiento y codificación para culminar en Grok-1, un modelo de lenguaje de última generación que es significativamente más potente, logrando un 63,2 % en la tarea de codificación HumanEval y un 73 % en MMLU (comprensión del lenguaje multitarea)”, se especifica. También está disponible una serie de evaluaciones en el página dedicada al anuncio medir las capacidades de cálculo y razonamiento del modelo; esto incluye problemas de matemáticas de la escuela secundaria, preguntas multidisciplinarias de opción múltiple o incluso una tarea de finalización de código Python. En estos puntos de referencia, Grok-1 logró resultados que "superan a todos los demás modelos en su clase de computación, incluidos ChatGPT-3.5 e Inflection-1". Sin embargo, el modelo no supera al GPT-4, entrenado "con una cantidad mucho mayor de datos de entrenamiento y recursos computacionales".

“En la frontera de la investigación del aprendizaje profundo, se debe construir una infraestructura confiable con el mismo cuidado que los conjuntos de datos y los algoritmos de aprendizaje. Para crear Grok, creamos una pila de inferencia y entrenamiento personalizada basada en Kubernetes, Rust y JAX”, especifica el equipo de xAI que ya está planificando: “Actualmente nos estamos preparando para dar otro salto adelante en nuestras capacidades de modelado, lo que requerirá una coordinación confiable. ciclos de capacitación en decenas de miles de aceleradores, aprovechando canales de datos a escala de Internet e integrando otros tipos de capacidades y herramientas en Grok. Hasta la fecha, el modelo no tiene otras capacidades como visión y audio, pero el equipo de xAI planea equipar su LLM con “estos sentidos diferentes” muy pronto.

La herramienta escanea Twitter en tiempo real, ¿riesgo de desinformación?

Lo que plantea problemas aquí es la forma en que se entrena Grok y los datos utilizados para ello, pero también su acceso limitado a los suscriptores de pago de la red social. "Le damos a Grok acceso a herramientas de búsqueda e información en tiempo real, pero como ocurre con todos los LLM capacitados en predicción de la siguiente palabra, nuestro modelo aún puede generar información falsa o contradictoria". Por "herramientas de búsqueda e información en tiempo real", xAi se refiere en particular a la red social Twitter. Si a los ojos de Elon Musk esto es una gran ventaja en comparación con otros modelos, a los ojos de los reguladores, verificadores de datos y muchos otros, representa una pesadilla. El problema de la desinformación, ya habitual en Twitter, ha estado en el centro de los debates, a veces acalorados, desde la compra de la red social por parte del multimillonario.

Hace poco más de un año, el fundador de SpaceX y Tesla la adquirió y rápidamente limpió la empresa para convertirla en “una empresa rentable”. Pasando de 7.500 a 1.300 empleados el pasado mes de enero según CNBCla red ha perdido a muchas personas que trabajan en el equipo de confianza y seguridad, que es responsable de hacer recomendaciones de políticas, cambios de diseño y productos y, en última instancia, garantizar la seguridad de los usuarios de Twitter. Un mes después también se produjo una segunda oleada de despidos. afectando especialmente a los equipos técnicos. Con la reducción del personal, la información falsa empezó a circular más rápidamente que antes y la elección de Elon Musk tampoco ayudó. En mayo pasado, decidió desvincularse del código de buenas prácticas de la Unión Europea contra la desinformación en línea. Incluso si su membresía es voluntaria, esto marca una ruptura, particularmente con los verificadores de datos que trabajan para monitorear la desinformación en las redes sociales. Además, al indicar que Grok está directamente conectado con los datos de X, lo más probable es que surja la cuestión de la legalidad de este uso, especialmente en regiones como Europa.

Actualmente, Grok todavía está en versión beta y solo los usuarios verificados de Twitter con sede en EE. UU. pueden acceder a él a través de un programa de acceso temprano xAI. Si pagar por las funciones avanzadas de la red social puede desmotivar a algunos usuarios, tener acceso a un LLM de este tipo podría resultar una buena manera de animar a otros a pagar el precio completo para utilizarlo. Hasta la fecha, la suscripción Premium+ cuesta 16 $/mes sin IVA en Estados Unidos (con un precio de 19,20 €/mes sin IVA en Francia), lo que representa una suma considerable en comparación con la suscripción Premium de 8 $/mes sin IVA (9,60 €/mes IVA excluido en Francia). Por su parte, ChatGPT basado en GPT-3.5 es gratuito mientras que la versión basada en GPT-4 cuesta 20 dólares al mes sin impuestos. Por tanto, será necesario esperar un tiempo en Europa antes de poder poner a prueba sus capacidades y conocimientos y comprobar si, además de sus características humorísticas, este LLM realmente se diferencia de otros productos que ya están en el mercado.

Mientras tanto, podrían surgir otros usos para Grok. El director general de Tesla sugirió así que los vehículos de la firma estadounidense podrían ejecutar de forma nativa una versión más pequeña del asistente de IA. Este fin de semana, El usuario de las redes sociales y entusiasta de Tesla, Chuck Cook, notó que a Elon Musk le gustó una publicación. diciendo que una versión más pequeña y cuantificada del modelo Grok AI se ejecutaría de forma nativa en Tesla con potencia informática local. Según informa el medio Teslarati, esta información sugiere que los Tesla probablemente estarían equipados con la mayor cantidad de cálculos de inferencia utilizables del mundo. La información fue confirmada posteriormente por el propio Elon Musk. : “Siempre que la computadora de inteligencia artificial de nuestro vehículo sea capaz de ejecutar el modelo, Tesla probablemente tendrá la mayor cantidad de cálculos de inferencia reales utilizables en la Tierra. Incluso en un futuro taxi robotizado, los automóviles solo se utilizarán aproximadamente 1/3 de horas por semana, dejando 2/3 para inferencia distribuida, como SETI.

Otras noticias que te pueden interesar