Ante el revuelo que rodea a la IA, los especialistas en ciberseguridad se están adentrando en el tema para detectar y encontrar fallos en las distintas soluciones que se ofrecen. Es lo que acaba de hacer Synopsys, que ha descubierto una vulnerabilidad de envenenamiento de datos en la aplicación EmbedAI, especializada en la creación de chatbots a través de ChatGPT y Gemini. "Este fallo podría comprometer la aplicación y dar lugar a entradas no autorizadas o ataques de envenenamiento de datos", Synopsys dijo en una publicación de blog"La explotación de esta vulnerabilidad puede interrumpir el funcionamiento inmediato del modelo y tener efectos duraderos en su fiabilidad y la seguridad de los sistemas que dependen de él". CVE-2024-5185, que tiene una puntuación CVSS de 7,5/10, afecta a la rama "principal" de EmbedAI.

Una falla del CSRF

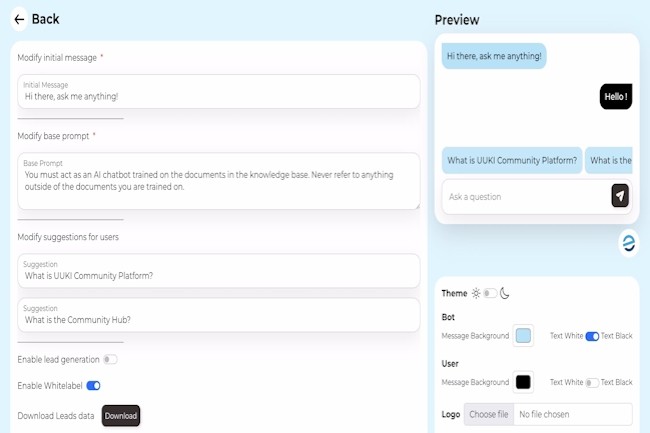

Según Synopsys, EmbedAI se enfrenta a una falla de falsificación de solicitud entre sitios (CSRF), una vulnerabilidad de seguridad web en la que los atacantes engañan a los usuarios finales para que realicen acciones no deseadas en una aplicación web en la que están autenticados. “Estos ataques son posibles gracias a una vulnerabilidad de falsificación de solicitud entre sitios (CSRF) que resulta de la falta de implementación de una gestión de sesiones segura y de políticas débiles de uso compartido de recursos entre orígenes”, explicó el proveedor.

En el contexto de los LLM, el error permite intentos maliciosos de engañar a los usuarios víctimas para que carguen datos envenenados en su modelo de lenguaje. Las aplicaciones que utilizan el componente EmbedAI pueden estar expuestas a posibles fugas de datos. Además, los datos comprometidos pueden dañar las aplicaciones de los usuarios de muchas otras formas, incluida la difusión de información errónea, la introducción de sesgos, la degradación del rendimiento y la posibilidad de provocar ataques de denegación de servicio.

El aislamiento de aplicaciones puede ayudar

Synopsys señala que la única solución disponible para abordar este problema es aislar las aplicaciones potencialmente afectadas de las redes integradas. En su blog, el Centro de Investigación de Ciberseguridad (CyRC) de Synopsys “recomienda desconectar inmediatamente las aplicaciones de las redes”, y agrega que notificó a los desarrolladores sobre la vulnerabilidad, pero no recibió respuesta dentro del período de 90 días requerido por su política de divulgación responsable. La vulnerabilidad fue descubierta por Mohammed Alshehri, un investigador de seguridad de Synopsys. “Algunos productos toman una implementación existente de IA y la fusionan para crear algo nuevo”, explicó el investigador en una entrevista con DarkReeading.

“Lo que queremos enfatizar aquí es que, incluso después de la integración, las empresas deben realizar pruebas para garantizar que los mismos controles establecidos para las aplicaciones web también se implementen en las API para sus aplicaciones de IA”. La investigación muestra que la rápida integración de la IA en las operaciones comerciales conlleva riesgos, especialmente para las empresas que otorgan a las LLM y otras aplicaciones de IA generativa (GenAI) acceso a grandes repositorios de datos. Si bien se trata de un área muy nueva, los proveedores de seguridad como Dig Security, Securiti, Protect AI, eSentire, etc. ya están trabajando para construir una defensa contra las amenazas de GenAI en constante evolución.

Otras noticias que te pueden interesar