Mejor aprovechamiento de la información de los equipos tras averías y fallos en las plantas de producción, empezando por las refinerías. Sobre la base de esta hoja de ruta, el equipo de Smart Search Engines del departamento OneTech de TotalEnergies, la rama que reúne la experiencia técnica y científica del grupo, comenzó a diseñar herramientas de búsqueda para expertos técnicos y equipos de mantenimiento. "La primera necesidad surgió del equipo responsable de la disponibilidad de la refinería de Amberes, tras un incidente ocurrido en el lugar en 2021", explica Aude Giraudel, responsable del departamento de Smart Search Engines. En este caso, una grieta en un equipo provocó una parada de producción de 4 días, lo que representó alrededor de un millón de euros de pérdida de ingresos en la mayor plataforma europea de refino y petroquímica del gigante francés. Sin embargo, un incidente similar ya había ocurrido cuatro años antes. "La observación es que no estamos aprovechando lo suficiente las lecciones aprendidas de los eventos pasados, aunque estén documentados", continúa el directivo.

En caso de incidencias que afecten a la producción, los equipos de TotalEnergies elaboran informes de feedback (REX) o análisis de causa raíz. Si bien los primeros se almacenan debidamente en herramientas de capitalización y compartición de información (como SharePoint o EDM), la búsqueda en esta base de conocimientos sigue siendo relativamente poco desarrollada. De ahí la idea del servicio Smart Search Engines de ofrecer un motor de búsqueda que consulte estos últimos. En 2022 se lanzará un primer prototipo, basado en la tecnología Sinequa, antes de su industrialización en el transcurso de 2023. El portal, que ofrece filtros específicos (en un sitio o equipo determinado), entrará en producción a principios de 2024 en la planta de Amberes, y su despliegue en las demás unidades de refinación y petroquímica está en curso.

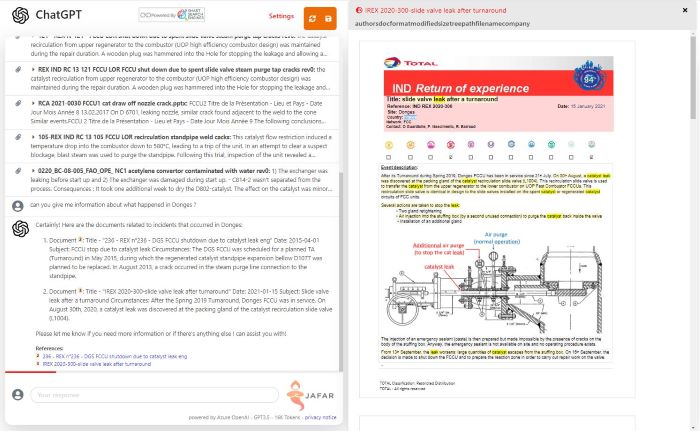

“La integración de la IA generativa tiene como objetivo consultar la base de datos REX en lenguaje natural y ofrecer un resumen de las respuestas a los usuarios”, explica Aude Giraudel, responsable del departamento de Motores de búsqueda inteligentes. (Foto: DR)

IA generativa, una continuación natural

Este portal, actualmente en inglés y llamado Milaa (por My Intelligent Learning Application for Availability), también debe convertirse gradualmente en multilingüe. "El objetivo es ofrecer Milaa en cuatro idiomas: inglés, holandés, alemán y francés", indica Pierre Jallais, arquitecto de soluciones de búsqueda dentro del equipo de Smart Search Engines. El mecanismo multilingüe está actualmente en implementación. Un conjunto de funcionalidades que requirieron personalizaciones importantes, debido al vocabulario específico manejado por los expertos técnicos del grupo petrolero. "Disponíamos de un cierto número de diccionarios de vocabulario comercial y recursos semánticos, por ejemplo sobre acrónimos", continúa el arquitecto. "Pero aún necesitan ser integrados en la herramienta de búsqueda, lo que está lejos de ser inmediato". El equipo de Smart Search Engines estima, sin embargo, que el trabajo de desarrollo en torno a Milaa debería completarse en verano.

“Hoy en día, Jafar es utilizado principalmente por expertos técnicos para preparar cierres importantes”, afirma Pierre Jallais, arquitecto de soluciones de búsqueda dentro del equipo Smart Search Engines. (Foto: DR)

Mientras tanto, se ha producido una evolución de la solución que integra la IA generativa. "Es un paso lógico", explica Aude Giraudel. "Consiste en consultar la base de datos REX en lenguaje natural y proporcionar un resumen de las respuestas a los usuarios". En otras palabras, pasar a un portal orientado al conocimiento entregando resúmenes de varios documentos, manteniendo al mismo tiempo la trazabilidad hasta los documentos de origen, en este caso los aproximadamente 5.000 REX de los que dispone TotalEnergies, consolidando los documentos disponibles en Amberes y en la sede del grupo en París. Como es habitual en el uso de RAG (Retrieval Augmented Generation) que ofrece Sinequa además de sus herramientas de búsqueda, la evolución del portal, rebautizado como Jafar (por Generative AI for availability REX), dio lugar a un primer prototipo producido en tres meses y basado en GPT 4, el LLM de OpenAI alojado aquí en Azure. Una herramienta que fue evaluada por una treintena de expertos, a través de una serie de preguntas sobre la pertinencia de las respuestas proporcionadas. "Acabamos de obtener la validación para industrializar el enfoque y desplegar más ampliamente esta versión", afirma el responsable del departamento de Smart Search Engines.

RAG, ante todo un esfuerzo de investigación

"Hoy en día, Jafar es utilizado principalmente por expertos técnicos para preparar paradas importantes. Cuando planifican estas paradas programadas de una refinería (para comprobar su estado y realizar todas las reparaciones, sustituciones y ajustes necesarios, NdR), aprecian las capacidades de síntesis de la herramienta", asegura Pierre Jallais. Para el arquitecto, en una segunda fase, Jafar podría abrirse a los operadores de refinerías, para que puedan preparar sus intervenciones. "Pero las funcionalidades multilingües serán entonces esenciales", subraya el arquitecto. El reto será ofrecer la posibilidad de hacer una pregunta en holandés para recuperar documentos en alemán que contengan acrónimos en inglés, por ejemplo". Para ello, la empresa energética apuesta por una combinación de IA estándar y recursos semánticos internos. "La empresa está considerando actualmente la aplicación de modelos lingüísticos desarrollados internamente a partir de los datos de la empresa, principalmente en el sector de las geociencias. El REX solo afecta a unos pocos miles de documentos, una cantidad insuficiente para considerar el entrenamiento de un modelo", señala el arquitecto.

Captura de pantalla de la solución Jafar. La combinación de ChatGPT y la herramienta de búsqueda de Sinequa.

Para Pierre Jallais, la complejidad de un desarrollo RAG no reside en la integración de la IA generativa en sí, sino más bien en la parte de investigación. "Alimentar la IA generativa con la información correcta representa el 80% del esfuerzo, el resto se dedica a la configuración del LLM y a la ingeniería rápida", asegura. Y, el esfuerzo de configurar la búsqueda para una herramienta como Jafar es mucho mayor que para Milaa; hay que ser más preciso en las respuestas proporcionadas volviendo a los pasajes más interesantes. Ajustar el tamaño de los párrafos que se transmitirán al LLM requiere mucho trabajo en sí mismo". Paralelamente a la industrialización de sus herramientas, el equipo de Aude Giraudel y Pierre Jallais también está trabajando en mejoras de Jafar, que permitan entregar esqueletos de informes a los expertos para personalizarlos en función del análisis de varios REX. Pero también en la reutilización de la arquitectura de esta solución para otras necesidades, en particular para un portal dedicado a las geociencias.

Además:

- Audi optimiza su documentación interna con un chatbot basado en IA

- Airbus prueba la IA generativa en modo RAG

Otras noticias que te pueden interesar