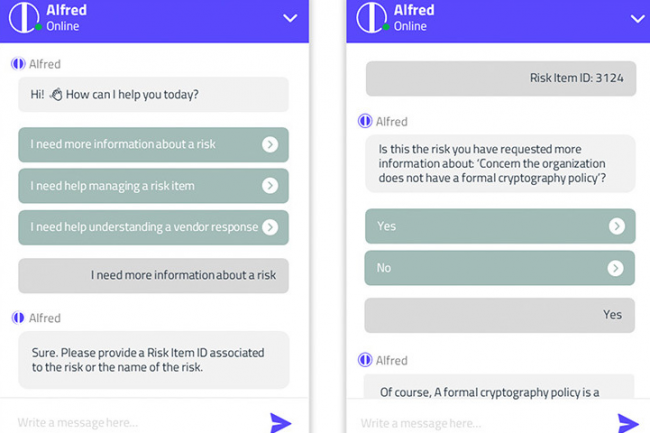

Impulsado por el proveedor de productos de gestión de riesgos de terceros (TPRM), Prevalent, el chatbot Alfred impulsado por un modelo de lenguaje grande (LLM) debería ayudar a los usuarios a realizar tareas de gestión de riesgos de terceros. tercero. Responde a preguntas comunes sobre evaluación y gestión de riesgos para las cuales los usuarios pueden tener una experiencia humana interna limitada, y también puede reducir el tiempo de toma de decisiones, así como mejorar la precisión de las elecciones. Detrás de escena, la herramienta se basa en la tecnología de inteligencia artificial generativa de OpenAI, respaldada por Microsoft, que utiliza datos generalizados sobre eventos y observaciones de riesgo para generar información precisa sobre el perfil de riesgo de una organización. un cliente determinado. Prevalent señala que todos los datos son anónimos y que el asesoramiento que brinda Alfred se basa en estándares de la industria como NIST, ISO y SOC2. "La IA se integra perfectamente en la solución TPRM existente", añadió también Prevalent.

En un comunicado de prensaLa compañía afirmó que los resultados de la IA se verifican y revisan continuamente para determinar su precisión, y que los datos utilizados para entrenarlos han sido "validados por más de 20 años de experiencia en la industria", sin especificar su naturaleza y volumen. Brad Hibbert , director de operaciones y jefe de investigación científica de Prevalent, dijo que a pesar de la cautela natural, la base de clientes de la compañía había expresado curiosidad sobre el uso de la IA para evaluar los riesgos, por lo que Prevalent adoptó lo que Brad Hibbert llama un "enfoque basado en casos de uso". "Es importante tener en cuenta que las capacidades de IA han sido parte de las características de la plataforma Prevalent desde hace algún tiempo, como el análisis de ML y el análisis de documentos de PNL, pero esta es la primera característica de IA conversacional/generativa", dijo Brad Hibbert.

Próximamente revisión de artefactos de seguridad mejorada

Aunque la toma de decisiones de Alfred actualmente no depende de la información proporcionada por el cliente, Brad Hibbert aclaró que la interfaz de usuario y la carga de trabajo se desarrollaron teniendo en cuenta, en parte, los comentarios de los clientes. usuarios. También señaló que la compañía planea agregar funciones de IA más generativas a su plataforma, incluida una revisión mejorada de los artefactos de seguridad y un conjunto de evaluaciones automatizadas (esencialmente completando formularios de seguridad complejos). ), pero que todavía no estaban disponibles. "El desarrollo sigue centrado en resolver problemas reales de los clientes", afirmó Brad Hibbert. “Alfred resuelve el problema de la falta de contexto o de recursos calificados para entender qué significa un riesgo y qué hacer al respecto”. Alfred ya está disponible para todos los clientes de la plataforma Prevalent, sin coste adicional.

El software se suma al conjunto de herramientas basadas en inteligencia artificial que ahora se encuentran en productos de seguridad de una gran cantidad de proveedores. Esta semana, AuditBoard agregó inteligencia artificial y capacidades de análisis de riesgo y cumplimiento, y la semana pasada, Vanta anunció la integración de inteligencia artificial generativa en su producto principal de seguridad y cumplimiento. Algunos de los mayores proveedores de tecnología también están integrando IA generativa en sus ofertas de seguridad. Es el caso, por ejemplo, de Microsoft, que en marzo anunció Copilot Security, un asistente de IA para ciberseguridad basado en GPT-4.

Otras noticias que te pueden interesar