Por qué su teléfono no puede resolver cómo tomar una foto del apocalipsis

hace 5 años

En circunstancias normales, las cámaras de los teléfonos inteligentes hacen un gran trabajo, capturando perfectamente los momentos cotidianos. Luego llegó el 2020. Frente a incendios forestales sin precedentes en la costa oeste de EE. UU., Los iPhones y los androides se han quedado perplejos ante un mundo que se parece más a Blade Runner 2049 que septiembre de 2020.

Los misteriosos cielos anaranjados desconcertaron por completo los algoritmos de procesamiento de imágenes que normalmente hacen que las instantáneas de teléfonos inteligentes se vean tan nítidas, lo que resulta en fotos que hacen poco para capturar la realidad apocalíptica. Como resultado, muchas personas se han visto obligadas a jugar con la configuración manual por primera vez. Entonces, ¿por qué los teléfonos inteligentes luchan en este escenario extremo?

Primero, analicemos cómo funciona la cámara de su teléfono. La mayoría de los teléfonos inteligentes tienen sensores de cámara producidos por Sony. Representa aproximadamente el 42 por ciento del mercado. Esos sensores CMOS que produce Sony van a dispositivos de todas las marcas, incluidos los iPhones, que representan casi la mitad de todos los teléfonos inteligentes en los EE. UU.

La tendencia actual para las cámaras de los teléfonos inteligentes es utilizar una arquitectura de filtro Quad Bayer que se coloca encima de un sensor digital sensible a la luz. Un filtro Bayer se construye utilizando pequeños bancos de píxeles filtrados para permitir que la luz roja, verde o azul los atraviese. El sensor de imágenes en sí solo detecta la intensidad de la luz, por lo que sin el filtro Bayer, sus imágenes simplemente saldrían en blanco y negro. Ésta es la primera parte del dilema.

La segunda parte es que debido a que el ojo humano es típicamente más sensible a la longitud de onda de la luz verde (~ 530 nm), los sensores CMOS basados en RGGB están construidos para tener más píxeles cubiertos por filtros verdes en una matriz de Bayer. Usando una cámara de teléfono inteligente de 12MP como ejemplo, seis megapíxeles (seis millones) se asignarán al verde, con tres millones asignados a las secciones filtradas por rojo y azul. Luego, el procesador de imágenes de su teléfono inteligente usa un algoritmo de demostración para crear una imagen de 12MP a todo color combinando los colores primarios.

Sin embargo, los filtros Quad Bayer que se utilizan en los teléfonos inteligentes no utilizan cuatro matrices de filtros. En cambio, el sensor está construido con cuatro veces la cantidad de píxeles. Esto ve la colocación de cuatro píxeles detrás de cada filtro de color cuadrado, en lugar de solo un píxel por fotosito sensible a la luz en el sensor. Como un pequeño aparte, esta es la razón por la que muchos teléfonos inteligentes se enumeran con cámaras de 48MP, pero solo producen imágenes de 12MP de forma predeterminada. Ahora la siguiente pieza del rompecabezas.

La espectacular mejora en la calidad de las cámaras de los teléfonos inteligentes se debe en gran parte al desarrollo de potentes algoritmos y potencia de procesamiento de imágenes. Empresas como Sony utilizan el aprendizaje informático para entrenar sus algoritmos de imágenes utilizando cientos de millones de imágenes. Enseñan eficazmente a ver la cámara de su teléfono. A los procesadores de imágenes se les enseña a detectar la escena, el sujeto o el escenario y luego seleccionar los ajustes de exposición necesarios para lograr la toma deseada.

Pero la deseabilidad está incorporada en lo que la cámara ha sido entrenada para ver y cómo ese fabricante en particular ha decidido que quiere que se vean sus fotos. Esto afectará la configuración de balance de blancos que seleccione el teléfono, así como la velocidad de obturación, la sensibilidad a la luz, la nitidez y la saturación del color.

Esta es la razón por la que las fotos capturadas con diferentes cámaras son diferentes, incluso cuando esencialmente utilizan el mismo hardware de cámara. La combinación de algoritmos es única para cada marca. Esta es la razón por la que los teléfonos Samsung generalmente capturan fotos con alta saturación y los iPhones a menudo son elogiados por producir las fotos de apariencia más “natural”, por ejemplo.

En última instancia, esta es la razón por la que los teléfonos que se usan para capturar imágenes de escenas de incendios forestales apocalípticos luchan por producir una imagen que sea precisa para lo que la gente está viendo en el suelo. Las ondas de luz de alta frecuencia atraviesan las partículas emitidas por los incendios y la ionosfera de la Tierra con más facilidad que la luz roja de baja frecuencia. Las personas solo pueden detectar entre 400 y 700 nm de longitud de onda de luz. La luz roja viaja a alrededor de 430 billones de hercios, la frecuencia de luz más baja detectable.

Lo que la gente está viendo esencialmente es una combinación de luz roja atrapada por materia particulada del fuego y rebotando desde la ionosfera en ausencia de las otras longitudes de onda. Las cámaras de los teléfonos inteligentes nunca fueron entrenadas para este escenario, sin embargo, las formas que ven; las casas, los coches, los paisajes les son familiares.

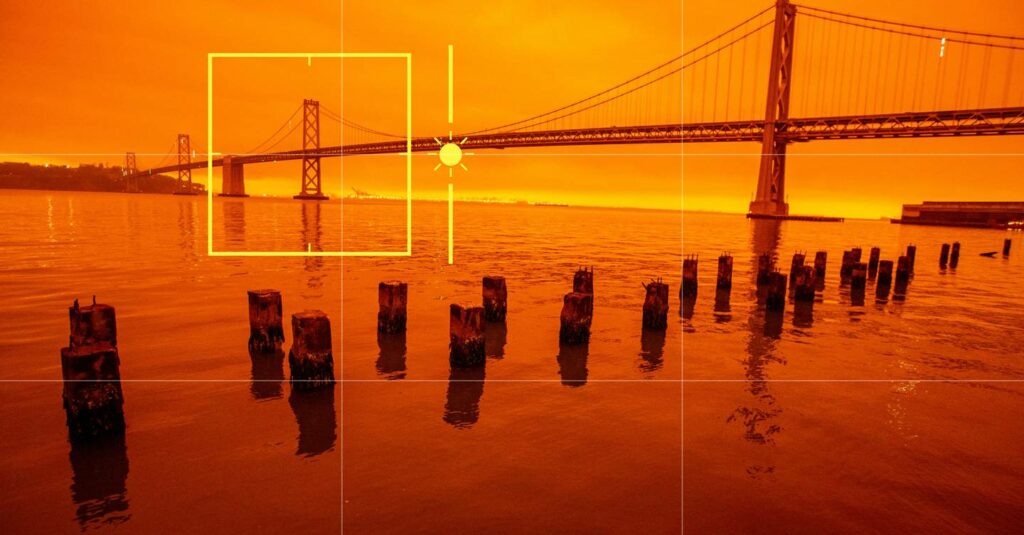

Debido a que la luz está dominada por el rojo, algunas cámaras de teléfonos inteligentes intentan compensar seleccionando un ajuste de balance de blancos que ofrezca una representación más neutra o típica de esas escenas familiares. Las imágenes resultantes se vuelven opacas, marrones, amarillentas, descoloridas (como se ve arriba) o incluso oscurecidas en algunas circunstancias, ya que el sistema de medición de luz del teléfono lucha para producir fielmente lo que se le presenta.

Entonces, ¿cómo se toman fotografías precisas de un cielo rojo durante un desastre? Es una pregunta muy de 2020. La forma más eficaz de hacer esto sin tener que dedicar demasiado tiempo a editar las imágenes es desactivar el Balance de blancos automático. La mayoría de los teléfonos en estos días tienen un modo "Pro" que le permitirá seleccionar configuraciones manuales. Si tiene esta opción, úsela y comience seleccionando un ajuste de balance de blancos de luz diurna. Esto también se puede representar como un valor de temperatura de color, en Kelvin (5000K-6500K).

Al decirle a su cámara qué color debería ver, producirá una imagen más cercana a lo que ve frente a usted. La parte más útil de esto es que los cambios que realiza en los ajustes de balance de blancos o temperatura de color se realizan en tiempo real, por lo que puede verlos y combinarlos por sí mismo.

Más historias geniales de Mundo Informático

? Dentro del plan secreto para reiniciar Isis desde una enorme copia de seguridad digital

⌚ Tu Apple Watch pronto podría decirte si tienes coronavirus. He aquí cómo

?️ ¿Estás harto de regalar tus datos? En su lugar, pruebe estas alternativas de Google Maps que respetan la privacidad

? Escuche The Mundo Informático Podcast, la semana de ciencia, tecnología y cultura, que se entrega todos los viernes

? Siga Mundo Informático en Gorjeo, Instagram, Facebook y LinkedIn

Si quieres conocer otros artículos parecidos a Por qué su teléfono no puede resolver cómo tomar una foto del apocalipsis puedes visitar la categoría Otros.

Otras noticias que te pueden interesar