OpenAI bloquea campañas de desinformación generadas por IA

hace 1 año

Las herramientas de inteligencia artificial generativa de OpenAI se utilizaron para crear y publicar contenido propagandístico en las redes sociales sobre temas geopolíticos y socioeconómicos.

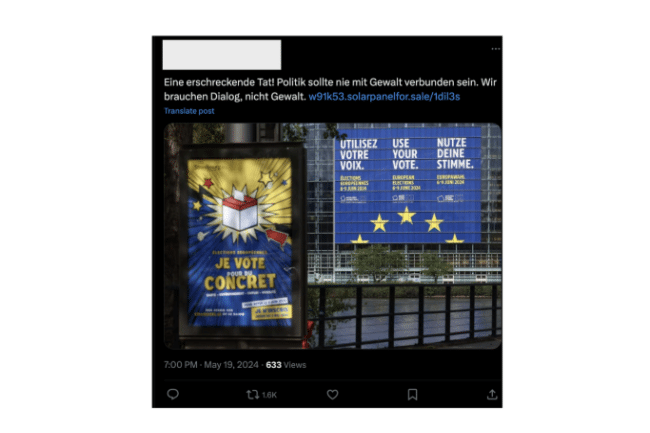

OpenAI ha señalado a China, Rusia, Irán e Israel por utilizar su herramienta GenAI para llevar a cabo campañas de desinformación. La start-up precisa que ha logrado detectar 5 operaciones de este tipo en los últimos tres meses. “Estos actores utilizaron las herramientas de inteligencia artificial de OpenAI para crear y publicar contenido propagandístico sobre diversos temas geopolíticos y socioeconómicos en plataformas de redes sociales”, señala la compañía en su informe. Sin embargo, pone las cosas en perspectiva al observar que en mayo de 2024, estas campañas no parecían haber "aumentado significativamente el compromiso o el alcance de su audiencia gracias a nuestros servicios".

Una ola de campañas activas

Entre las campañas detectadas se encuentra una de origen ruso denominada “Bad Grammar”. Se dirigió a Ucrania, Moldavia, los Estados bálticos y los Estados Unidos para crear comentarios políticos y código de depuración para los bots de Telegram utilizando las herramientas de inteligencia artificial de OpenAI. Otra operación rusa llamada “Doppelganger” generó comentarios en varios idiomas, tradujo artículos y los publicó en plataformas como Facebook, 9GAG y X. “Una red china conocida como Spamouflage, utilizó nuestros modelos para investigar la actividad pública en las redes sociales, generar textos en varios idiomas, incluidos chino, inglés, japonés y coreano, luego publíquelos en plataformas como X, Medium y Blogspot, y depure el código para administrar bases de datos y sitios web, incluido un dominio no reportado anteriormente, revelacum.[.]com”, decía el informe.

De manera similar, una operación iraní conocida como “La Unión Internacional de Medios Virtuales” (IUVM) escribió artículos y titulares extensos a través de IA para su publicación en el sitio ivumpress.co. Además, una empresa israelí STOIC lanzó una operación llamada “Zero Zeno” que generó artículos y comentarios publicados en varias plataformas con IA, incluidas Instagram, Facebook, X y sus propios sitios web. "El contenido publicado por estas diversas operaciones cubrió una amplia gama de temas, incluida la invasión rusa de Ucrania, el conflicto de Gaza, las elecciones indias, la política en Europa y Estados Unidos y las críticas al gobierno chino por parte de disidentes chinos y gobiernos extranjeros". continúa el informe de OpenAI. El primero de su tipo producido por la empresa, destaca varias tendencias entre estas operaciones. Los malos actores han confiado en herramientas de inteligencia artificial como ChatGPT para generar grandes volúmenes de contenido con menos errores de idioma, crear la ilusión de participación en las redes sociales y mejorar la productividad al resumir mensajes y al mismo tiempo depurar el código. Sin embargo, el informe añade que ninguna de las operaciones logró "movilizar audiencias reales de manera significativa".

Meta AI también utilizada

Un informe similar publicado recientemente por Facebook ya señaló el creciente uso indebido de las herramientas de inteligencia artificial por parte de estas “operaciones de influencia” con intenciones maliciosas. La empresa los llama CIB (Coordinated Inauthentic Behavior) y los define como “esfuerzos coordinados para manipular el debate público con fines estratégicos, en los que las cuentas falsas están en el centro de la operación”. Cada vez, las personas coordinan y utilizan cuentas falsas para engañar a otros sobre su identidad y actividades. En su informe trimestral de amenazas, Meta dice que recientemente cerró numerosas operaciones de este tipo que utilizaban IA para generar imágenes, videos y texto para implementar su agenda. También podemos destacar la campaña Portal Kombat descubierta recientemente por Viginum.

Después de interrumpir las operaciones de influencia, OpenAI utilizó herramientas de inteligencia artificial como medidas defensivas para mejorar la detección y el análisis, haciendo que las investigaciones sean más efectivas. La empresa también impuso medidas de seguridad que a menudo impedían la creación de contenido malicioso, según el informe. "OpenAI publica estos hallazgos, al igual que otras empresas de TI, para promover el intercambio de información y las mejores prácticas entre la comunidad de partes interesadas en general".

Si quieres conocer otros artículos parecidos a OpenAI bloquea campañas de desinformación generadas por IA puedes visitar la categoría Otros.

Otras noticias que te pueden interesar