Opadai Pon las bocados dobles. Desde el lanzamiento de su chatbot a fines de 2022, la puesta en marcha ha estado en el centro de toda atención y tiene la intención de usarlo. Incluso si se registra como una empresa lucrativa limitada, ha monetizado sus servicios basados en diferentes modelos de IA, comenzando con ChatGPT con el lanzamiento de una oferta premium, ChatGpt Plus, en febrero. Hoy, toma un paso más en esta valoración al introducir API para las empresas; Por lo tanto, estos pueden integrar la tecnología OpenAI en todas sus aplicaciones, sitios web, productos y servicios.

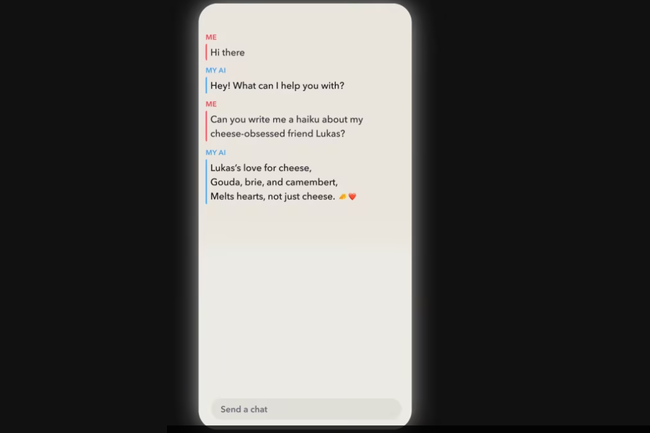

"Los modelos ChatGPT y Whisper ahora están disponibles en nuestras API, que permite a los desarrolladores acceder a las funcionalidades de recorte en términos de lenguaje (¡y no solo CAT!) Y reconocimiento de voz" Indica la empresa. Claramente, los desarrolladores ahora pueden esperar resultados mucho más rápidos y relevantes al usar los dos modelos.

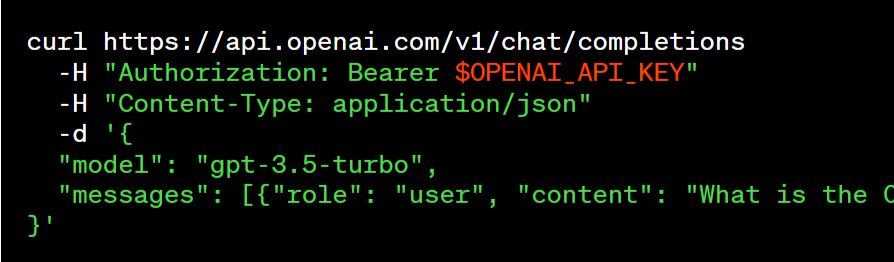

API CHATGPT

Operai ha publicado una familia de modelos ChatGPT, llamado GPT-3.5-TURBO, que es el mismo modelo que el utilizado en el producto CHATGPT. A un precio de $ 0.002 por 1,000 tokens, el equivalente a 750 palabras, este modelo se considera mejor para muchos casos de uso no vinculados a gatos y "10 veces más barato que los modelos GPT-3.5 existentes". La firma indica que varios probadores han migrado de texto-Davinci-003 a GPT-3.5-TURBO, haciendo solo una ligera modificación a su aviso (aviso). Entre ellos, encontramos a Snap (Creador de Snapchat), Quizlet (una plataforma de aprendizaje) o Shopify.

Por lo tanto, los desarrolladores que usan el modelo GPT-3.5-Turbo tendrán la posibilidad de acceder al modelo estable y, cuando lo deseen, optan por una versión específica del modelo. OpenAi da el ejemplo de GPT-3.5-TURBO-0301, que se encargará de al menos hasta el 1 de junio. Una versión estable de GPT-3.5-TURBO debería llegar en abril.

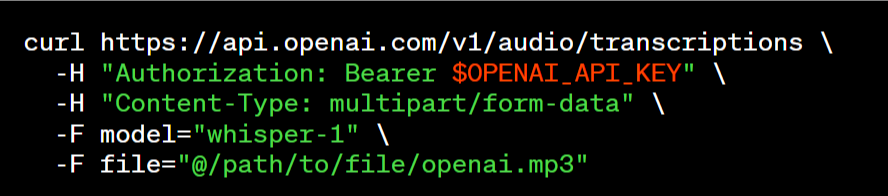

La API Whisper

Whisper, el modelo de conversión de palabras en texto (discurso a texto) pudo acceso gratuito en septiembre de 2022, también se beneficia de esta ola de cambios. “Ahora hemos puesto el modelo de V2 amplio disponible a través de nuestra API, que ofrece acceso práctico al precio de $ 0.006 / minuto. Además, nuestro montón de servidores altamente optimizados garantiza un rendimiento más rápido que el de otros servicios ”, dice la nueva empresa.

Esta API está disponible a través de diferentes puntos de acceso a transcripciones (transcripción en el idioma de origen) o traducciones (transcripción en inglés), y acepta una variedad de formatos (M4A, MP3, MP4, MPEG, MPGA, WAV, WebM).

Al dirigirse a los desarrolladores, la empresa indica que ha realizado cambios concretos en diferentes niveles. Por lo tanto, los datos enviados a través de la API ya no se usan para mejorar los servicios (incluida la capacitación del modelo), a menos que la empresa decida lo contrario. Por razones de seguridad, se ha implementado una política de preservación de datos predeterminada de 30 días para los usuarios de API, con opciones de conservación más estrictas dependiendo de las necesidades. El examen preliminar en el lanzamiento también se elimina y se mejora la documentación destinada a los desarrolladores. Finalmente, OpenAI especifica que en términos de propiedad de datos, "los usuarios son propietarios de los datos de entrada y salida de los modelos".

Instancias dedicadas de Azure

Al mismo tiempo, OpenAI intrótica de instancias dedicadas para los usuarios que desean un control más profundo de la versión específica del sistema y el rendimiento del sistema. Por defecto, las solicitudes se ejecutan en una infraestructura de cálculo compartida con otros usuarios, que pagan por solicitud. Las API operan en Azure y, con las instancias dedicadas, los desarrolladores pagan por tiempo de tiempo por una asignación de infraestructura reservada para el procesamiento de sus solicitudes. Por lo tanto, los desarrolladores tienen un control total sobre la carga de la instancia (una carga más alta mejora el flujo pero ralentiza cada solicitud), la posibilidad de activar funciones, como los límites de contexto más largos y la posibilidad de fijar la instantánea del modelo.

Otras noticias que te pueden interesar