Nvidia SAP anunció ayer una alianza ampliada para brindarles a los clientes el procesamiento acelerado que necesitan para adoptar modelos de lenguaje grandes (LLM) e IA generativa a escala. Como parte de la alianza, SAP integrará el servicio de IA generativa de Nvidia, incluidos los microservicios de inferencia NIM anunciados recientemente en GTC 2024, en la cartera de aplicaciones empresariales, RISE with SAP, Datasphere y Business Technology Platform (BTP) del proveedor alemán. “Estamos integrando IA en nuestras aplicaciones empresariales de una manera que los clientes de la nube puedan usar fácilmente como un servicio, listo para usar”, dijo Philipp Herzig, director de inteligencia artificial (CAIO) de SAP. Herzig señala que SAP tiene un amplio ecosistema de socios y diversos proveedores de LLM, y que surgen nuevos LLM casi a diario. “La idea es hacer que los clientes no tengan que preocuparse por la complejidad”, agregó. En última instancia, los clientes quieren la mejor experiencia, el mejor rendimiento o el precio más bajo para usar LLM en sus flujos de trabajo. SAP está utilizando los servicios de Nvidia, incluida la supercomputadora de inteligencia artificial DGX Cloud, el software AI Enterprise y los modelos AI Foundation, para agregar nuevas capacidades al centro de inteligencia artificial generativa en AI Core y Datasphere de SAP.

RAG al servicio de Joule

Nvidia NeMo Retriever, un microservicio de recuperación semántica presentado en noviembre pasado que ayuda a las aplicaciones GenAI a proporcionar respuestas más precisas a través de la generación aumentada por recuperación (RAG), aumentará el copiloto Joule de SAP. RAG potencia a los LLM al brindarles la capacidad de hacer referencia a bases de conocimiento autorizadas fuera de sus datos de capacitación. "Hay toneladas de documentos que no viven en un sistema SAP", señaló Herzig. Los ejemplos incluyen políticas de RR.HH., políticas de viajes, documentos de cumplimiento, documentos legales y más, que pueden estar en SharePoint o un portal. Joule ya puede responder preguntas simples como "¿Cuántas vacaciones me quedan?" a partir del registro de un empleado. Pero el microservicio de Nvidia lleva a Joule un paso más allá al brindarle acceso a las políticas de RR.HH. y compararlas con el registro del empleado.

Funciones para científicos de datos y desarrolladores

La asociación también explora más de 20 casos de uso de GenAI para ayudar a los clientes a simplificar la transformación digital, incluida la automatización de ERP con conciliación inteligente de facturas en S/4HANA Cloud, la mejora de los casos de uso de RR.HH. a través de SuccessFactors y el uso de las capacidades GenAI de Signavio para procesar recomendaciones comerciales y optimizar los procesos de soporte al cliente. Además, SAP está aprovechando las plataformas de computación acelerada de Nvidia y el software de ciencia de datos de AI Enterprise, incluidos Rapids, Rapids cuDF y cuML, para brindar a los científicos un acceso más fácil a los datos y mejorar el rendimiento de las cargas de trabajo de ML en Datasphere. Además, los servicios de IA de Nvidia ayudarán a los desarrolladores a crear código de lenguaje específico del dominio y refinar los LLM para escribir código en el lenguaje de Programación de aplicaciones empresariales avanzadas (ABAP) de SAP. "Una gran cantidad de código heredado se escribió en este lenguaje de programación llamado ABAP, y resulta que los grandes modelos de lenguaje generalmente no son adecuados para ABAP", dijo Herzig. "Si bien los LLM estándar pueden producir código ABAP que habría sido aceptable en la década de 1990, no se adaptan a los principios de diseño modernos de ABAP Cloud", afirmó.

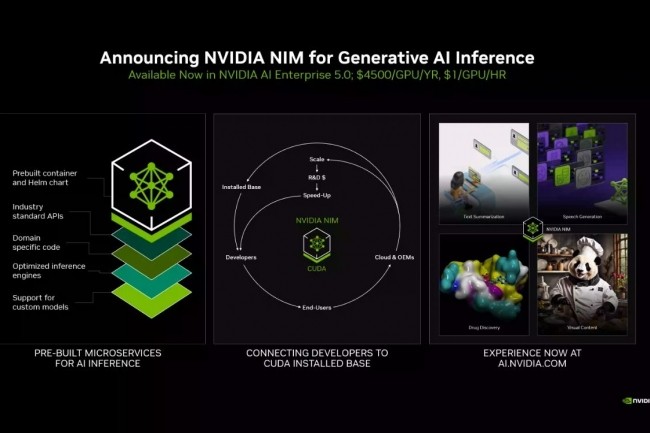

“La generación de código no funciona realmente con RAG”, añadió Kari Ann Briski, vicepresidenta de gestión de productos de software de IA generativa en Nvidia. “No se puede tomar el código, copiarlo y escribirlo. El código generativo realmente tiene que surgir de conocer el lenguaje y poder crearlo para obtener un mensaje natural”. Por último, los microservicios de inferencia NIM de Nvidia, también anunciados ayer, ayudarán a los clientes a optimizar el rendimiento de la inferencia en su infraestructura SAP. “Se trata básicamente de microservicios prediseñados de Nvidia para una variedad de modelos: modelos de ecosistema abierto, modelos propietarios, algunos modelos de Nvidia, modelos de pequeñas empresas emergentes hasta grandes nubes”, dijo Manuvir Das, vicepresidente de informática empresarial en Nvidia. “Tomamos el modelo y lo ensamblamos con los motores que están optimizados para esos modelos para que se ejecuten de la manera más eficiente posible en una variedad de GPU de Nvidia que puede encontrar en computadoras portátiles o estaciones de trabajo, centros de datos o nubes”.

Otras noticias que te pueden interesar