Nvidia sube la apuesta en el juego de chips de IA con la nueva arquitectura Blackwell

hace 1 año

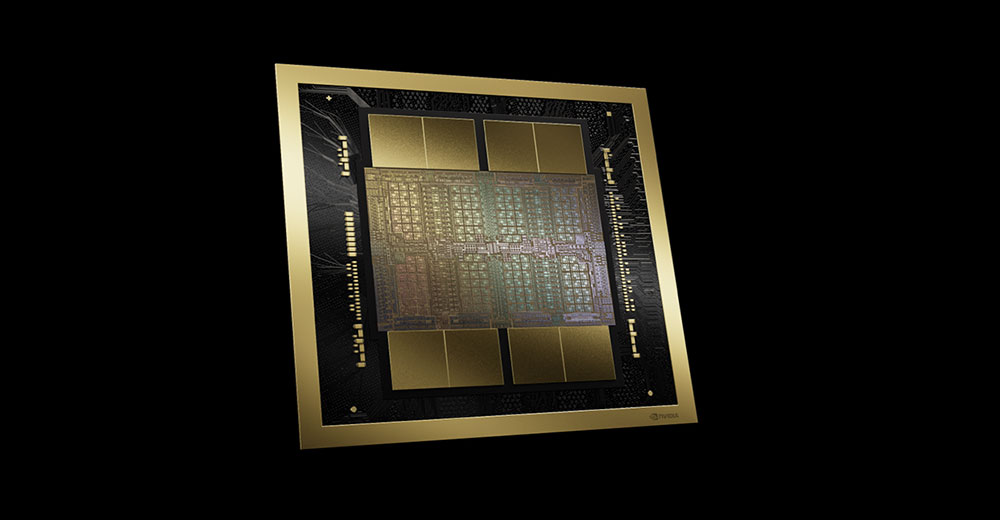

Nvidia está aumentando la potencia de su línea de chips de inteligencia artificial con el anuncio el lunes de su arquitectura de GPU Blackwell en su primera Conferencia de Tecnología de GPU (GTC) en persona en cinco años.

Según Nvidia, el chip, diseñado para usarse en grandes centros de datos (del tipo que impulsan a AWS, Azure y Google) ofrece 20 PetaFLOPS de rendimiento de IA, lo que lo hace 4 veces más rápido en cargas de trabajo de entrenamiento de IA, 30 veces más rápido en cargas de trabajo de inferencia de IA y hasta 25 veces más eficiente energéticamente que su predecesor.

En comparación con su predecesor, el H100 “Hopper”, el B200 Blackwell es más potente y eficiente energéticamente, según Nvidia. Para entrenar un modelo de IA del tamaño de GPT-4, por ejemplo, se necesitarían 8.000 chips H100 y 15 megavatios de potencia. Para esa misma tarea se necesitarían solo 2.000 chips B200 y cuatro megavatios de potencia.

"Este es el primer gran avance de la compañía en diseño de chips desde el debut de la arquitectura Hopper hace dos años", escribió Bob O'Donnell, fundador y analista jefe de Technalysis Research, en su boletín semanal de LinkedIn.

Ejercicio de reempaquetado

Sin embargo, Sébastien Jean, director de tecnología de Phison Electronics, una empresa de electrónica taiwanesa, calificó el chip como “un ejercicio de reempaquetado”.

“Es bueno, pero no es revolucionario”, dijo a TechNewsWorld. “Funcionará más rápido, consumirá menos energía y permitirá realizar más cálculos en un área más pequeña, pero desde la perspectiva de un tecnólogo, simplemente lo redujeron a un tamaño menor sin cambiar realmente nada fundamental”.

“Eso significa que sus competidores pueden replicar fácilmente sus resultados”, afirmó. “Aunque ser el primero tiene su valor porque, mientras la competencia se pone al día, uno pasa a lo siguiente”.

"Cuando se fuerza a la competencia a un juego permanente de ponerse al día, a menos que tenga un liderazgo muy fuerte, caerá en una mentalidad de 'seguidor rápido' sin darse cuenta", dijo.

“Al ser agresivos y ser los primeros”, continuó, “Nvidia puede consolidar la idea de que son los únicos verdaderos innovadores, lo que impulsa una mayor demanda de sus productos”.

Aunque Blackwell puede ser un ejercicio de reorganización, agregó, tiene un beneficio neto real. “En términos prácticos, las personas que usan Blackwell podrán realizar más cálculos con mayor rapidez con el mismo presupuesto de energía y espacio”, señaló. “Eso permitirá que las soluciones basadas en Blackwell superen a la competencia”.

Compatible con enchufes anteriores

O'Donnell afirmó que el motor de transformación de segunda generación de la arquitectura Blackwell es un avance significativo porque reduce los cálculos de punto flotante de IA de ocho bits a cuatro bits. "En términos prácticos, al reducir estos cálculos de 8 bits en generaciones anteriores, pueden duplicar el rendimiento computacional y los tamaños de modelo que pueden admitir en Blackwell con este único cambio", dijo.

Los nuevos chips también son compatibles con sus predecesores. “Si ya tienes sistemas de Nvidia con el H100, Blackwell es compatible con el sistema”, observó Jack E. Gold, fundador y analista principal de J.Gold Associates, una empresa de asesoría informática de Northborough, Massachusetts.

“En teoría, se podrían desconectar los H100 y conectar los Blackwell”, dijo a TechNewsWorld. “Aunque se puede hacer en teoría, es posible que no se pueda hacer económicamente”. Por ejemplo, el chip H100 de Nvidia cuesta entre 30.000 y 40.000 dólares cada uno. Aunque Nvidia no reveló el precio de su nueva línea de chips de IA, es probable que los precios se mantengan en esa línea.

Gold añadió que los chips Blackwell podrían ayudar a los desarrolladores a producir mejores aplicaciones de IA. “Cuantos más puntos de datos se puedan analizar, mejor será la IA”, explicó. “Lo que Nvidia pretende con Blackwell es que, en lugar de poder analizar miles de millones de puntos de datos, se puedan analizar billones”.

En la GTC también se anunciaron los microservicios de inferencia de Nvidia (NIM). “Las herramientas NIM están construidas sobre la plataforma CUDA de Nvidia y permitirán a las empresas incorporar aplicaciones personalizadas y modelos de IA preentrenados en entornos de producción, lo que debería ayudar a estas empresas a llevar nuevos productos de IA al mercado”, escribió el martes Brian Colello, estratega de acciones de Morningstar Research Services, en Chicago, en una nota de analista.

Ayudando a implementar la IA

“Las grandes empresas con centros de datos pueden adoptar nuevas tecnologías rápidamente e implementarlas más rápido, pero la mayoría de los seres humanos trabajan en pequeñas y medianas empresas que no tienen los recursos para comprar, personalizar e implementar nuevas tecnologías. Cualquier cosa como NIM que pueda ayudarlos a adoptar nuevas tecnologías e implementarlas más fácilmente será un beneficio para ellos”, explicó Shane Rau, analista de semiconductores de IDC, una empresa de investigación de mercado global.

“Con NIM, encontrará modelos específicos para lo que desea hacer”, dijo a TechNewsWorld. “No todo el mundo quiere hacer IA en general. Quieren hacer IA que sea específicamente relevante para su empresa o negocio”.

Si bien NIM no es tan emocionante como los últimos diseños de hardware, O'Donnell señaló que es significativamente más importante a largo plazo por varias razones.

“En primer lugar”, escribió, “se supone que hará que sea más rápido y eficiente para las empresas pasar de los experimentos GenAI y las POC (pruebas de concepto) a la producción en el mundo real. Simplemente no hay suficientes científicos de datos y expertos en programación GenAI para todos, por lo que muchas empresas que han estado ansiosas por implementar GenAI se han visto limitadas por desafíos técnicos. Como resultado, es genial ver que Nvidia ayuda a facilitar este proceso”.

“En segundo lugar”, continuó, “estos nuevos microservicios permiten la creación de un flujo de ingresos y una estrategia comercial completamente nuevos para Nvidia, ya que se pueden licenciar por GPU/por hora (así como con otras variaciones). Esto podría resultar un medio importante, duradero y más diversificado de generar ingresos para Nvidia, por lo que, aunque es pronto, será importante estar atento a esto”.

Líder arraigado

Rau predijo que Nvidia seguirá siendo la plataforma de procesamiento de IA preferida en el futuro previsible. “Pero competidores como AMD e Intel podrán hacerse con porciones modestas del mercado de GPU”, dijo. “Y como hay diferentes chips que se pueden usar para IA (microprocesadores, FPGA y ASIC), esas tecnologías rivales competirán por la participación en el mercado y seguirán creciendo”.

"Hay muy pocas amenazas al dominio de Nvidia en este mercado", añadió Abdullah Anwer Ahmed, fundador de Serene Data Ops, una empresa de gestión de datos en San Francisco.

“Además de su hardware superior, su solución de software CUDA ha sido la base de los segmentos de IA subyacentes durante más de una década”, dijo a TechNewsWorld.

“La principal amenaza es que Amazon, Google y Microsoft/OpenAI están trabajando en la construcción de sus propios chips optimizados en torno a estos modelos”, continuó. “Google ya tiene su chip 'TPU' en producción. Amazon y OpenAI han insinuado proyectos similares”.

“En cualquier caso, fabricar sus propias GPU es una opción que solo está al alcance de las empresas más grandes”, añadió. “La mayor parte de la industria LLM seguirá comprando GPU de Nvidia”.

Si quieres conocer otros artículos parecidos a Nvidia sube la apuesta en el juego de chips de IA con la nueva arquitectura Blackwell puedes visitar la categoría Tecnología.

Otras noticias que te pueden interesar