Llamada HGX H200, la plataforma dedicada a la IA anunciada por Nvidia utiliza aceleradores GPU H200, basados en una evolución de la arquitectura Hopper. La empresa también se está asociando con HPE para ofrecer un sistema de supercomputadora basado en sus circuitos. Tolva de gracia SuperChip GH200, creado especialmente para entrenar IA generativa. El creciente interés empresarial en la IA ha impulsado la demanda de GPU de Nvidia para tareas generativas de IA y cargas de trabajo informáticas de alto rendimiento. La GPU H200 es una de las primeras en utilizar memoria HBM3e de gran ancho de banda (Memoria de alto ancho de banda), un 50% más rápido que el actual HBM3. Esto puede ofrecer 141 GB de memoria a 4,8 terabytes por segundo, el doble de capacidad y 2,4 veces el ancho de banda que la GPU A100 anterior. En agosto pasado, Nvidia presentó el primer procesador que utiliza el HBM3e con la plataforma Grace Hopper Superchip GH200. En ese momento, el fundador y director ejecutivo de la compañía, Jensen Huang, dijo que esta "GPU tiene como objetivo satisfacer la creciente demanda de IA generativa".

"La introducción de la GPU H200 mejorará aún más el rendimiento", dijo también la compañía en un comunicado, añadiendo que, en comparación con la versión H100, esta arquitectura casi duplicará la velocidad de inferencia en el LLM Llama-2 de Meta, que tiene 70 mil millones de parámetros. Estos se relacionan con cómo se configuran las redes neuronales. "Desarrollar inteligencia con aplicaciones de IA generativa y HPC requiere procesar cantidades masivas de datos de manera eficiente y a alta velocidad utilizando una memoria GPU grande y rápida", dijo Ian Buck, vicepresidente del grupo de hiperescala y HPC de Nvidia, en un comunicado de prensa que acompaña el anuncio. "Con la GPU H200, la plataforma de supercomputación de IA de extremo a extremo más capaz de la industria se ha vuelto más rápida para resolver algunos de los mayores desafíos del mundo".

Una capacidad de 32 petaflops

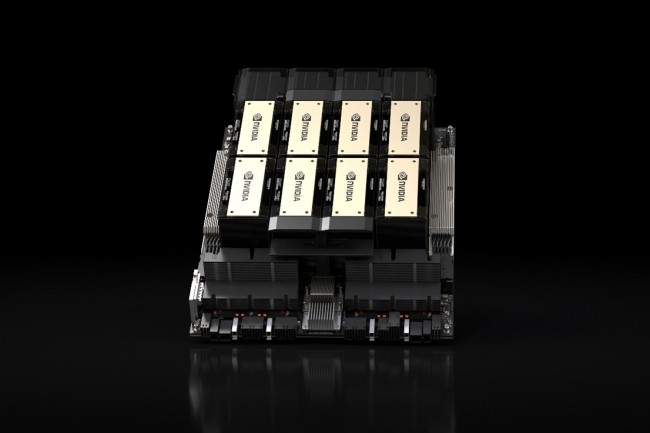

Se espera que Nvidia comience a distribuir estos sistemas HGX basados en H200 en el segundo trimestre de 2024. El H200 Tensor Core estará disponible en placas de servidor HGX H200 con configuraciones de cuatro y ocho carriles. "Un HGX H200 de ocho carriles proporciona más de 32 petaflops para computación de aprendizaje profundo FP8 y 1,1 TB de memoria agregada de alto ancho de banda para el mayor rendimiento en aplicaciones de IA generativa y HPC", dijo Nvidia. Una computadora de 1 petaflop puede calcular al menos mil billones o cuatrillones de operaciones de punto flotante por segundo. FP8 es una especificación de formato de punto flotante de ocho bits. Facilita el intercambio de redes de aprendizaje profundo entre plataformas de hardware. El H200 se puede implementar en cualquier tipo de centro de datos, local, en la nube, en la nube híbrida y en el borde. También estará disponible con la plataforma Grace Hopper Superchip GH200, que combina chips ARM y GPU.

Superchips Grace Hopper GH200 para entrenar la IA de HPE

Dos semanas después de revelar que la supercomputadora Isambard-AI del Reino Unido se construiría con la tecnología de supercomputadora Cray EX de HPE y estaría impulsada por los superchips Grace Hopper GH200, las dos compañías se han asociado nuevamente para ofrecer un sistema de supercomputadora llave en mano que respalde el desarrollo de IA generativa. El sistema incluye software de aprendizaje automático e inteligencia artificial preconfigurado y probado, así como supercomputadoras refrigeradas por líquido con redes, almacenamiento y servicios. Basada en la misma arquitectura que Isambard-AI, la solución se integrará con la tecnología de supercomputadora HPE Cray y estará impulsada por los superchips Grace Hopper GH200, lo que acelerará de 2 a 3 veces el entrenamiento de modelos de IA para centros de datos. Investigación en IA y grandes empresas. “En conjunto, esta solución proporciona a las empresas la escala y el rendimiento sin precedentes necesarios para grandes cargas de trabajo de IA, como el entrenamiento de grandes modelos de lenguaje (Modelo de lenguaje grande, LLM) y modelos de recomendación de aprendizaje profundo (Modelo de recomendación de aprendizaje profundo, DLRM)”, dijo HPE en un comunicado. El sistema estará disponible de forma general en diciembre a través de HPE en más de 30 países.

Otras noticias que te pueden interesar