Con motivo de Computex 2024, en Taiwán del 4 al 7 de junio con conferencias de prensa previas, Nvidia presentó los sistemas HPC GB200 NLV2 basados en Su arquitectura de GPU Blackwell que, según afirma, permitirá a las empresas "construir fábricas de IA y centros de datos para impulsar la próxima ola de innovación de IA generativa". La plataforma de servidor modular MGX del proveedor, anunciada el año pasado en Computex 2023, ahora es compatible con los productos Blackwell. Los servidores MGX anunciados en la feria de Taiwán cuentan con una o más GPU Blackwell, procesadores x86 o Arm basados en Grace y refrigeración por aire o líquido para cumplir con los requisitos de la aplicación.

En una conferencia de prensa previa al evento, Nvidia destacó la plataforma GB200 NVL2, una versión más pequeña de la GB200 NVL72 presentada en marzo que acelerará el procesamiento de datos hasta 18 veces, con 8 veces la eficiencia energética en comparación con el uso de procesadores x86, gracias a la arquitectura de chip Grace y las GPU Blackwell. Esta última, anunciada en el evento GTC de Nvidia en marzo, es la sucesora de la arquitectura de GPU Hopper, mientras que Grace es su diseño de procesador basado en Arm. Los sistemas GB200 contienen GPU Blackwell y CPU Grace. "La plataforma GB200 NVL2 lleva la era de GenAI a todos los centros de datos", dijo Dion Harris, director de computación acelerada en Nvidia, durante la conferencia de prensa. El proveedor dijo que otros 10 socios ahora ofrecen sistemas con la arquitectura Blackwell. ASRock Rack, Asus, Gigabyte, Ingrasys, Inventec, Pegatron, QCT, Supermicro, Wistron y Wiwynn proporcionarán sistemas para inteligencia artificial en la nube, local, integrada y de borde utilizando sus GPU y redes.

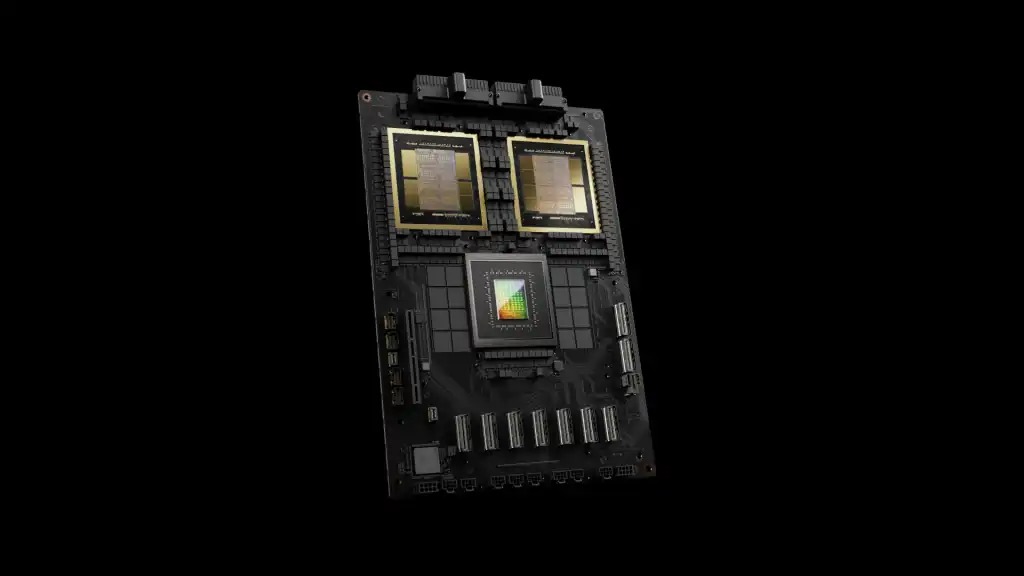

Las tarjetas GB200 combinan un chip Grace (basado en Arm) y GPU Blackwell. (Crédito Nvidia)

“Nvidia ha liderado y dado forma a la arquitectura y la infraestructura fundamentales necesarias para impulsar las innovaciones en IA”, afirmó en un correo electrónico Thomas Randall, director de investigación de mercado de IA en Info-Tech Research Group. “Los anuncios de hoy refuerzan esa afirmación, con la tecnología de Nvidia integrada en el corazón de la fabricación informática, las fábricas de IA y haciendo que la IA generativa sea ampliamente accesible para los desarrolladores”.

Ansiedad por el desempeño

Sin embargo, ese desempeño traerá nuevas preocupaciones para los administradores de centros de datos, dijo Alvin Nguyen, analista principal de Forrester. “Espero que los sistemas alimentados por Blackwell sean la opción preferida para los aceleradores de IA, al igual que los aceleradores Nvidia anteriores”, dijo Nguyen en un correo electrónico. “Las variantes de mayor potencia requerirán refrigeración líquida, y eso impulsará cambios en el mercado de centros de datos: no todos los centros de datos se pueden actualizar para proporcionar la energía y el agua necesarias para respaldar estos sistemas en grandes cantidades. Eso impulsará los gastos de actualizaciones de centros de datos, construcciones de centros de datos, asociaciones (coubicación, servicios en la nube) y la adopción por parte de competidores de aceleradores que consumen menos energía”.

En el frente de redes, Nvidia anunció que Espectro-XSu acelerador de red Ethernet que combina en particular su conmutador Spectrum-4 y su tarjeta SmartNIC BlueField-3, El nuevo chip diseñado para nubes de IA que se presentó en Computex el año pasado ya está disponible. Además, Amit Katz, vicepresidente de redes de Nvidia, dijo que el proveedor está acelerando el ritmo de las actualizaciones: cada año se lanzarán productos que ofrecerán mayor ancho de banda y puertos, así como conjuntos de funciones de software mejorados y mayor programabilidad.

La arquitectura de la plataforma, con sus DPU (unidades de procesamiento de datos) optimizadas para el tráfico norte-sur y su SuperNIC optimizada para el tráfico este-oeste, GPU a GPU, tiene sentido, señaló Nguyen de Forrester, pero agrega complejidad. “Es una solución complementaria que ayudará a impulsar la adopción de soluciones de IA más grandes como SuperPods y fábricas de IA”, dijo. “Hay una complejidad adicional en el uso de esto, pero en última instancia ayudará a los clientes de Nvidia que están implementando infraestructura de IA a escala”. Pero, agregó, “Nvidia está impulsando la infraestructura de IA con otro estándar tecnológico que eventualmente será propietario, pero necesitan hacerlo para mantenerse por delante de la competencia”.

Otras noticias que te pueden interesar