Nvidia multiplica los aceleradores para la IA

hace 2 años

Todo el hardware y software anunciado por Nvidia como parte de su conferencia de desarrolladores Nvidia GCT -GPU Technology Conference- organizada del 20 al 23 de marzo, estuvo centrado en la IA.

En la Conferencia de desarrolladores de GCT, el primer anuncio importante de hardware de Nvidia fue para la Unidad de procesamiento de datos (DPU) de red BlueField-3, destinada a descargar las tareas de procesamiento de red de la CPU. BlueField es una tarjeta de red similar a SmartNIC que resultó de la adquisición de Mellanox por parte de Nvidia en 2019. BlueField-3 tiene el doble de núcleos de CPU Arm que el producto de la generación anterior y, en general, más aceleradores para ejecutar cargas funcionan hasta ocho veces más rápido. BlueField-3 puede acelerar las cargas de trabajo de red locales y en la nube para cargas de trabajo de IA y computación de alto rendimiento en un entorno híbrido. Según Kevin Durling, vicepresidente de redes de Nvidia, la descarga de operaciones colectivas de MPI de Bluefield desde la CPU aumenta la velocidad en casi un 20 %, lo que ahorra 18 millones de dólares en supercomputadoras a gran escala. Oracle es el primer proveedor de servicios en la nube que ofrece aceleración BlueField-3 en su servicio Oracle Cloud Infrastructure (OCI) con el servidor en la nube DGX de Nvidia. Cisco, Dell EMC, DDN, Juniper, Palo Alto Networks, Red Hat y VMware se encuentran entre los principales socios de BlueField-3.

Un acelerador universal para video o IA

La tarjeta L4 es uno de los primeros productos basados en GPU anunciados por Nvidia. Esta tarjeta, que sucede a la tarjeta Nvidia T4, utiliza refrigeración pasiva y no requiere un conector de alimentación. Según la descripción de Nvidia, la tarjeta L4 es un acelerador universal para video, inteligencia artificial y gráficos. Como placa de bajo perfil, se adapta a cualquier servidor, convirtiendo cualquier plataforma en un centro de datos de IA. La tarjeta L4 está específicamente optimizada para video AI con aceleradores para codificación y decodificación. Nvidia afirma que esta GPU es cuatro veces más rápida que la versión T4 anterior, 120 veces más rápida que un sistema de CPU tradicional, consume un 99 % menos de energía que un servidor de CPU y puede decodificar 1040 transmisiones de video desde diferentes terminales móviles. Google será el socio de lanzamiento de este mapa, con el L4 apoyando los servicios generativos de inteligencia artificial disponibles para los clientes de GCP. El H100 NVL es otro producto basado en GPU de Nvidia. En realidad, son dos procesadores H100 en una sola placa. Estas dos GPU funcionan como una sola para implementar modelos de lenguaje grandes y modelos de inferencia GPT con 5 mil millones a 200 mil millones de parámetros, que es 12 veces más rápido que el rendimiento de un procesador x86, según Nvidia.

Más detalles sobre DGX Cloud

Nvidia proporcionó un poco más de detalles sobre DGX Cloud, sus sistemas de IA alojados por proveedores de servicios en la nube, incluidos Microsoft Azure, Google Cloud y Oracle Cloud Infrastructure. El mes pasado, el CEO de Nvidia, Jensen Huang, anunció previamente el servicio durante una conferencia telefónica de ganancias con analistas, pero no dio muchos detalles al respecto. DGX Cloud no es solo hardware, también es una pila de software completa que convierte a DGX Cloud en una oferta de capacitación de IA llave en mano como servicio. Simplemente señale el conjunto de datos que desea entrenar, indique dónde deben ir los resultados y la plataforma estará en funcionamiento. Las instancias de DGX Cloud comienzan en $ 36,999 por instancia por mes. También será posible comprar e implementar DGX Cloud en las instalaciones.

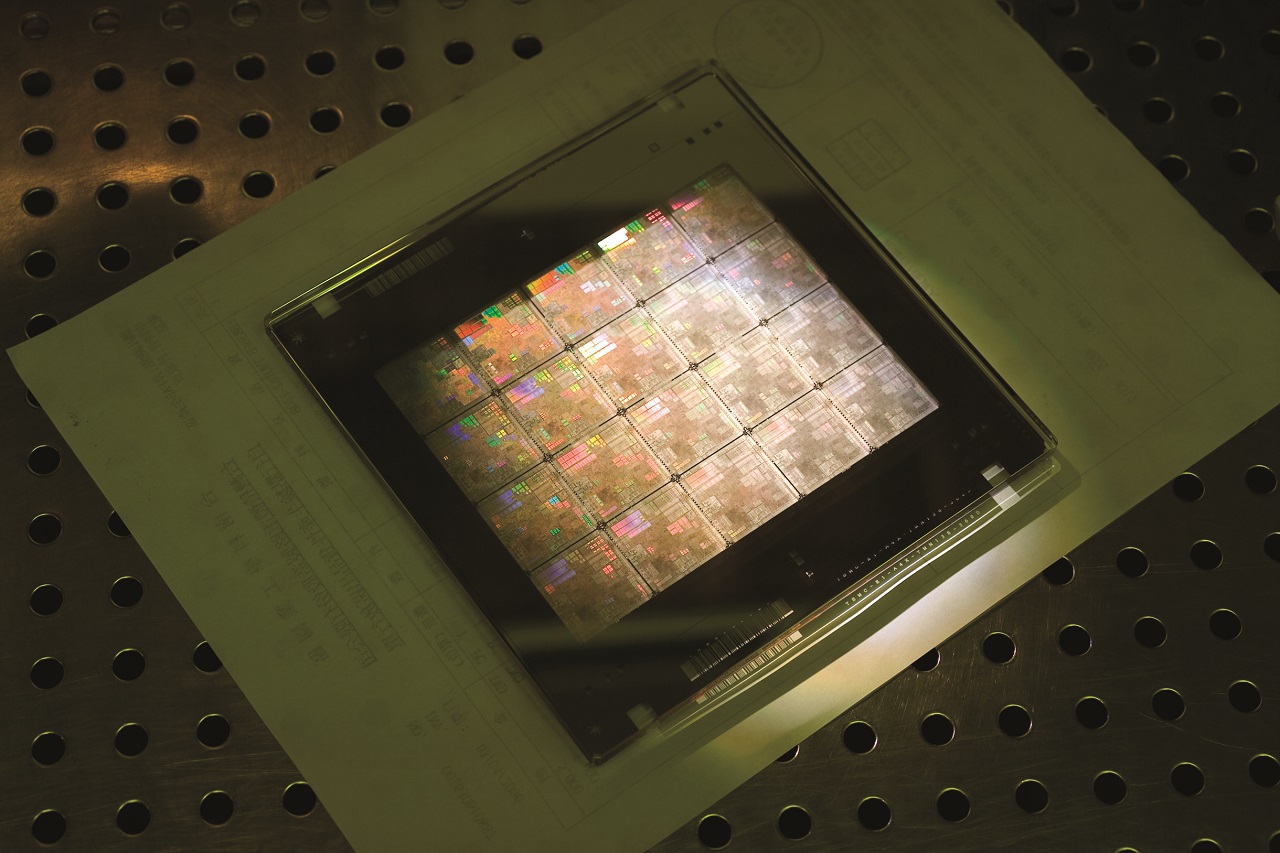

Para acelerar los cálculos en litografía, Nvidia ha desarrollado una solución llamada cuLitho utilizando recursos GPU. (Crédito Nvidia)

Primeros pasos en la litografía de chips

La fabricación de chips no es un proceso insignificante cuando se trata de producir transistores cuyo tamaño se mide en nanómetros. Llamado litografía o fotografía computacional, el proceso de fabricación de chips consiste en imprimir patrones de chips creados en una computadora en una pieza de silicio. A medida que los chips se vuelven cada vez más pequeños, se necesita más procesamiento informático para crear las imágenes. Hoy en día, centros de datos completos están dedicados al procesamiento de fotografías computacionales. Nvidia ha ofrecido una solución llamada cuLitho cuyos algoritmos pueden acelerar los cálculos subyacentes a la fotografía computacional. Hasta ahora, utilizando la arquitectura Hopper, Nvidia ha demostrado que los cálculos son 40 veces más rápidos. 500 sistemas Hopper (4000 GPU) pueden hacer el trabajo de 40 000 sistemas de CPU utilizando una octava parte del espacio y una novena parte de la energía. Un diseño de chip que normalmente tardaría dos semanas en procesarse ahora puede procesarse durante la noche. Por lo tanto, el tiempo de procesamiento y creación de los chips se reduce significativamente. Una fabricación más rápida significa más suministro y, con suerte, precios más bajos. Los fabricantes ASML, TSMC y Synopsys son los primeros clientes de la solución cuLitho, cuya producción está prevista para junio de 2023.

Si quieres conocer otros artículos parecidos a Nvidia multiplica los aceleradores para la IA puedes visitar la categoría Otros.

Otras noticias que te pueden interesar