Microsoft presenta sus chips Cobalt y Maia para IA y la nube

hace 2 años

Frente a AWS y Google Cloud, Microsoft se está equipando con chips de su propio tamaño para la IA y la nube. Revelados en la conferencia Ignite, se llaman Maia y Cobalt.

Después de meses de especulaciones sobre el posible desarrollo de chips internos por parte de Microsoft, la compañía presentó ayer dos componentes personalizados en su conferencia anual Ignite celebrada del 14 al 17 de noviembre en Seattle. Llamados Maia y Cobalt, estos chips apuntan a cargas de trabajo de IA generativa y nube, respectivamente. Según Microsoft, el acelerador Maia 100 apoyará el entrenamiento de modelos de IA, en particular los de OpenAI, para hacerlos más eficientes a un costo menor.

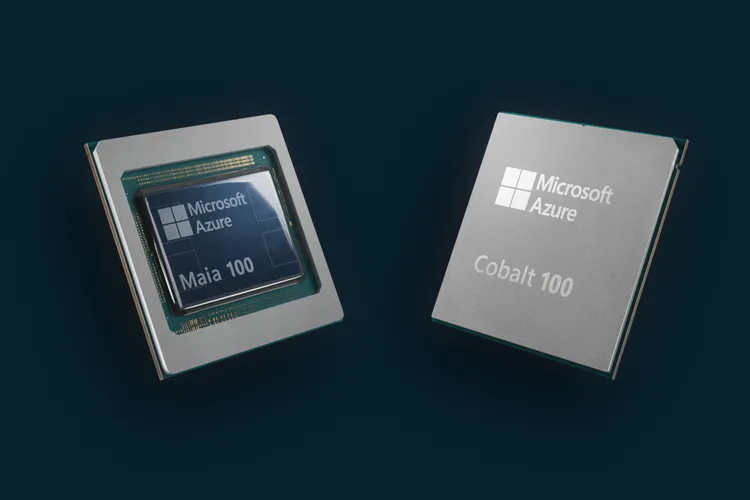

Una arquitectura ARM para el chip Cobalt 100

El chip Cobalt 100 tiene 128 núcleos y fue diseñado con la arquitectura ARM Neoverse CSS. Microsoft lo probó para cargas de trabajo de Teams y SQl Server. Según Dylan Patel, la elección de esta arquitectura “tiene como objetivo hacer que la infraestructura de Microsoft sea más eficiente energéticamente en comparación con las CPU de AMD e Intel”.

Con este chip, la firma de Redmond se suma también a la competencia donde AWS lanza desde hace varios años sus instancias Graviton (también sobre arquitectura ARM) y la TPU (Tensor Processing Unit) de Google Cloud. El número 100 sugiere que se trata de la primera edición y que la familia 200 ya está en preparación (siguiendo el ciclo de Nvidia con el H100 y el H200).

Los dos componentes presentados por Microsoft, incluido Cobalt 100. (Crédito de la foto: Microsoft)

Bastidores a medida para el acelerador Maia 100

El otro anuncio se refiere al acelerador Maia 100 para IA, grabado en 5 nm por TSMC y compuesto por 105 mil millones de transistores. Esta es la realización del proyecto Athena, que nuestros colegas The Information informaron el pasado mes de abril. Varios cientos de empleados de Microsoft se movilizaron para esta misión con una inversión específica de 2 mil millones de dólares y se rumoreaba una asociación con AMD. Durante la conferencia, la compañía explicó que había creado un diseño específico para los racks de su centro de datos para acomodar el chip Maia 100. "Son más anchos que los racks existentes para dejar más espacio para los cables de alimentación y la red", explica la empresa.

También tuvo que desarrollar una solución de refrigeración líquida independiente para gestionar la temperatura de los chips muy utilizados por la IA y las cargas de trabajo de IA generativa. Por eso Microsoft ha desarrollado un “compañero” que funciona como el radiador de un coche. “El líquido frío fluye desde el compañero hasta las placas frías adheridas a la superficie de los chips Maia 100. Cada placa tiene canales por donde fluye el líquido para absorber y transportar calor. Este líquido se dirige al compañero, que toma calor del líquido y lo envía de regreso al bastidor para absorber más calor, y así sucesivamente”, explicó un portavoz de Microsoft.

Microsoft se vio obligada a crear un rack y un sistema de refrigeración líquida específico para el acelerador Maia. (Crédito de la foto: Microsoft)

Una ecuación económica para Microsoft

Los analistas dicen que es la economía, no la escasez de chips, lo que genera el mayor interés en chips personalizados por parte de los grandes proveedores de servicios en la nube, como Microsoft, AWS y Google. “Desde un punto de vista económico, la decisión de desarrollar componentes personalizados permite a Microsoft integrar su oferta y continuar optimizando los chips para sus servicios mientras aumenta su margen y tiene un mejor control de costos y producción. disponibilidad”, dijo Daniel Newman, director ejecutivo de The Futurum Group. Según él, estas son las mismas razones que empujaron a AWS a desarrollar sus propios chips Inferentia personalizados, combinados con el acelerador de aprendizaje automático Trainium. Este es también el caso de Google, que ha desarrollado iteraciones de sus chips Tensor. “La CPU Cobalt permite a Microsoft ofrecer silicio optimizado para la nube y ofrecer instancias basadas en Arm a los clientes de Azure, tal como lo hace AWS con EC2”, dijo el ejecutivo.

Además, los analistas creen que con sus nuevos chips, Microsoft podrá crear sus propios marcos de software de aceleración de IA a medida que crezca la demanda de la tecnología. “El desarrollo de aceleradores para cargas de trabajo de IA puede mejorar el rendimiento y utilizar menos energía que otros chips, incluidas las soluciones basadas en GPU. Los proveedores y las empresas que intentan alcanzar objetivos de sostenibilidad y beneficiarse del potencial de la IA siempre buscarán aumentar el rendimiento y al mismo tiempo ser energéticamente eficientes”, afirma Daniel Newman.

Seria competencia para Nvidia, AMD e Intel

El acelerador Maia 100 de Microsoft no es lo suficientemente potente como para reemplazar las soluciones GPU de Nvidia en el desarrollo de LLM. Pero es muy adecuado para la inferencia utilizada en cargas de trabajo operativas de IA. "Además, a medida que se implementen, la empresa necesitará cada vez menos componentes de Nvidia, AMD e Intel", dijeron los analistas, añadiendo que mañana los chips personalizados de AWS y Google también competirán con los chips de los principales proveedores. "Intel, Nvidia y AMD están viendo el aumento de las instancias basadas en ARM y deberían verlas como una amenaza competitiva en algunos casos", dijo Daniel Newman. “La migración de cargas de trabajo de chips x86 a chips ARM aún no es del todo posible, en parte porque el software a menudo se escribe para arquitecturas de chips específicas. Pero se ha convertido en un problema menor a medida que los desarrolladores continúan avanzando para ejecutar más y más cargas de trabajo en ARM”, añade.

Según los analistas, a medida que los proveedores de servicios en la nube utilicen componentes personalizados en diferentes niveles, el mercado de centros de datos verá un "cambio más significativo" hacia ARM en los próximos años, a pesar de que los chips x86 dominan actualmente el mercado. mercado con un margen sustancial. De todos los proveedores de semiconductores, Daniel Newan cree que Nvidia será la menos afectada, al menos a corto plazo, ya que se espera que la demanda de sus aceleradores GPU siga siendo alta. Sin embargo, en determinados casos o casos de uso, los chips personalizados de los hiperescaladores podrían mantener una relación simbiótica con Nvidia, en particular los chips Grace Hopper, destinados al desarrollo y entrenamiento de grandes modelos de lenguaje. Se espera que el despliegue de chips personalizados en los centros de datos de Microsoft comience a principios del próximo año. Dado que Microsoft no planea vender sus chips a terceros, no se verá afectada por las restricciones impuestas por la administración del presidente estadounidense Joe Biden a las exportaciones de tecnología a China.

Si quieres conocer otros artículos parecidos a Microsoft presenta sus chips Cobalt y Maia para IA y la nube puedes visitar la categoría Otros.

Otras noticias que te pueden interesar