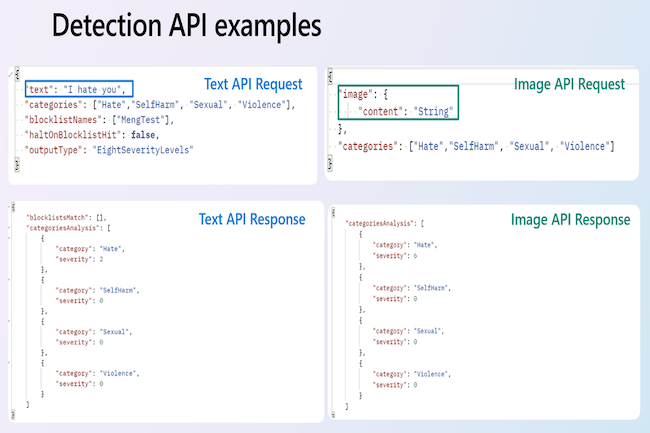

En un contexto geopolítico muy tenso en Medio Oriente con intercambios de odio en las redes sociales, microsoft anunció la disponibilidad deSeguridad del contenido de IA de Azureun servicio respaldado por recursos de inteligencia artificial que ayuda a los usuarios a detectar y filtrar contenido malicioso en aplicaciones y servicios. La solución incluye detección de texto e imágenes e identifica contenido que Microsoft clasifica como "ofensivo, riesgoso o no deseado", incluidas malas palabras, contenido para adultos, sangre, violencia y ciertos tipos de discurso de odio. "Al centrarnos en la seguridad del contenido, podemos crear un entorno digital más seguro que promueva el uso responsable de la IA y proteja el bienestar de las personas y de la sociedad en su conjunto", escribió Louise Han, directora de lanzamiento de productos de Azure Anomaly Detector, en un blog. Publicación anunciando el lanzamiento del servicio. Azure AI Content Safety tiene la capacidad de administrar varias categorías de contenido, idiomas y amenazas para moderar el contenido textual y visual. También ofrece capacidades de análisis de imágenes que utilizan algoritmos de inteligencia artificial para escanear, diseccionar y moderar contenido visual, garantizando lo que Microsoft llama medidas de seguridad integrales de 360 grados.

Texto e imagen, pero aún no vídeo y audio.

El servicio también está equipado para moderar contenido en varios idiomas y utiliza una métrica de gravedad que proporciona una gradación que va de 0 a 7. El contenido clasificado de 0 a 1 se considera seguro y apropiado para todas las audiencias, mientras que el contenido que expresa prejuicios, críticas o Las opiniones obstinadas se clasifican entre 2 y 3, o baja. El contenido de gravedad media se clasifica entre 4 y 5 y contiene lenguaje ofensivo, insultante, burlón, intimidante o ataques explícitos contra grupos de identidad, mientras que el contenido de gravedad alta, que contiene promoción dañina y explícita de actos dañinos, o respalda o glorifica formas extremas de actos dañinos. hacia grupos de identidad, tiene una calificación de 6-7.

Azure AI Content Safety también utiliza filtrado de múltiples categorías para identificar y categorizar contenido dañino en una serie de áreas críticas, incluido el odio, la violencia, la autolesión y el género. “[Quand il s’agit de sécurité en ligne]Es crucial no limitarnos al contenido generado por humanos, especialmente ahora que el contenido generado por IA se vuelve prevalente”, escribió la Sra. Han. “Es fundamental garantizar la precisión, la fiabilidad y la ausencia de elementos nocivos o inapropiados en los resultados generados por la IA. La seguridad del contenido no sólo protege a los usuarios de la desinformación y de posibles daños, sino que también defiende los estándares éticos y genera confianza en las tecnologías de IA”. Azure AI Content Safety se factura según el uso. Los usuarios interesados pueden ver las opciones de precios en Página de seguridad del contenido de Azure AI.

Otras noticias que te pueden interesar