Después de la euforia, la realidad comienza a imponerse en las capacidades de la IA generativa: sin las protecciones apropiadas, los grandes modelos de lenguaje (LLM) pueden ser terriblemente ingenuos y compartir con demasiada facilidad lo que saben. Sin embargo, tales comportamientos exponen aplicaciones construidas a partir de estos modelos y las compañías que los usan, en riesgo de piratería y enjuiciamiento por derechos de autor. Para aliviar algunos de estos riesgos, Microsoft Herramientas de seguridad agregadas a su plataforma de creación de aplicaciones, Azure AI Studio. La idea es ayudar a las empresas a saber cómo reaccionan sus principales modelos de idiomas (LLM) ante los ataques indirectos por inyección de indicaciones y verificar si incluyen información protegida en sus respuestas.

Detectar ataques de inyección de invitación

Los ataques de inyección indirectos de indicaciones, también conocidos como XPIA (ataques de inyección indirecta de inmediato), se dirigen a la fuente de datos de anclaje LLM. Estos ataques son cada vez más populares entre los piratas que buscan corromper la fuente de datos para transmitir instrucciones maliciosas ocultas al modelo para evitar sus salvaguardas de seguridad. La herramienta de Microsoft, Azure AI evalúa, es accesible a través de la interfaz Azure AI Studio o a través de la evaluación de Azure SDK. "Se utiliza para simular ataques de inyección indirectos en su modelo o aplicación generativa y para medir la frecuencia a la que no detectan y desvían ciertos ataques, por ejemplo, la intrusión del contenido manipulado o la recolección de información", escribió Minsoo Thigpen, el producto senior de la división Azure AI, En un artículo de blog.

"Si los desarrolladores creen que sus modelos no logran detener los ataques indirectos por inyección de indicaciones, pueden ajustar las fuentes de datos de anclaje o aplicar otras medidas de mitigación antes de comenzar la evaluación nuevamente para verificar si su modelo o aplicación se puede implementar en una producción segura", dijo Minsoo Thigpen. Otra característica llamada rápida Shields ayuda a los desarrolladores a detectar y bloquear o mitigar cualquier ataque de las indicaciones del usuario. "Se puede habilitar a través del servicio de servicio Azure Content Safety AI de Microsoft", agregó. Los escudos inmediatos buscan bloquear las indicaciones que pueden conducir a resultados peligrosos de IA. También puede identificar ataques de documentos cuando el contenido dañino se integra en los documentos proporcionados por el usuario. La herramienta Azure AI Evaluate y el SDK correspondiente están actualmente disponibles en una descripción general.

Gestión de contenido protegido

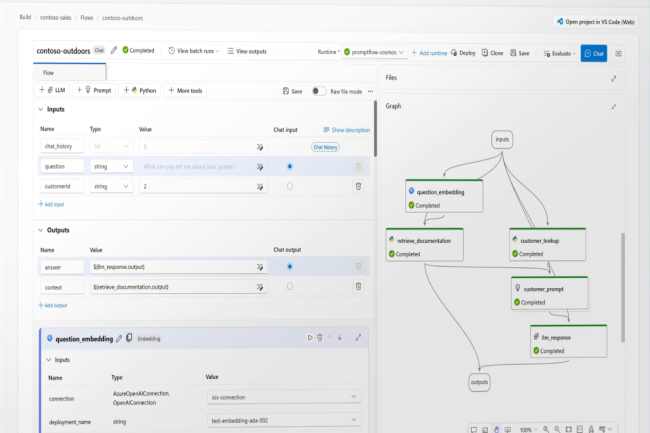

Pero el SDK de Azure AI Evalation también tiene otra función: puede probar la frecuencia a la que las aplicaciones subyacentes de LLM generan respuestas que contienen lo que el proveedor llama "material protegido", o con más precisión de equipos prohibidos, porque la categoría incluye textos protegidos por copyright cuya compañía probablemente no tiene derechos, como las palabras, las recetas y los artículos. "Para verificar esto, los resultados de la LLM se comparan con un tercer índice de contenido textual parecido en GitHub", dijo el gerente. "Los usuarios pueden analizar la evaluación en detalle para comprender mejor cómo su aplicación responde a estas indicaciones del usuario y los riesgos asociados", agrega. Se proporcionan dos API: una para señalar la versión de textos protegidos por Copyright y el otro para informar la salida del código protegido, incluidas las bibliotecas de software, el código fuente, los algoritmos y otros elementos relacionados con la programación. También se puede acceder a una descripción general de la función de prueba a través de la interfaz Azure AI Studio.

Otras características actualizadas de la evaluación de Azure SDK, también en vista previa, incluyen nuevas evaluaciones de calidad, así como un generador de datos sintéticos y un simulador para tareas no contradictorias. Estas evaluaciones de calidad, que también se incluirán en la interfaz Azure AI Studio en octubre, se basan en medidas matemáticas populares que deberían ayudar a los desarrolladores a verificar si un LLM genera resultados textuales que respetan la calidad. "Estas medidas, a saber, rojo (suplente orientado al recuerdo para la evaluación de la evaluación), Bleu (suplente de evaluación bilingüe), Gleu (Google-Bleu) y Meteor (métrica para la evaluación de la traducción con ordenes explícitos) verifique la precisión, el recuerdo y la precisión gramatical". El generador de datos sintéticos y el simulador de tareas no contradictorio deberían ayudar a los desarrolladores a verificar si su LLM cumple con los estándares deseados cuando el usuario envía un mensaje específico.

Otras noticias que te pueden interesar