“Los modelos lingüísticos (LM) tienen capacidades notables para resolver nuevas tareas de algunos ejemplos o instrucciones textuales, especialmente a gran escala. Paradójicamente, también se enfrentan a las dificultades con características básicas, como la aritmética o la búsqueda de hechos, donde los modelos mucho más simples y más pequeños. "Esta es la observación hecha por un equipo de investigadores Meta La semana pasada. Estos últimos han publicado un artículo en arxiv - El archivo abierto de las prepublicaciones electrónicas de los artículos científicos, y muestra que los modelos de idiomas pueden aprender a usar herramientas externas a través de API simples y obtener lo mejor de ambos mundos.

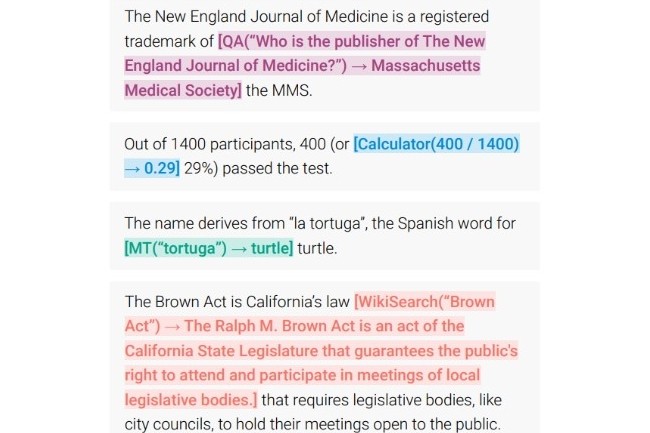

"Presentamos el formador de herramientas, un modelo capacitado para decidir qué API llama, al llamarlos, qué argumentos pasan y cómo incorporar mejor los resultados en la predicción de tokens futuros". Se especifica que este trabajo de investigación se lleva a cabo de manera auto-supervisada, lo que requiere algo más que un puñado de demostraciones para cada API y, por lo tanto, sin asesoramiento humano explícito. Para la experiencia, los investigadores han incorporado una variedad de herramientas, incluida una calculadora, un sistema de preguntas y respuestas, dos motores de búsqueda diferentes, un sistema de traducción y un calendario (los nombres de las herramientas no se han especificado). El resultado es convincente: el formador de herramientas obtiene un rendimiento significativamente mejorado para una variedad de tareas aguas abajo, a menudo en competencia con modelos mucho más grandes, sin sacrificar sus capacidades de modelado de idiomas.

GPT-3 rendimiento excedido

Como recordatorio, el formador de herramientas se basa en un modelo GPT-J (Un modelo de lenguaje causal de tipo GPT-2 formado en el conjunto de datos de la batería) previamente entrenado con 6.7 mil millones de parámetros. Los experimentos realizados por investigadores en diversas tareas que utilizan herramientas parecen demostrar que el formador de herramientas logra un rendimiento mucho mejor que el modelo GPT-3, por mucho más grande, que contiene 175 mil millones de parámetros. François Yvon, investigador del CNRS, comenta sobre la capacidad de especializar LLM mediante el fortalecimiento de los corpus específicos de datos: “En realidad, logramos especializar estos modelos, reduciendo su tamaño y llevándolos a corpus específicos de datos. Por ejemplo, realizar tareas específicas en un contexto profesional o producir textos en idiomas particulares. En el proyecto Bloom (un proyecto científico LLM realizado en una plataforma de ciencias abierta, en la que participa en gran medida la investigación francesa, incluidos los CNRS, la nota del editor), versiones más pequeñas, con 7 mil millones de parámetros contra 176 para el modelo general, por lo tanto, se han implementado. . »»

El uso de herramientas como Toolformer es sin duda un avance importante en el uso de modelos de lenguaje de IA, pero aún tiene una parte de riesgo. De hecho, la capacidad de usar API podría afectar los datos del usuario en las aplicaciones. Del mismo modo, el uso de motores de búsqueda puede ser una fuente de compartir información falsa o información errónea en ausencia de un sistema de verificación de hechos.

Otras noticias que te pueden interesar