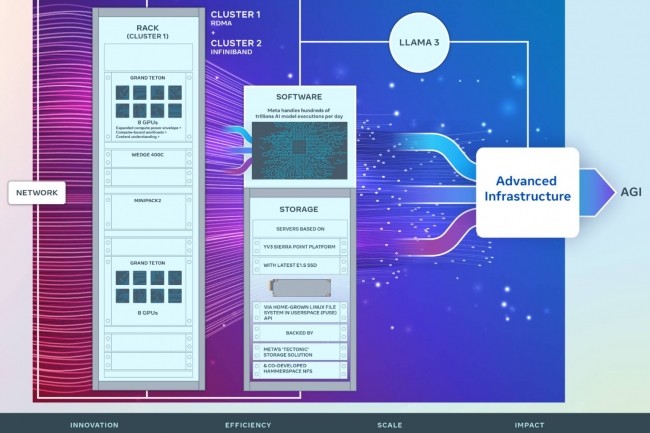

En la carrera por los tratamientos LLM, Meta Está decidido a no quedarse atrás. En una publicación de blogMeta mostró su último trabajo en infraestructura que respalda el procesamiento de IA y sus modelos de lenguaje grandes (LLM). Lo menos que podemos decir es que el proveedor ha hecho todo lo posible con dos clústeres de 24.576 aceleradores de GPU Nvidia Tensor Core H100. “Compartimos detalles sobre el hardware, la red, el almacenamiento, el diseño, el rendimiento y el software que nos permiten lograr un alto rendimiento y confiabilidad para una variedad de cargas de trabajo de IA. Estamos usando este diseño de clúster para entrenar a Llama 3”, explicar Meta. Estos clústeres se basan en Grand Teton, OpenRack y PyTorch y, según el grupo, forman parte de un enfoque de innovación abierta. En definitiva, esta infraestructura también está diseñada para satisfacer las necesidades de formación de los futuros LLM. Meta indica que se ha centrado en la eficiencia y el rendimiento en términos de redes, almacenamiento y capacidad de cómputo para satisfacer las necesidades y los casos de uso cada vez más complejos de GenAI.

En cuanto a la red, Meta diseñó un primer clúster RDMA (acceso directo a memoria remota) sobre Ethernet convergente (RoCE) basado en Arista 7800 con switches en rack OCP Wedge400 y Minipack2, el segundo está equipado con una estructura InfiniBand de Nvidia Quantum2. Ambas soluciones interconectan los puntos finales a 400 Gbps. “Con estas dos soluciones, podemos evaluar la idoneidad y escalabilidad de estos diferentes tipos de interconexión para el entrenamiento a gran escala, lo que nos permite comprender mejor cómo diseñaremos y construiremos clústeres aún más grandes y avanzados en el futuro”, afirma Meta.

Infraestructura de almacenamiento de última generación

En cuanto al almacenamiento, el proveedor ha desarrollado una API de Linux Filesystem in Userspace (FUSE) que aprovecha una versión de almacenamiento distribuido de Tectonic optimizada para sistemas basados en flash. “Esta solución permite que miles de GPU guarden y carguen puntos de control de forma sincronizada, al tiempo que proporciona un almacenamiento flexible y de alta velocidad a la escala de gigabytes necesaria para la carga de datos”, afirma Meta. “También nos hemos asociado con Hammerspace (recientemente conocido) “Para desarrollar y entregar conjuntamente un sistema de archivos de red (NFS) paralelo que cumpla con los requisitos de experiencia del desarrollador para este clúster de IA”. Con beneficios clave en términos de depuración y velocidad.

Esta infraestructura de almacenamiento se basa en un sistema de servidor Sierra Point YV3 actualizado con el último SSD E1.S de alta capacidad. “Además de la mayor capacidad de SSD, se personalizó la cantidad de servidores por rack para lograr el equilibrio adecuado entre la capacidad de rendimiento por servidor, la reducción de racks y la eficiencia energética asociada. Al utilizar servidores OCP (proyecto de computación abierta) como bloques de construcción tipo Lego, nuestra capa de almacenamiento puede adaptarse de manera flexible a los requisitos futuros de este clúster, así como a futuros clústeres de IA más grandes, al mismo tiempo que es tolerante a fallas durante las operaciones diarias de mantenimiento de la infraestructura”, explica Meta.

Meta prevé fabricar 350.000 GPU H100 para finales de 2024

La firma estadounidense también indicó que compraría más aceleradores GPU H100 de Nvidia con la intención de contar con más de 350.000 a finales de año. Estos se utilizarán para seguir desarrollando su infraestructura de IA con probablemente otros clústeres aún más potentes en los próximos meses.

“Al mirar hacia el futuro, reconocemos que lo que funcionó ayer o hoy puede no ser suficiente para las necesidades del mañana. Por eso evaluamos y mejoramos constantemente cada aspecto de nuestra infraestructura, desde las capas físicas y virtuales hasta la capa de software y más allá. Nuestro objetivo es crear sistemas flexibles y confiables para respaldar la rápida evolución de nuevos modelos e investigaciones”, concluye el grupo.

Otras noticias que te pueden interesar