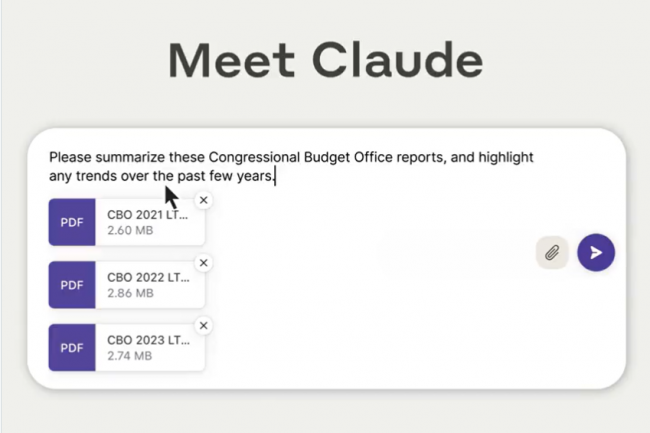

Esta semana, Anthropic anunció que su plantilla Claude 2.1 recién lanzada tiene una ventana emergente de 200.000 tokens, el equivalente a unas 500.000 palabras o más de 500 páginas impresas, según Anthropic, mucho más que la cantidad de información de un modelo de lenguaje grande. (LLM) como GPT-4 se pueden ingerir al mismo tiempo. "La última versión de Claude también es más precisa que su predecesora, tiene un precio más bajo e incluye el uso de una herramienta beta". la empresa también indicó. Este modelo impulsa el chatbot de IA generativa Claude de Anthropic, por lo que tanto los usuarios gratuitos como los pagos pueden aprovechar la mayoría de las mejoras en la iteración 2.1. Sin embargo, la ventana emergente de 200.000 tokens es solo para usuarios Pro pagos, mientras que los gratuitos todavía están limitados a 100.000 tokens, lo que es significativamente más alto que los 16.000 tokens de GPT-3.5. La función de herramienta beta de Claude 2 permitirá a los desarrolladores integrar API y funciones definidas en el modelo Claude, similar a lo que está disponible en los modelos OpenAI. Hasta el mes pasado, la ventana emergente de 100.000 tokens de Claude era significativamente superior a OpenAI en esta área, cuando OpenAI anunció una versión preliminar de GPT-4 Turbo con una ventana emergente de 128.000 tokens. Sin embargo, sólo los clientes de ChatGPT Plus con una suscripción de $20 por mes pueden acceder a este modelo de chatbot. (Se ofrece a los desarrolladores un pago por uso para acceder a la API GPT-4).

Aunque una ventana emergente grande (la cantidad de datos que puede manejar a la vez) parece atractiva para un documento grande u otra información, no está claro que los LLM puedan manejar grandes cantidades de datos y solo información en cantidades más pequeñas. Greg Kamradtun experto en inteligencia artificial y empresario familiarizado con el tema, realizó lo que él llama un análisis de "aguja en un pajar" para ver si realmente se encuentran pequeños fragmentos de información en un documento grande al consultar el LLM. Este último repitió las pruebas insertando una declaración aleatoria en diferentes partes de un documento grande que ingresó al LLM y consultó. "Con 200.000 tokens (casi 470 páginas), Claude 2.1 pudo recordar hechos en cierta profundidad de documento", publicó en X (anteriormente Twitter), señalando que había obtenido acceso temprano a Claudius 2.1. "A partir de alrededor de 90.000 tokens, el rendimiento de recuperación en la parte inferior del documento comenzó a degradarse cada vez más". GPT-4 tampoco logró una recuperación perfecta en su contexto más amplio.

La mitad de información falsa con Claude 2.1

Ejecutar las pruebas en Claude 2.1 costó alrededor de $1,000 en llamadas API (Anthropic ofreció créditos para que Greg Kamradt pudiera ejecutar las mismas pruebas que hizo en GPT-4). En sus conclusiones indica que "la forma en que se diseñan las indicaciones es importante, que no se debe dar por sentado que la información siempre se recuperará y que entradas más pequeñas darán mejores resultados". De hecho, la mayoría de los desarrolladores que buscan obtener información a partir de grandes cantidades de datos crean aplicaciones que dividen esos datos en partes más pequeñas para mejorar los resultados de búsqueda, aunque la ventana emergente ayudaría. conseguir más. En cuanto a la precisión del nuevo modelo, al realizar pruebas con lo que Anthropic llama "un conjunto ampliado de preguntas fácticas complejas que exploran las debilidades conocidas en los modelos actuales", la compañía dijo que Claude 2.1 generó la mitad de afirmaciones falsas. que la versión anterior. "Es más probable que el modelo actual diga que no saben en lugar de divagar o inventar algo", dijo Anthropic. La empresa también informa "mejoras significativas" en la comprensión y el resumen.

Otras noticias que te pueden interesar