El equipo rojo, en otras palabras, el equipo de hackers éticos de Microsoft, que se encarga de más de 100 productos Genai en el editor, dice que el diseño de sistemas de IA seguros y seguros es una tarea que no se puede terminar. En un artículo Publicado esta semana, los autores, incluidos Mark Russinovich, CTO y Diputado CISO Microsoft Azure, describió parte del trabajo del equipo en forma de ocho recomendaciones para "alinear los esfuerzos de equipo rojo con los riesgos del mundo real".

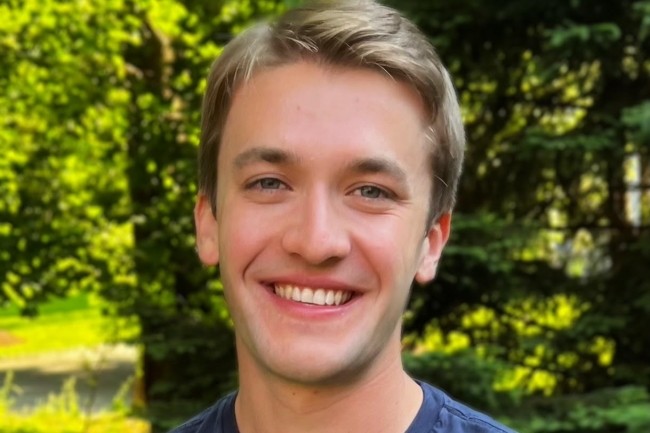

El autor principal, Blake Bullwinkel, un investigador de seguridad de IA dentro de este equipo rojo de Microsoft IA, y sus 25 coautores explican: "A medida que los sistemas de Genai se adoptan en un número creciente de áreas," Red Teaming "se convierte en una práctica esencial para evaluar La seguridad y la seguridad de estas tecnologías. Sin embargo, los sistemas completos, de principio a fin.

El uso de la automatización de pruebas

El documento recuerda que, cuando se creó en 2018, el Microsoft AI Red Team (ARTT) se centró principalmente en identificar vulnerabilidades de seguridad tradicionales y ataques de escape contra los modelos clásicos de aprendizaje de modelos. "Desde entonces", dice el artículo, "el alcance de la acción tanto como el tamaño de Airt ha aumentado considerablemente en respuesta a dos tendencias principales. Primero, la IA se ha vuelto mucho más sofisticadas y, en segundo lugar, inversiones recientes de Microsoft en IA en IA resultó en el desarrollo de muchos más productos que requirieron un equipo rojo.

Una doble tendencia que "hizo que las pruebas sean totalmente intransitables, obligándonos a intensificar nuestras operaciones utilizando la automatización", escriba los autores. " [Pour atteindre] Este objetivo, hemos desarrollado Pyrit, un marco de Python de código abierto que nuestros operadores usan mucho para las operaciones de equipo rojo. Al aumentar el peso del juicio humano y la creatividad en los análisis y decisiones, Pyrit permitió a Airtiértalo identificar vulnerabilidades con un alto impacto más rápidamente y cubrir una mayor parte del panorama de riesgos.

Por lo tanto, los autores decidieron compartir ocho observaciones extraídas de su experiencia en el artículo de investigación.

"Tienes que entender qué puede hacer el sistema y dónde se usa". El primer paso en la operación de equipo de AI Red es determinar las vulnerabilidades para el objetivo. "A partir de los impactos posteriores, en lugar de las estrategias de ataque, es más probable que una operación produzca resultados útiles vinculados a los riesgos del mundo real, sugiera los autores. Una vez que se han identificado estos impactos, el equipo rojo puede trabajar en reversa y Describe las diferentes formas que un oponente podría tomar para llegar a ellos.

"No es necesario saber cómo calcular los gradientes para romper un sistema de IA". Para probarlo, el artículo se refiere a un Estudio sobre la brecha entre la investigación y la práctica del aprendizaje automático antagonista (Estudio de ataques en algoritmos de aprendizaje automático y los medios para prevenirlos). Este documento explica que "aunque la mayoría de las investigaciones sobre el aprendizaje automático se centran en el desarrollo y la defensa contra los ataques sofisticados, los atacantes del mundo real tienden a usar técnicas mucho más simples para lograr sus objetivos". Es cierto que los ataques basados en el gradiente, por ejemplo, son poderosos, "pero a menudo no son prácticos o inútiles. Recomendamos favorecer la reproducción de técnicas simples y ataques de orquestación a nivel del sistema, porque es más probable que sea del tipo de ataque intentado por oponentes reales.

"El equipo de AI Red no es un punto de referencia de seguridad". Estos son dos enfoques distintos, insisten en los autores del artículo, pero "ambos son útiles, incluso complementarios". Por lo tanto, los puntos de referencia permiten comparar fácilmente el rendimiento de varios modelos en un conjunto de datos común. AI Red Teaming requiere muchos más recursos humanos, pero puede identificar nuevas categorías de daños y explorar riesgos contextualizados. Los nuevos daños resultantes de las nuevas capacidades de los sistemas de IA pueden no entenderse completamente, por lo que el equipo debe definirlos y crear herramientas para medirlos.

"Automatización para ayudar a cubrir un panorama de mayor riesgo". Según los autores, la "complejidad del panorama de riesgos de IA ha llevado al desarrollo de una variedad de herramientas capaces de identificar vulnerabilidades más rápido, realizar ataques sofisticados automáticamente y realizar pruebas una escala mucho mayor". Automation in AI Red Teaming Plays Plays Un papel esencial, que ha llevado al desarrollo de Pyrit en Microsoft.

"El elemento humano es crucial en el equipo rojo de la IA". Incluso si la automatización es importante para apoyar las operaciones de piratería ética generando ataques rápidos, orquestando y marcando respuestas, perseguir a los autores, "el conocimiento cultural y temático de los humanos sigue siendo esencial, así como su inteligencia emocional".

"El daño causado por la IA responsable es omnipresente, pero difícil de medir". En otras palabras, el daño causado directamente por la IA, en particular la IA responsable, es más difícil de entender que las vulnerabilidades de seguridad propiamente dicha, advierten a los autores. Todo esto tiene que ver con "diferencias fundamentales entre los sistemas de IA y el software tradicional". La mayoría de las investigaciones sobre la seguridad de la inteligencia artificial se centran en los usuarios de los adversarios, aquellos que rompen deliberadamente las salvaguardas. En realidad, insistir en los coautores del artículo: "Los usuarios aparentemente inofensivos que generan accidentalmente contenido dañino también son importantes, o incluso más".

"El LLM amplifica los riesgos de seguridad existentes e introduce otros nuevos". La integración de los modelos Genai en una gama cada vez más grande de aplicaciones ha introducido nuevos vectores de ataque y ha cambiado el panorama de los riesgos de seguridad. Por lo tanto, los autores alientan a "los equipos rojos a tener en cuenta tanto los riesgos existentes (generalmente a nivel del sistema) como los nuevos riesgos (generalmente a nivel del modelo)".

"El trabajo de asegurar sistemas de IA nunca estará terminado". La idea de que sería posible garantizar la seguridad de la IA, o resolver esta pregunta, según los únicos avances técnicos, no es realista y descuida los roles que puede desempeñar la dinámica económica, los ciclos de "reparación de fracaso" (break -fix ) y regulaciones. Por lo tanto, el documento subraya que "en ausencia de garantías de seguridad, necesitamos métodos para desarrollar sistemas de IA lo más difícil de romper. Teaming rojo y atenuación del peligro hasta que el sistema sea robusto frente a una amplia gama de 'ataques.

Red Teaming, una práctica emergente

Los autores concluyen al recordar que el equipo rojo de IA sigue siendo una práctica emergente y en rápida evolución para identificar los riesgos de seguridad que plantean los sistemas de IA. Pero también plantean una serie de preguntas. Para comenzar: "¿Cómo buscar elementos peligrosos dentro de LLM, como la capacidad de persuasión, el engaño o la replicación?" ». "¿Qué nuevos riesgos examinar en los modelos de generación de videos? ¿Y cuáles son las funciones que podrían surgir en modelos más avanzados que el estado del arte actual?». Otra pregunta: ¿Cómo pueden los equipos rojos ajustar sus prácticas a los diversos contextos lingüísticos y culturales? Y finalmente, ¿cómo estandarizar las prácticas de equipo rojo para que los equipos comuniquen sus resultados más fácilmente?

Otras noticias que te pueden interesar