La falta de evaluaciones independientes de las protecciones básicas para las tecnologías de IA preocupa a muchos profesionales. En una carta abierta, más de 150 destacados investigadores de IA, especialistas en ética, abogados y otros piden a las empresas que comercializan soluciones GenAI que se sometan a auditorías de sus sistemas. La carta, escrita por investigadores del MIT, Princeton y la Universidad de Stanford, pide protecciones legales y técnicas para la investigación de buena fe sobre modelos de IA generativa, que según ellos obstaculizan las medidas de seguridad que podrían ayudar a proteger al público. La carta, y el estudio que la respalda, fueron escritos con la ayuda de unas dos docenas de profesores e investigadores que pidieron "un marco legal de seguridad" para la evaluación independiente de los productos GenAI.

Campaña por los equipos rojos

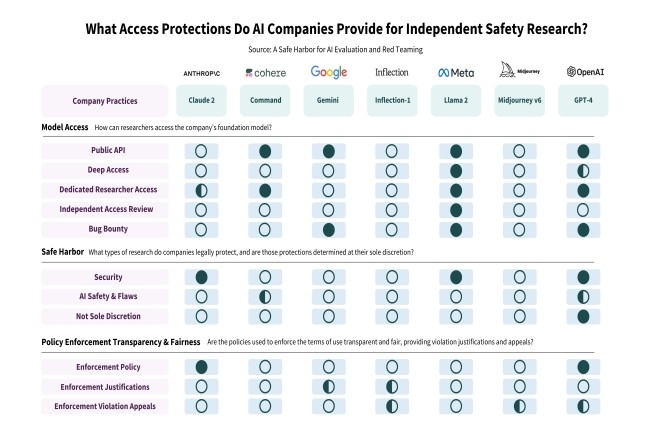

El documento, enviado a empresas como OpenAI, Anthropic, Google, Meta y Midjourney, pide que los investigadores tengan acceso a los productos para garantizar que los consumidores estén protegidos contra sesgos, supuestas infracciones de derechos de autor e imágenes íntimas no consensuadas. “Muchos creen que la evaluación independiente de los modelos de IA ya implementados es esencial para garantizar la seguridad y la confianza”, escribieron dos de los investigadores. En una publicación de blog“Las investigaciones independientes sobre los modelos de IA han descubierto vulnerabilidades relacionadas con lenguajes de bajos recursos, evasión de seguridad y una amplia gama de jailbreaks. “Estas evaluaciones cubren una amplia gama de fallas a menudo imprevistas que se pueden encontrar en los modelos, incluido el uso indebido, el sesgo, los derechos de autor y otros problemas”, agregaron.

Entre los firmantes se encuentran profesores de escuelas de la Ivy League y otras universidades de primer nivel, incluido el MIT, así como ejecutivos de empresas como Hugging Face y Mozilla. La lista también incluye investigadores y especialistas en ética como Dhanaraj Thakur, director de investigación del Centro para la Democracia y la Tecnología, y Subhabrata Majumdar, presidente de la AI Risk and Vulnerability Alliance.

Se desea más apertura y transparencia

Si bien la carta reconoce y acoge con satisfacción el hecho de que algunos fabricantes de genAI tienen programas especiales para permitir que los investigadores accedan a sus sistemas, también los critica por ser demasiado restrictivos sobre quién puede y quién no puede ver su tecnología. Los investigadores citaron a las empresas de inteligencia artificial Cohere y OpenAI como excepciones a la regla, “aunque sigue habiendo cierta ambigüedad sobre el alcance de las actividades protegidas”. Cohere permite “pruebas de estrés intencionales de API y ataques adversarios” siempre que las vulnerabilidades se revelen adecuadamente (sin promesas legales explícitas). Y OpenAI amplió su puerto seguro para incluir “investigación de vulnerabilidades de modelos” e “investigación de seguridad de modelos académicos” en respuesta a una versión preliminar de nuestra propuesta.

Pero en otros casos, las empresas de genAI han suspendido las cuentas de los investigadores e incluso han cambiado sus condiciones de servicio para desalentar ciertos tipos de revisiones. Pero “quitarle poder a los investigadores independientes no es lo mejor para las empresas de IA”, dicen los investigadores. Los revisores independientes que estudian productos genéricos de IA temen la suspensión de la cuenta (sin posibilidad de apelación) y los riesgos legales, “ambos pueden tener un efecto paralizante en la investigación”, según la carta abierta.

Para proteger a los usuarios, los firmantes quieren que las empresas de IA ofrezcan dos niveles de protección para la investigación:

- Protección jurídica para garantizar una investigación independiente y de buena fe sobre la seguridad, protección y fiabilidad de la IA, todo ello en el marco de una divulgación bien establecida de las vulnerabilidades.

- Un compromiso de la empresa con un acceso más justo mediante el uso de revisores independientes para moderar las solicitudes de revisión de los investigadores.

Tanto OpenAI como Google no respondieron de inmediato a una solicitud de comentarios.

Otras noticias que te pueden interesar