LLM locales con Opera One Developer

hace 1 año

Como parte de su programa AI Feature Drops, Opera está agregando soporte experimental para 150 variantes de LLM de alrededor de cincuenta familias de modelos para ejecutar localmente en su navegador. Entre ellos Llama de Meta, Vicuña Gemma de Google, Phi-2 de Microsoft y Mixtral de Mistral AI.

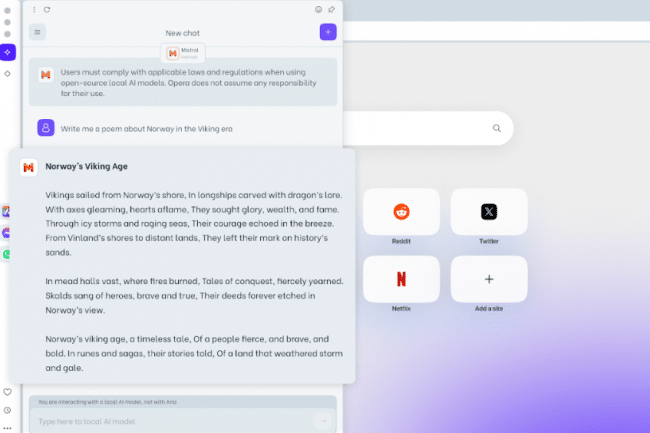

Opera adopta los LLM. El navegador, en la versión One Developer como parte de su programa AI Feature Drops, le permite probar un modelo de lenguaje grande para descargar localmente en su estación de trabajo. Esta es una función experimental, con todos los posibles problemas que puedan surgir (estabilidad, bugs, etc.). "Esta es la primera vez que es posible acceder y administrar fácilmente LLM locales desde un navegador grande gracias a una función integrada", anuncia con orgullo Opera. Entre ellos se encuentran Llama de Meta, Vicuña Gemma de Google, Phi-2 de Microsoft y Mixtral de Mistral AI. Estas plantillas están disponibles en el feed para desarrolladores de Opera One.

El uso de grandes modelos de idioma local significa que los datos del usuario se guardan en su dispositivo sin la necesidad de enviar información a un servidor remoto, lo cual es bueno para fines de prueba y garantía de privacidad. . La desventaja, sin embargo, es no poder aprovechar los datos incrementales de los LLM públicos en general en el mercado con fines de formación y, por lo tanto, la mejora continua de la relevancia de los resultados proporcionados. Sobre este punto, Opera no especifica si están previstas actualizaciones locales de LLM en las próximas semanas/meses, aunque hay que tener en cuenta que se trata de una función experimental, que debe considerarse más con fines de prueba que cualquier otra cosa.

Mayor tiempo de procesamiento que en la nube

"Al elegir un LLM local, lo descargará en su máquina. Tenga en cuenta que cada uno de estos requiere entre 2 y 10 GB de espacio de almacenamiento local y es probable que un LLM local sea considerablemente más lento para entregar resultados que un LLM basado en servidor. , ya que depende de las capacidades informáticas de su hardware", explica Opera. "Se utilizará LLM local en lugar de Aria, el navegador nativo de Opera AI, hasta que inicie un nuevo chat con Aria o simplemente vuelva a habilitar Aria".

Algunos LLM que se ofrecen para descargar también incluyen Code Llama para generar código, disponible en tres versiones: 7, 13 y 34 mil millones de parámetros. Admite muchos lenguajes de programación, incluidos Python, C++, Java, PHP, Typecript (JavaScript), C# y Bash. Tenga en cuenta que Nvidia también ofrece probar LLM localmente (descarga de 35 GB) utilizando sus tarjetas RTX 30 y 40.

Si quieres conocer otros artículos parecidos a LLM locales con Opera One Developer puedes visitar la categoría Otros.

Otras noticias que te pueden interesar