Para simplificar la vida de los desarrolladores que trabajan con LLM para diseñar aplicaciones generativas de IA, Meta comparte su primera pila oficial de Llama. Presentado el 25 de septiembre, este último reúne a varios proveedores de API Llama Stack que trabajan bien juntos para proporcionar un punto de acceso único a los desarrolladores, Meta anunció En una publicación de blog Presentando la última familia de LLM Llama 3.2. Esto incluye LLM para calcular la visión de tamaño pequeño y mediano (11b y 90b) y los modelos de luz solo en texto (1b y 3b) que integran ambos terminales por la red (Edge) y Mobile.

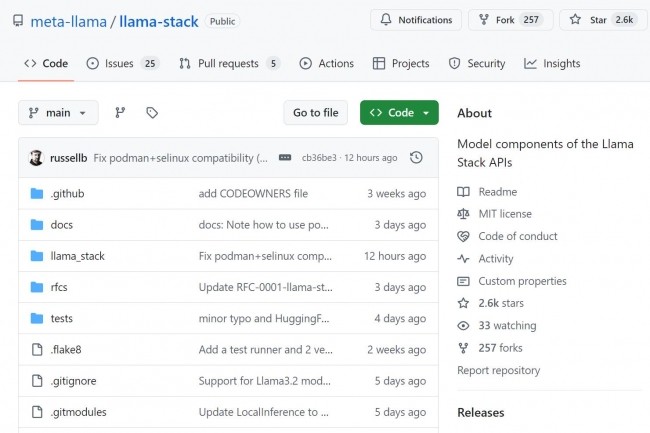

La batería de llamas define elementos básicos para la comercialización de aplicaciones generativas de IA. Estos módulos cubren el ciclo de vida del desarrollo, la capacitación y el ajuste del modelo fino a la evaluación del producto, a la construcción y ejecución de agentes y aplicaciones de IA basadas en la generación aumentada por la recuperación (RAG) en la producción. Las especificaciones de la API de la pila de llamas, así como los proveedores de API y las distribuciones están disponibles en Github.

Distribuciones de Llama de Llama de Multi-Environment

Entre la pila de proveedores Llama, encontramos a AWS Bedrock, Chroma o Ollama y TGI. La empresa matriz de Facebook también es parte de ella con meta referencia. El proveedor busca garantizar que los desarrolladores puedan ensamblar soluciones de inteligencia artificial utilizando elementos coherentes e interdependientes en todas las plataformas. Las distribuciones de pila de llama deberían ayudar a los desarrolladores a trabajar con modelos de LLAMA en múltiples entornos, incluso en el sitio, una nube o una terminal móvil, dijo meta. La batería de LLAMA consiste en un conjunto de API: inferencia, seguridad, memoria, sistema de agentes, evaluación posterior al entrenamiento, generación de datos sintéticos y clasificación de recompensas.

Otras noticias que te pueden interesar