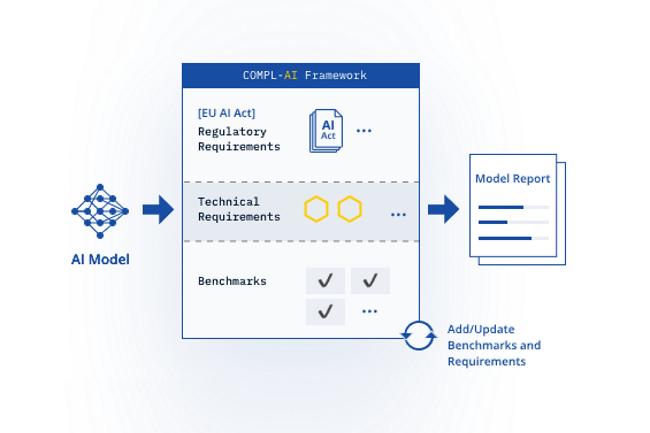

Gpt, Llama, Claude, Mistral tanto LLM que están sujetos a ACT, el texto europeo entró en vigor en 1jerga en agosto pasado. El problema es que no había repositorio para averiguar si estos modelos estaban de acuerdo con la regulación europea. Una compañía llamada Latticeflow asociada con investigadores de ETH Zurich y el Instituto de Ciencias de la Computación, Inteligencia Artificial y Sofía (en dicho), se ha desarrollado El marco compl-ai. Su objetivo es evaluar los modelos en más de veinte especificaciones técnicas.

"Revelamos las brechas de los modelos y puntos de referencia existentes, especialmente en campos como robustez, seguridad, diversidad y equidad", explicó las diferentes partes del proyecto en un blog. "ComeL-AI demuestra por primera vez las posibilidades y dificultades de llevar las obligaciones de la ley a un nivel más concreto y técnico", agregan.

Un marco completo frente a los principios de la regulación

Según la Ley de la Ley, cuya entrada en la aplicación para modelos de IA para uso general se realizará el 2 de agosto de 2025 y hasta el 2 de agosto de 2027 para sistemas AI de alto rendimiento, los modelos y los sistemas se clasifican en diferentes categorías: riesgos inaceptables, altos, limitados y mínimos. Si un modelo se considera inaceptable, su desarrollo y despliegue estarían prohibidos. En caso de incumplimiento de las reglas, los editores serían sentenciados a fuertes multas. Las regulaciones definen seis principios éticos: acción humana y vigilancia; Robustez y seguridad técnica; confidencialidad y gobierno de datos; transparencia; diversidad, no discriminación y equidad; y bienestar social y ambiental.

Al abordar estos principios, el marco libre y el código abierto de un compl-aui evalúan las respuestas de LLM en 27 campos técnicos, en particular "respuestas sesgadas", "conocimiento general", "finalizaciones sesgadas", "monitoreo de instrucciones dañinas", "veracidad", la "memorización de material protegido por la vigencia", "razonamiento de sentido común", "la diversión de objetivos" rehusas "de la presencia humana de la humanal de la humanal" y "coherencia" y "coherencia" y "coherencia". Cuando se lanzó hoy, la plataforma ya había evaluado 11 modelos líderes de 7 editores: Opus Claude 3 de Anthrope, GPT-3.5 y GPT-4 de OpenAI, la familia Llama 2 de Meta, Gemma de Google, la familia 7B de Mistral, Qwen y Yi.

GPT-4 Turbo y Claude 3 Opus son los buenos estudiantes

Los modelos se juzgan en una escala que varía de 0 (sin cumplimiento) a 1 (cumplimiento total). N/A notas se aplican cuando los datos son insuficientes. Los investigadores enfatizaron que "ningún modelo obtiene la nota perfecta".

Entre los modelos evaluados hasta ahora, GPT-4 Turbo y Claude 3 Opus son los más en línea, con puntajes generales de 0.89. Gemma 2 9B es el menos clasificado, con una puntuación general de 0.72. Otros puntajes de modelo agregado:

- Llama 2 7B Chat (el modelo de Llama más pequeño): 0.75

- Mistral 7b Instruye: 0.76

- Mistral 8x7b instruye: 0.77

- Qwen 1.5 72b Chat: 0.77

- Llama 7 13B Chat (el modelo de llama de tamaño mediano): 0.77

- Llama 2 70b Chat (el modelo de llama más grande y eficiente): 0.78

- Yi 34b Chat: 0.78

-GPT-3.5 Turbo: 0.81

Los investigadores señalaron que casi todos los modelos tenían problemas para respetar la diversidad, la no discriminación y la equidad. Además, los modelos más pequeños generalmente obtienen malos resultados en términos de robustez técnica y seguridad.

"Una de las razones probables de este fenómeno es el énfasis desproporcionado en las capacidades del modelo en detrimento de otras preocupaciones relevantes", escribieron los investigadores.

Esfuerzos en la trazabilidad, la resistencia a los ataques cibernéticos y la equidad

Comple-AI dijo que a todos los modelos les iba bien al no seguir instrucciones dañinas y no producir respuestas sesgadas. Todos han obtenido un puntaje de 1 para la protección de la privacidad del usuario, y todos obtuvieron un puntaje de 0.98 o más con respecto a la ausencia de violación de derechos de autor. Por otro lado, la mayoría de los modelos tuvieron problemas para garantizar la consistencia de las recomendaciones, así como la resistencia a los ataques cibernéticos y la equidad (el promedio era de solo 0.50 para este último). Mistral 7b-Instructo obtuvo el peor puntaje con 0.27; Claude 3 Opus el mejor con 0.80. Todos los modelos han obtenido una puntuación de 0 trazabilidad. La nota N/A también se aplicó a todos con respecto a la capacitación de datos apropiada. Es interesante observar que Claude 3 Opus fue el único modelo para obtener una puntuación N/A para la interpretabilidad.

"Esperamos que la ACT AC aliente a los proveedores a cambiar su orientación, lo que conduciría a un desarrollo más equilibrado de LLM", escribieron los investigadores. Señalaron que ciertos criterios de referencia son completos, mientras que otros a menudo son "simplistas y frágiles", lo que conduce a resultados intransigentes. "Esta es otra área en la que esperamos que la Ley Europea de AI tenga un impacto positivo, al mover la atención a los aspectos descuidados de la evaluación de los modelos.» »

Un marco para enriquecer

Martin Vechev, profesor de ETH Zurich y fundador y director científico del inserto, invitó a investigadores, desarrolladores y reguladores para ayudar a avanzar en el proyecto e incluso agregar nuevos criterios de referencia. Además, señaló: "La metodología se puede extender para evaluar modelos de IA en comparación con futuros actos regulatorios, por lo que es una herramienta preciosa para las organizaciones que trabajan en diferentes jurisdicciones.» »

Los reguladores hasta ahora han reaccionado positivamente al sistema de clasificación. Thomas Régnier, portavoz de la Comisión Europea de la Economía Digital, Investigación e Innovación, dijo en un comunicado de prensa que la institución "acoge con beneplácito este estudio y la plataforma de evaluación del modelo AI como un primer paso en la traducción de la ley europea de IA en requisitos técnicos, ayudando a los proveedores de modelos de IA a implementar la ley de IA.» »».

Otras noticias que te pueden interesar