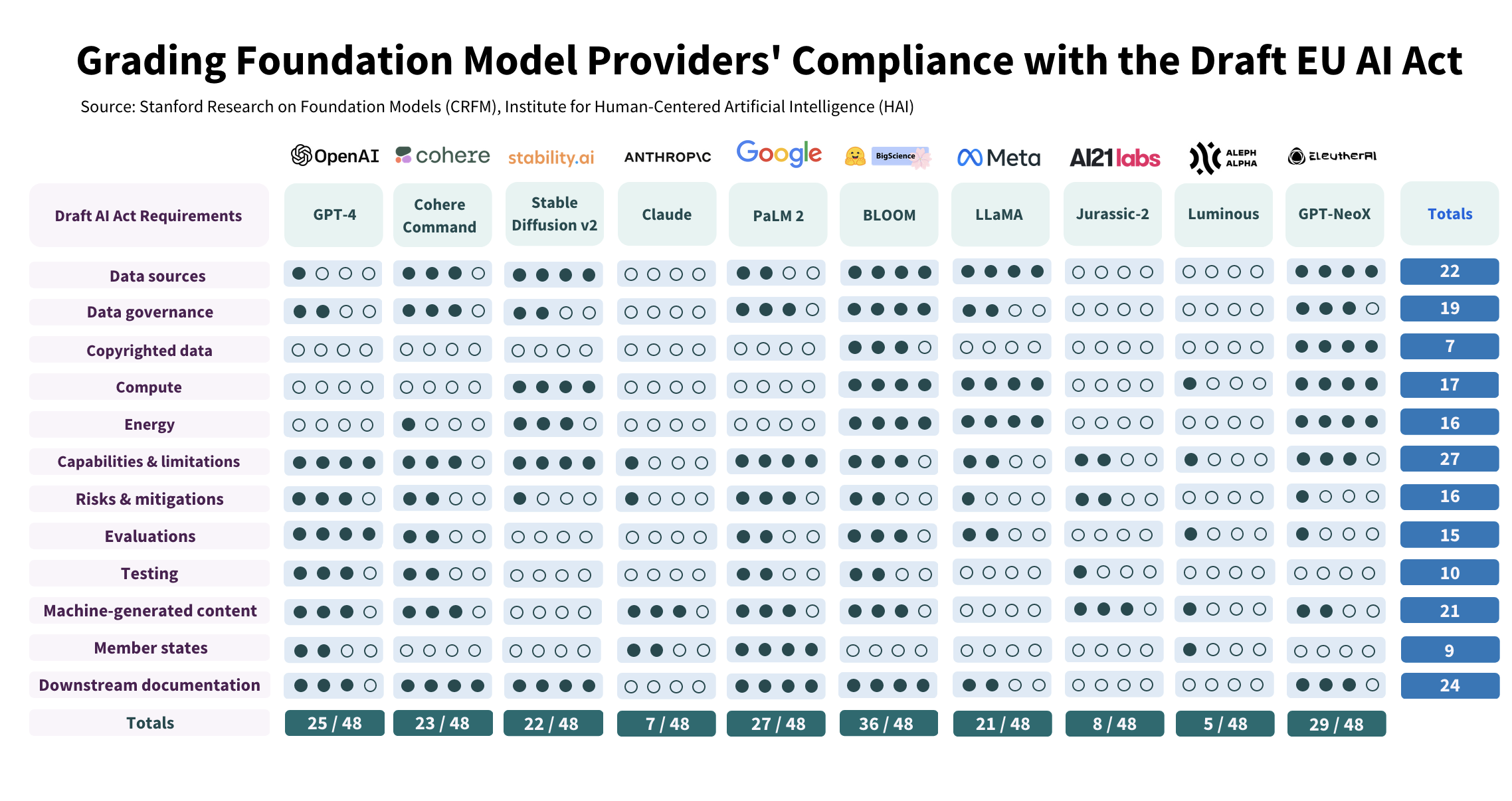

Ahora que el Parlamento Europeo ha aprobado la Ley de IA, dando un primer paso clave antes de su adopción por los 27, es hora de evaluar cómo los modelos básicos, como los LLM representados por el ahora imprescindible GPT-4 d OpenAI, cumplir con este futuro reglamento. Cuatro investigadores de la Universidad de Stanford en California (Rishi Bommasani, Kevin Klyman, Daniel Zhang y Percy Liang) examinaron la cuestión. Y los resultados, nada halagüeños, dicen mucho sobre los esfuerzos que la industria tendrá que hacer para alinearse con la primera legislación que regula la IA en el mundo.

Examinados según 12 criterios que corresponden a otras tantas exigencias de los legisladores de la Unión, 3 de los 10 modelos estudiados obtuvieron notas deplorables. Las estrellas del campo, incluidas GPT-4 (OpenAI), PaLM 2 (Google), Stable (Stability.ai) y LLaMA (Meta), obtienen resultados un poco mejores, con puntuaciones que varían entre 21 y 27 sobre 48. Lo bueno Estudiante de la clase generativa, destaca claramente el modelo Open Source Bloom, entrenado con la calculadora francesa Jean Zay en el CNRS y apoyado por HuggingFace, con un total de 36 puntos sobre 48. "Incluso para los proveedores mejor valorados, el margen de mejora sigue siendo significativo", modera Stanford, para quien el estudio confirma la magnitud de los cambios que la industria tendrá que aceptar para cumplir con la Ley de IA. Si bien añade que estos cambios siguen “al alcance” de los proveedores. Y los cuatro autores defienden, frente a las dudas que florecen en Europa, la pertinencia de este reglamento: “La adopción y aplicación de la ley europea sobre IA conducirá a cambios positivos significativos en el ecosistema de los modelos de IA. base ".

Riesgos del modelo: la gran confusión

El principal defecto de estos modelos respecto a la Ley de IA, según los investigadores: la falta de transparencia. "Los proveedores rara vez divulgan la información esperada sobre los datos, el cálculo y la implementación de sus modelos, así como las características principales de los propios modelos", escriben los investigadores, que creen en particular que los proveedores generalmente no cumplen con los requisitos de la futura legislación. con respecto a la documentación del uso de datos de entrenamiento protegidos por derechos de autor, el hardware utilizado y las emisiones producidas durante la fase de entrenamiento, cómo evalúan y prueban los modelos y cómo limitan los riesgos inherentes a los modelos básicos utilizados en la IA generativa. "Si bien muchos proveedores de modelos de fundaciones enumeran los riesgos, relativamente pocos divulgan las medidas de mitigación que implementan y la efectividad de esas medidas", escriben los investigadores. Además, la futura legislación de la UE exige que los proveedores describan “riesgos no mitigados, explicando por qué no pueden mitigarse”. Lo que ninguno de los proveedores evaluados está haciendo actualmente, señala El estudio de Stanford.

Los investigadores de Stanford evaluaron 10 modelos de IA según 12 criterios que corresponden a los requisitos de la Ley de IA. Conclusión: ninguno cumple con la futura normativa europea.

Y recomendar a los legisladores que den prioridad a este tema de transparencia. "Nuestra evaluación demuestra que actualmente es posible que los proveedores de modelos básicos cumplan con la Ley de IA y que revelar información relacionada con el desarrollo, el uso y el rendimiento de los modelos mejoraría la transparencia en todo el ecosistema", escriben los investigadores, que subrayan la importancia del texto europeo, la primera legislación sobre IA a escala mundial y, por tanto, que sentará un precedente. “Los responsables políticos de todo el mundo ya se están inspirando en esta legislación, y las empresas multinacionales podrían [du fait de l'AI Act] modificar sus prácticas para mantener un proceso único de desarrollo de la IA a escala global”, quieren creer los autores del estudio.

Otras noticias que te pueden interesar