Dominado por Se anuncia la arquitectura de GPU Blackwell y los sistemas DGX masivos A partir de ahí, el GTC 2024 de Nvidia, celebrado del 18 al 21 de marzo en San José, dio lugar a muchos otros lanzamientos de productos en torno a HPC y IA.

Plataformas de red de alta velocidad

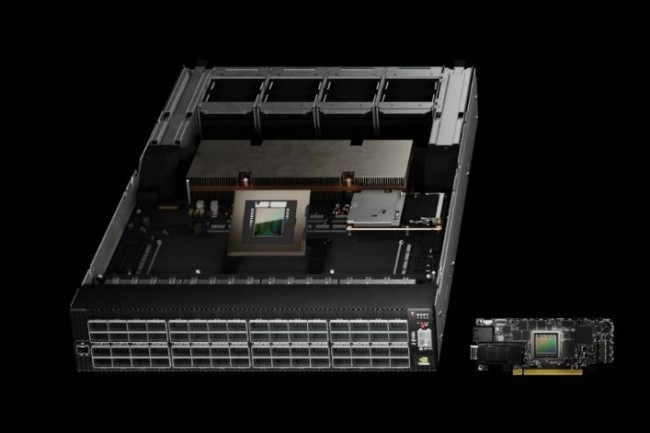

Aunque se centra menos en el aspecto de red, Nvidia es también una empresa de redes desde su adquisición de Mellanox. El proveedor con sede en Santa Clara ha anunciado dos plataformas de redes de alta velocidad con rendimientos de hasta 800 Gbps, destinadas a sistemas HPC. La primera plataforma, llamada Quantum-X800 InfiniBand, consta de dos componentes: el conmutador Quantum 3400 y el ConnectX-8 SuperNIC. Ofrece cinco veces el ancho de banda y nueve veces la capacidad de computación de red de la generación anterior, o 14,4 teraflops. La segunda plataforma, llamada Spectrum-X800 Ethernet, utiliza el conmutador Spectrum SN5600 de 800 Gbps y el Nvidia BlueField-3 SuperNIC. Está diseñada para nubes de IA generativas multiinquilino y grandes empresas. Los proveedores de servicios en la nube, incluidos Microsoft Azure, Oracle Cloud Infrastructure y Coreweave, están haciendo fila para adquirir sistemas Quantum InfiniBand y Spectrum-X Ethernet.

Microservicios para inferencia

Hasta ahora, los microservicios no se han asociado con la IA porque estos programas pequeños y livianos están diseñados para realizar una o varias funciones. Y son computacionalmente intensivos, lo cual es la antítesis de la IA. Pero Nvidia ha presentado microservicios para la inferencia en modelos de lenguaje grandes (LLM). Llamado Nvidia Inference Microservices (NIM), el software es parte de la suite de IA empresarial de Nvidia. Consiste en un conjunto de motores de inferencia optimizados, API estándar y soporte para modelos de IA, todo empaquetado en contenedores para una fácil implementación. NIM proporciona modelos preconstruidos y permite a las empresas agregar sus propios datos y modelos. Una cosa que se puede decir sobre esta tecnología NIM es que Nvidia no trabajó en el vacío. La compañía se ha asociado con varios proveedores de software, incluidos SAP, Adobe, Cadence, CrowdStrike y ServiceNow, así como con proveedores de plataformas de datos, incluidos Box, Cohesity, Cloudera, Databricks, Datastax y NetApp. NIM ofrece procesamiento de inferencias en muchos modelos de IA populares de Google, Meta, Hugging Face, Microsoft, Mistral AI y Stability AI. Los microservicios de NIM estarán disponibles en Amazon Web Services, Google Kubernetes Engine y Microsoft Azure AI.

Hacia la validación del almacenamiento HPC

El almacenamiento es un componente clave del procesamiento de IA, porque la IA no es nada sin grandes cantidades de datos. Por eso, Nvidia lanzó un Programa de validación de socios de almacenamiento para ayudar a las empresas a encontrar las soluciones de almacenamiento adecuadas al ofrecer certificación para cargas de trabajo de IA y uso intensivo de gráficos. El programa se llama OVX, un nombre similar a los servidores informáticos DGX. El primer grupo de empresas que buscan la validación del almacenamiento OVX incluye a DDN, Dell PowerScale, NetApp, Pure Storage y Weka. Los servidores OVX combinan computación acelerada por GPU con acceso de almacenamiento de alta velocidad y redes de baja latencia para abordar una variedad de cargas de trabajo de IA y uso intensivo de gráficos complejos. El programa proporciona un proceso estandarizado para que los socios validen sus dispositivos de almacenamiento.

Los proveedores de servidores acuden a Blackwell

Todos los principales proveedores han anunciado servidores basados en Blackwell. Dell Technologies anunció que el PowerEdge XE9680, su modelo estrella acelerado por GPU de ocho vías para entrenamiento GenAI, personalización de modelos e inferencia de IA a gran escala, se actualizará con aceleradores Blackwell. Lenovo anunció servidores de IA de 8 GPU (los sistemas con GPU ThinkSystem SR680a V3, SR685a V3 y SR780a V3) basados en Blackwell para respaldar cargas de trabajo de IA, computación de alto rendimiento (HPC) y simulación y gráficos en una variedad de industrias.

HPE informó que las supercomputadoras anunciadas en noviembre pasado en SC23 (Conferencia Internacional de Computación de Alto Rendimiento, Redes, Almacenamiento y Análisis) ya están disponibles para pedidos de empresas que buscan una solución completa, preconfigurada y preprobada para desarrollar y entrenar modelos de IA de gran tamaño. Estos servidores HPC son soluciones llave en mano diseñadas específicamente para ayudar a los clientes a acelerar proyectos de GenAI y aprendizaje profundo, y pueden admitir hasta 168 GH200 (Grace Hopper SuperChips). Además del hardware, HPE Services ofrece soporte para ayudar a las empresas a diseñar, implementar y administrar la solución.

En GTC 2024, Supermicro también presentó una serie de servidores, con sistemas que incorporan el chip GB200 (Grace Blackwell Superchip), así como las GPU B200 (dos matrices Blackwell) y B100 (una matriz Blackwell). La empresa también afirmó que sus sistemas Nvidia HGX H100 y H200 existentes ahora son "plug-and-play" para estas GPU, lo que significa que los clientes pueden cambiar el hardware basado en Hopper por Blackwell cuando esté disponible. Supermicro afirma que será el primer fabricante de servidores en lanzar los sistemas HGX B200 de 8 GPU y HGX B100 de 8 GPU a finales de este año.

Actualización de Blackwell para Nvidia/AWS HPC

Nvidia y Amazon se unieron el año pasado para construir lo que se suponía que sería uno de los superordenadores más rápidos del mundo, llamado Proyecto Ceiba. Con el anuncio de la GPU Blackwell, el Proyecto Ceiba recibirá una actualización que lo hará hasta seis veces más rápido de lo planeado originalmente. El Proyecto Ceiba, como se describió originalmente, era un cohete, con más de 16.000 aceleradores de IA H100 Hopper y 65 exaflops de potencia de procesamiento de IA (baja precisión) cuando se completara. Nvidia y Amazon actualizarán el Proyecto Ceiba con 10.386 aceleradores GB200. Recordemos que este último consta de:Un procesador Grace (basado en ARM) y dos GPU Blackwell ensambladoslo que corresponde a un total de 20.736 GPU.

Otras noticias que te pueden interesar