Google se suma a Amazon y Microsoft con la nueva CPU para centros de datos basada en Arm, Axion

hace 1 año

Google se unió a las filas de los proveedores de servicios en la nube Amazon y Microsoft el martes con el anuncio de silicio personalizado para sus centros de datos.

La línea de procesadores Axion de Google representa sus primeras CPU basadas en Arm diseñadas para el centro de datos. “Axion ofrece un rendimiento y una eficiencia energética líderes en la industria y estará disponible para los clientes de Google Cloud a finales de este año”, escribió Amin Vahdat, vicepresidente y gerente general de sistemas de aprendizaje automático e inteligencia artificial en la nube de la empresa, en un blog de la empresa.

Según Google, los procesadores Axion combinan la experiencia en silicio de la empresa con los núcleos de CPU de mayor rendimiento de Arm para ofrecer instancias con hasta un 30 % más de rendimiento que las instancias Arm de propósito general más rápidas disponibles en la nube hoy en día y hasta un 50 % más de rendimiento y hasta un 60 % más de eficiencia energética que las instancias comparables basadas en x86 de la generación actual.

Google es el tercero de los tres grandes proveedores de servicios en la nube que desarrolla sus propios diseños de CPU, explicó Bob O'Donnell, fundador y analista jefe de Technalysis Research, una empresa de consultoría e investigación de mercado tecnológico en Foster City, California.

"Todas estas empresas quieren tener algo que sea exclusivo de ellas, algo en lo que puedan escribir su software para ejecutarlo y hacer las cosas de manera más eficiente", dijo a TechNewsWorld.

“El consumo de energía de los centros de datos es uno de sus mayores costos y los diseños de Arm generalmente son más eficientes energéticamente que los de Intel”, continuó. “Google no se deshará de Intel, pero Axion les brinda una nueva opción y, para ciertos tipos de cargas de trabajo, será una mejor alternativa”.

También hay consideraciones de mercado. “Todo el mundo quiere una alternativa a Nvidia”, dijo O’Donnell. “Nadie quiere una empresa que tenga una participación de mercado del 90% a menos que sea la empresa con esa participación”.

Malas noticias para Intel

Benjamin Lee, profesor de ingeniería de la Universidad de Pensilvania, explicó que Google puede personalizar sus componentes de hardware para lograr un mayor rendimiento y eficiencia diseñando su propia CPU.

“Gran parte de esta eficiencia proviene de la construcción de controladores personalizados que manejan cálculos importantes para la seguridad, la red y la gestión del hardware”, dijo a TechNewsWorld. “Al manejar los cálculos de contabilidad necesarios en los servidores de los centros de datos, estos controladores de hardware personalizados liberan más CPU para los cálculos de los usuarios y clientes”.

El uso de procesadores Arm en el centro de datos es una noticia desafortunada para Intel, que históricamente ha dominado el mercado de centros de datos con sus procesadores x86, señaló.

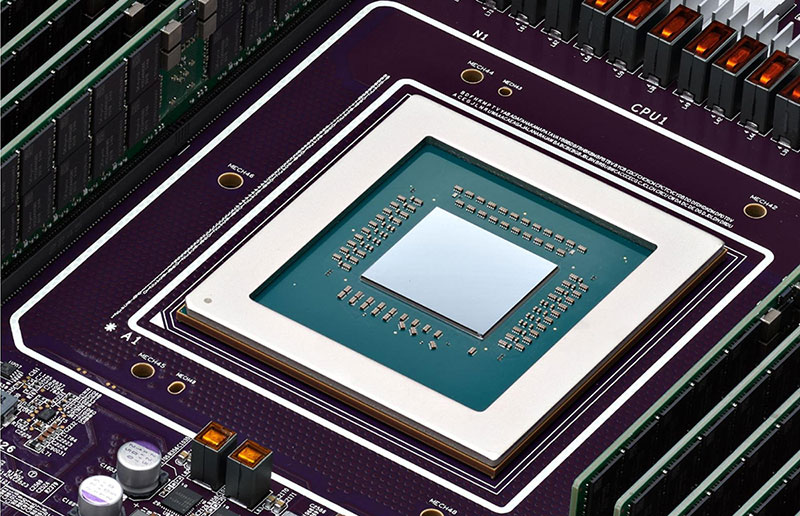

Procesador Axion de Google (Crédito de la imagen: Google)

“Este anuncio muestra una transición acelerada desde las arquitecturas x86 hacia Arm para el mercado de servidores, que es el premio máximo para las empresas de chips”, agregó Rodolfo Rosini, cofundador y CEO de Vaire, una empresa de computación reversible con oficinas en Seattle y Londres.

"Sospecho que Arm sacará más provecho de este anuncio que Google a largo plazo", dijo a TechNewsWorld.

El auge del silicio patentado

Axion es otro ejemplo de actores importantes, como Apple y Tesla, que invierten en sus propios diseños de chips, observó Gaurav Gupta, vicepresidente de semiconductores y electrónica de Gartner, una empresa de investigación y asesoría con sede en Stamford, Connecticut.

“Vemos esto como una tendencia importante”, dijo a TechNewsWorld. “Lo llamamos OEM Foundry Direct, donde los OEM pasan por alto o toman asistencia de las empresas de diseño y van directamente a la fundición para obtener su silicio. Lo hacen para un mejor control de costos y hoja de ruta, sinergias de propiedad intelectual y demás. Seguiremos viendo más de esto”.

Con este anuncio, Google está poniendo su importante peso financiero y técnico detrás de una tendencia del mercado en la que los semiconductores (como las CPU y los aceleradores) se diseñan de acuerdo con el uso que se les va a dar, explicó Shane Rau, analista de semiconductores de IDC, una empresa global de investigación de mercados.

“Ninguna CPU o acelerador puede manejar todas las cargas de trabajo y aplicaciones que tienen los clientes de la nube de Google, por eso Google les ofrece otra opción de aceleración de CPU e IA”, dijo a TechNewsWorld.

Disponibilidad general de TPU v5p

Además del anuncio de Axion, Google anunció la disponibilidad general de Cloud TPU v5p, la unidad de procesamiento tensorial más potente y escalable de la compañía hasta la fecha.

El acelerador está diseñado para entrenar algunos de los modelos de IA generativa más grandes y exigentes, explicó la empresa en un blog. Un solo módulo TPU v5p contiene 8960 chips que funcionan al unísono (más del doble de chips que un módulo TPU v4) y pueden ofrecer más del doble de FLOPS y el triple de memoria de alto ancho de banda por chip.

“El desarrollo de Tensor SoCs por parte de Google para sus teléfonos Pixel y el avance de unidades de procesamiento Tensor más potentes para uso en centros de datos subrayan su compromiso de acelerar las cargas de trabajo de aprendizaje automático de manera eficiente”, observó Dan deBeaubien, director de innovación en el SANS Institute, una organización global de capacitación, educación y certificación en ciberseguridad.

"Esta distinción resalta el enfoque de Google hacia la optimización de los entornos móviles y de centros de datos para aplicaciones de IA", dijo a TechNewsWorld.

Abdullah Anwer Ahmed, fundador de Serene Data Ops, una empresa de gestión de datos en Dublin, Ohio, agregó que la TPU de Google agrega otra opción para inferencias de menor costo a la nube de Google.

Los costos de inferencia son lo que los usuarios pagan para ejecutar sus modelos de aprendizaje automático en la nube. Esos costos pueden llegar a representar hasta el 90 % del costo total de funcionamiento de la infraestructura de aprendizaje automático.

“Si una startup ya está usando Google Cloud y sus costos de inferencia comienzan a superar los costos de capacitación, puede ser una opción adecuada pasarse a las TPU de Google para reducir los costos, dependiendo de la carga de trabajo”, dijo Ahmed a TechNewsWorld.

Promoviendo la sostenibilidad

Además de mejorar el rendimiento, Google señaló que sus nuevos chips Axion contribuirán a sus objetivos de sostenibilidad. “Más allá del rendimiento, los clientes quieren operar de manera más eficiente y cumplir con sus objetivos de sostenibilidad”, escribió Vahdat. “Con los procesadores Axion, los clientes pueden optimizar para lograr una eficiencia energética aún mayor”.

“Los centros de datos consumen mucha energía porque funcionan las 24 horas del día, los 7 días de la semana. Reducir el consumo de energía contribuye a la sostenibilidad”, afirmó Ahmed.

“La CPU basada en Arm es mucho más eficiente energéticamente que la x86”, añadió O'Donnell. “Eso es muy importante porque los costos de energía son enormes en estos centros de datos. Estas empresas tienen que trabajar para reducirlos. Esa es una de las razones por las que todas están aprovechando Arm”.

“A medida que aumentan las demandas de computación, no se puede hacer eso indefinidamente porque solo hay una cierta capacidad en el mundo, por lo que hay que ser más inteligentes al respecto”, agregó. “Eso es en lo que todos están trabajando”.

Si quieres conocer otros artículos parecidos a Google se suma a Amazon y Microsoft con la nueva CPU para centros de datos basada en Arm, Axion puedes visitar la categoría Tecnología.

Otras noticias que te pueden interesar