El pasado 9 de abril, en la conferencia Google Cloud Next 2024 (Las Vegas), la compañía Alphabet dio a conocer una serie de productos y servicios, entre ellos un programa diseñado para ayudar a startups y pequeñas empresas a crear aplicaciones y servicios de IA generativa. La iniciativa, que combina el programa global Nvidia Inception para startups y el programa Google for Start-ups Cloud, ofrece más beneficios que incluyen créditos en la nube, soporte de salida al mercado y experiencia técnica para ayudar a las empresas jóvenes con sus proyectos de IA. 18.000 startups ya cuentan con el apoyo del programa Inception, y Nvidia busca atraer a más ofreciendo un acceso más rápido a la infraestructura de Google Cloud con créditos GCP y una bonificación de hasta 350.000 dólares para empresas centradas en la IA. A cambio, los miembros del programa Google for Startups Cloud pueden unirse a Nvidia Inception y acceder a experiencia técnica, créditos de cursos del Nvidia Deep Learning Institute, hardware y software de Nvidia y más. Inception también ofrece una plataforma llamada Capital Connect, que conecta a las startups con empresas de capital riesgo interesadas en el sector.

Se lanza la CPU personalizada Axion basada en Arm

Google también anunció una línea de procesadores Arm llamada Axion, para sus ofertas de servicios en la nube. Después de Amazon Web Services, que ha estado ofreciendo procesadores Graviton basados en Arm desde 2018, y Microsoft, que lanzó su propio chip Arm Cobalt 100 el otoño pasado, Google es el último gigante tecnológico en fabricar sus propios chips personalizados basados en Arm. Sin embargo, esta no es la primera incursión de la compañía de Mountain View en el silicio personalizado. Desde 2015, la compañía ha estado desarrollando unidades de procesamiento de tensor (TPU) para acelerar sus propias cargas de trabajo y, en 2018, lanzó una unidad de codificación de video (VCU) para la transcodificación de video. Pero el Axion será el primer silicio personalizado de Google dirigido a los clientes de la nube.

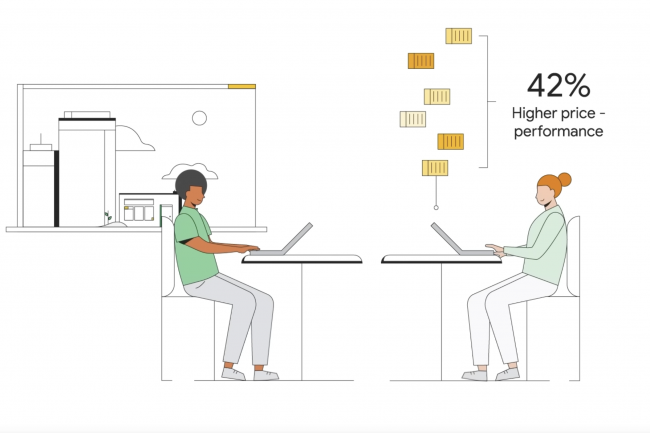

Axion se basa en la arquitectura Neoverse V2 de Arm, diseñada para cargas de trabajo de centros de datos. Recuerde que Arm no fabrica chips, sino diseños que vende a licenciatarios que los personalizan. Algunos fabrican teléfonos inteligentes (Apple, Qualcomm), otros chips para servidores (Ampere). Google se negó a hacer comentarios sobre velocidades, precios y núcleos, pero el proveedor dijo que los procesadores Axion ofrecerán instancias que son hasta un 30% más eficientes que las instancias de propósito general de Arm más rápidas disponibles en la nube hoy, hasta un 50% más eficientes y hasta un 60% más eficientes energéticamente que las instancias basadas en x86 de la generación actual comparables.

La plataforma Axion está construida sobre Titanium, un sistema de microcontroladores de silicio personalizados construidos por Google y "una tarjeta de descarga dedicada que permite la aceleración de hardware de los servicios de virtualización, descargando el procesamiento de la CPU anfitriona, liberando recursos para sus cargas de trabajo", como explica Google. Titanium puede descargar las operaciones de red y seguridad, de modo que los procesadores Axion puedan centrarse en el cálculo de la carga de trabajo, de la misma manera que la SuperNIC descarga a la CPU del procesamiento del tráfico de red. "Las máquinas virtuales basadas en procesadores Axion estarán disponibles en versión preliminar en los próximos meses", dijo Google.

Actualización de los servicios de software de inteligencia artificial

En febrero, Google presentó Gemma, un conjunto de modelos abiertos que utilizan la misma investigación y las mismas tecnologías que se utilizaron para crear su servicio de IA generativa Gemini. Hoy, los equipos de Google y Nvidia han trabajado juntos para acelerar el rendimiento de Gemma con TensorRT-LLM de Nvidia, una biblioteca de código abierto para optimizar la inferencia LLM. GCP también ha facilitado la implementación del marco NeMo de Nvidia para crear aplicaciones de IA generativas personalizadas en su plataforma a través de su motor GKE Kubernetes y Google Cloud HPC Toolkit, lo que permite a los desarrolladores impulsar el desarrollo de modelos de IA generativa e implementar rápidamente productos de IA listos para usar.

Otras noticias que te pueden interesar