En noviembre de 2023, Copo de nieve había presentado su servicio Cortex “que alberga modelos de IA de última generación, LLM y funciones vectoriales”, explicó Sridhar Ramaswamy, entonces vicepresidente sénior de IA y se convirtió en director ejecutivo el pasado mes de febreroEn su evento en San Francisco, la compañía anunció varias actualizaciones de Cortex.

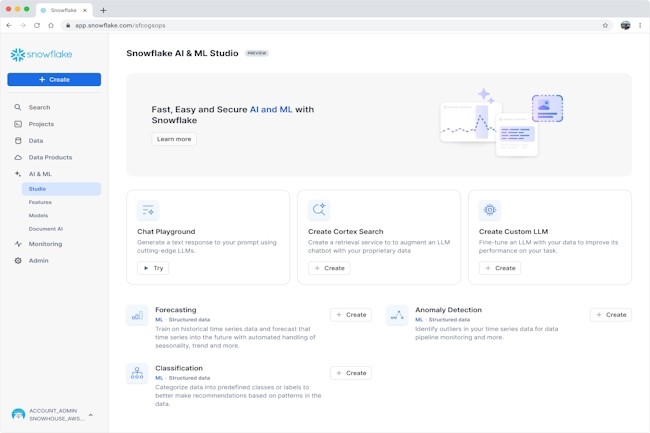

Un estudio de IA y ML sin código

En primer lugar, introdujo AI y ML Studio con una interfaz sin código a través de un chatbot llamado Playground. Esta función permite a las empresas crear, refinar e implementar rápidamente aplicaciones de IA con diferentes LLM como Google, Meta, Mistral, Reka y Arctic. “Actualmente en vista previa privada, Playground puede ayudar a las empresas a acelerar el desarrollo de aplicaciones de IA y proporcionar una interfaz para encontrar el LLM más potente y rentable para un caso de uso específico”, dijo el proveedor. Pero los analistas dicen que el proveedor apunta a varios objetivos con el lanzamiento de Playground, incluido ponerse al día con su rival Databricks. “La introducción de una interfaz sin código probablemente también esté impulsada por la creciente presión del mercado y los competidores que ya han adoptado estos entornos de desarrollo fáciles de usar”, dijo Steven Dickens, vicepresidente de la firma de investigación y asesoría The Futurum Group. “El éxito de plataformas como Databricks, que ofrecen herramientas integrales de desarrollo de IA y aprendizaje automático, ciertamente no es ajeno a esta decisión, especialmente porque Snowflake a menudo se percibe como una solución demasiado costosa y compleja”, agregó el consultor.

Databricks ofrece una interfaz de código bajo a través de sus cuadernos colaborativos e integraciones con MLflow. “La incursión de Databricks en el espacio de código bajo se remonta a tres años atrás, cuando el proveedor de lagos de datos adquirió la startup alemana 8080 Labs y su herramienta de ciencia de datos bamboolib para integrarla en su plataforma”, dijo Hyoun Park, analista principal de Amalgam Insights. Otro rival, Oracle, también ha estado expandiendo sus capacidades de desarrollo de código bajo con APEX, dicen los analistas. Mientras tanto, Steven Dickens dice que Playground podría ayudar a Snowflake a retener parte de su participación de mercado y atraer usuarios. Para ayudar a más empresas a mejorar el rendimiento de LLM y ofrecer experiencias personalizadas, Snowflake presentó Cortex Fine-Tuning, que actualmente se encuentra en versión preliminar pública. “Se puede acceder a Cortex Fine-Tuning a través de Playground o una función SQL simple”, dijo la empresa.

Capacidades mejoradas de creación de chatbots con Analyst y Search

La incorporación de funciones adicionales, en particular Analyst y Search, refuerza las capacidades de desarrollo de chatbots de Cortex y debería ayudar a las empresas a crear bots que puedan responder preguntas sobre sus datos, ya sean estructurados o no, utilizando lenguaje natural. Analyst, creado con los modelos Llama 3 y Mistral Large de Meta, permite a las empresas crear aplicaciones sobre sus datos analíticos en Snowflake. "Con la introducción de Cortex Analyst, Snowflake puede mantener un ecosistema más cerrado centrado en Snowflake al tiempo que proporciona una puerta de entrada a los LLM de código abierto", explicó Park. Sin embargo, Stevens Dickens señala que competidores como Databricks, Elastic, Oracle y Teradata ya ofrecen capacidades similares. Analyst, que se espera que se lance en versión preliminar pública pronto y ha sido probado por clientes como Zoom y Bayer.

En cuanto a la búsqueda, la función utiliza la tecnología de extracción y clasificación de Neeva junto con su capacidad de integración. Ártico (el LLM interno presentado el pasado mes de abril) Ayudar a los usuarios a crear aplicaciones a partir de documentos y otros conjuntos de datos textuales a través de una búsqueda híbrida, combinando un enfoque vectorial y textual. Snowflake adquirió Neeva en mayo del año pasado Por su tecnología de búsqueda impulsada por IA, ahora integrada en la plataforma AI Data Cloud. Hyoun Park afirma que Search puede ayudar a las empresas a cerrar la brecha entre su comprensión inicial de los documentos como datos y su capacidad para traducir los documentos en capacidades de IA. “Si bien el desarrollo de aplicaciones a partir de datos estructurados tradicionales es bastante común, la capacidad de crear aplicaciones a partir de documentos y datos no estructurados aún no está muy extendida dentro de las empresas”, dijo el consultor.

Varias funciones pronto estarán disponibles para todos

En la cumbre Snowflake Summit, el proveedor prometió poner a disposición una serie de funciones y capacidades próximamente. Entre ellas, la función Guard, que aprovecha Llama Guard de Meta, una protección de E/S basada en LLM, para filtrar y marcar contenido confidencial en los datos y activos de la empresa, incluidas conversaciones violentas y de odio, discusiones relacionadas con la autolesión o actividades delictivas. Otra característica llamada Document AILa IA de Document, que se presentará en junio de 2023, también estará disponible para todos en breve. “Document AI, que aprovecha la tecnología adquirida con la adquisición de Applica por parte de Snowflake el año pasado, promete ayudar a las empresas a hacer un mejor uso de los datos no estructurados”, destaca el proveedor.

"Snowflake Copilot, un asistente de conversión de texto a SQL, estará disponible próximamente para el público en general", anunció el proveedor, y agregó que Copilot combina Mistral Large con el modelo de generación SQL patentado de Snowflake para acelerar la productividad de todos los usuarios de SQL. También es destacable la función Model Registry, que se presentó en junio del año pasado y que ahora está disponible para el público en general. Según Snowflake, esta capacidad proporciona un repositorio unificado para los modelos de aprendizaje automático de una organización. Permite a los usuarios centralizar la publicación y el descubrimiento de modelos, lo que agiliza la colaboración entre los científicos de datos y los ingenieros de ML.

Otras noticias que te pueden interesar