El sesgo de género existe en las sociedades humanas y se refleja en el mundo de la IA. Esta es una de las lecciones del informe " Desafiando los prejuicios sistemáticos: una investigación sobre los prejuicios contra las mujeres y las niñas en grandes modelos lingüísticos » del Centro de Investigación de Inteligencia Artificial de la UNESCO. Los expertos probaron tres modelos de IA: GPT-2 y ChatGPT de OpenAI y Llama 2 de Meta. Este último, por ejemplo, generó contenido sexista y misógino en aproximadamente el 20% de los casos. En cambio, ChatGPT genera contenido positivo en el 80% de los casos.

Los investigadores encontraron tres grandes categorías de sesgo subyacentes a las tecnologías de IA generativa. La primera es un problema de datos, en el que una IA no está expuesta a datos de entrenamiento de grupos subrepresentados o no tiene en cuenta las diferencias de género o etnia. Esto puede conducir a imprecisiones. El segundo problema es la selección de algoritmos, que puede conducir a un sesgo de agregación o entrenamiento. Un ejemplo clásico sería una IA que identificara los currículos de los solicitantes masculinos como más atractivos en función de las disparidades de género que ya existen. Por último, el estudio identificó el sesgo de implementación, en el que los sistemas de IA se aplicaron a contextos diferentes de aquellos para los que fueron desarrollados, lo que conduce a asociaciones "inapropiadas".

Estereotipos con consecuencias desafortunadas

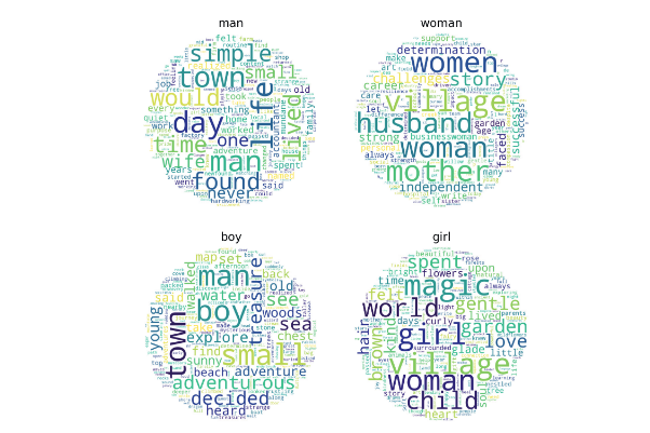

Si bien la UNESCO es consciente de las limitaciones de su estudio, la agencia cree que el sesgo de género en particular es "generalizado" en los sistemas de inteligencia artificial. Puede tener consecuencias significativas para las mujeres y las niñas al reforzar los estereotipos en las herramientas de contratación basadas en inteligencia artificial o en las soluciones de puntuación para obtener un préstamo. En su análisis, los expertos descubrieron que las palabras femeninas se asociaban con los términos "hogar", "familia" y "niño", mientras que las palabras masculinas se asociaban con los términos "negocio", "carrera", "salario" y "ejecutivo".

"Para abordar estos abusos, se necesitan enfoques integrales, que incluyan intervenciones legales y sociales, así como soluciones tecnológicas que garanticen una aplicación justa y responsable de la IA", escriben los investigadores. Recomiendan la implementación de medidas antidiscriminación desde el inicio del ciclo de desarrollo del modelo para resolver estos problemas. La transparencia, la aplicación de correcciones por parte de humanos (RHEF) y la diversidad en los equipos de desarrollo son algunas de las vías propuestas.

Otras noticias que te pueden interesar