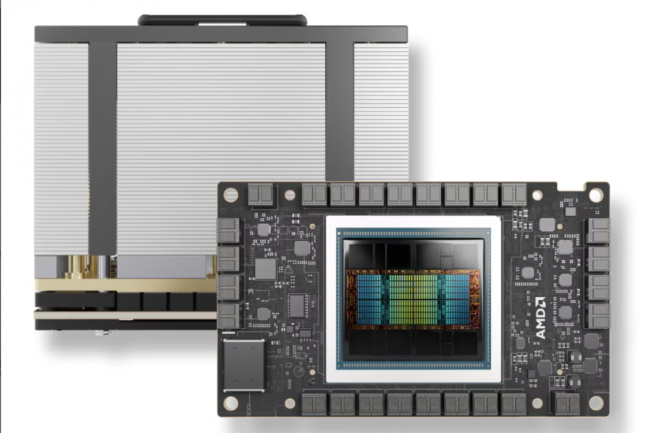

Para diversificar su oferta y competir, Dell ahora ofrece servidores PowerEdge con el último acelerador Instinct de AMD y brinda servicios de soporte de implementación y software para crear rápidamente aplicaciones de IA generativa. El PowerEdge XE9680 está disponible con aceleradores AMD Instinct MI300X (2,61 petaflops en el pico FP8), la GPU de gama alta de AMD que rivaliza con la generación de GPU Hopper de Nvidia. Diseñado para empresas que aprovechan la IA generativa, puede alojar hasta ocho aceleradores MI300X, con una memoria HBM3 combinada de 1,5 TB, lo que da como resultado una capacidad de cómputo máxima teórica de 42 petaflops en el pico FP8. Esta configuración está diseñada para un entrenamiento y una inferencia más rápidos de modelos de lenguaje grandes (LLM). Como parte de las pruebas, el tejano implementó un modelo Llama 2 de 70 mil millones de parámetros en un servidor con un solo acelerador MI300X. También ajustó el mismo modelo con precisión FP16 en un servidor Dell PowerEdge XE9680 equipado con ocho aceleradores AMD Instinct MI300X. El PowerEdge XE9680 viene con el software de administración de servidor centralizado OpenManage Enterprise para una implementación rápida y sencilla, software de automatización APEX AIOps y capacidades integradas de recuperación cibernética y seguridad de confianza cero.

Diseños validados para optimizar las implementaciones de GenAI

The Texan también ofrece su Diseño Validado para IA Generativa con AMD, un marco estándar para empresas que ejecutan sus propios LLM. Anunciados en mayo y disponibles hoy, los diseños validados tienen como objetivo facilitar a las empresas la implementación de sistemas de inferencia LLM y la personalización de modelos. “Esta guía de diseño proporciona a las empresas y a los desarrolladores una guía completa para implementar la inferencia LLM y la personalización de modelos, así como técnicas avanzadas como el ajuste fino y la generación aumentada de recuperación (RAG). Al basarse en estándares abiertos y reducir la necesidad de paquetes de software de IA patentados, los desarrolladores pueden simplificar el desarrollo y personalizar libremente los flujos de trabajo con modelos LLM de código abierto de socios como Hugging Face y Meta”, escribió Luke Mahon, director del equipo de ingeniería de marketing técnico de soluciones de IA de Dell. En una publicación de blog sobre estos productos y servicios..

En cuanto al software, el proveedor ofrece marcos basados en AMD ROCm para admitir LLM de código abierto como PyTorch, TensorFlow, ONNX-RT y JAX, así como la pila completa de controladores, kits de herramientas para desarrolladores y API para aceleradores AMD Instinct. Además, "Dell Omnia simplifica la creación y la gestión de clústeres de IA al automatizar la configuración para un procesamiento eficiente de la carga de trabajo", escribió Mahon. Omnia es un kit de herramientas de código abierto para implementar y administrar clústeres de alto rendimiento para cargas de trabajo de HPC, IA y análisis de datos. Para ayudar a los clientes con sus iniciativas de IA, Dell presentó en septiembre servicios de implementación de plataformas. Los consultores ayudarán a los clientes a establecer una plataforma para crear e implementar herramientas y marcos de IA. El proveedor también ofrecerá talleres de aceleración de medio día para ayudar a las empresas a determinar cómo pueden aprovechar al máximo la IA.

Otras noticias que te pueden interesar