Con los grandes avances en las soluciones de IA generativa, las plataformas de procesamiento están mejorando para hacer frente a este aumento. Si Nvidia ahora está liderando el camino con sus aceleradores GPU, también debe contar con que sus socios proporcionen la parte crucial del almacenamiento. "La idea es mantener activas las GPU proporcionándoles el flujo de datos necesario: hasta 900 Gb/s de lectura y 780 Gb/s de escritura en los SuperPods", explicó Derek Dicker, CMO de DDN (DirectData Networks) durante una conferencia de TI. Gira de prensa en Silicon Valley a principios de junio. Históricamente comprometida con HPC, DDN se beneficia de la popularidad de los sistemas de computación intensiva DGX de Nvidia (chips Xeon y acelerador H100 en los últimos modelos). El proveedor dice que tiene más reservas de matrices (bloques) de almacenamiento de IA en el primer trimestre de este año que en todo el año anterior y que 2022 ha sido muy sólido. “Hoy contamos con 5.000 sistemas DGX”, asegura el gerente. “Hace cuatro años, sentimos que era necesario hacer inversiones en la capa de software, la capa de hardware y la capa de integración para mejorar la optimización del almacenamiento para la IA y actualmente estamos en la segunda ola. [IA]. El primero realmente comenzó con una gran cantidad de análisis de imágenes y videos, conducción autónoma, ciencias biológicas y, por supuesto, servicios financieros". Así que DDN todavía está montando esta ola y trabajando con Nvidia y sus sistemas DGX como os explicamos en 2018.

“Hoy en día, las oportunidades son muy amplias, porque estos nuevos grandes modelos lingüísticos son multimodales, lo que significa que pueden aplicarse no sólo a lenguajes literales, sino también al ADN, las imágenes y el vídeo. La computación acelerada, un concepto inventado por Nvidia, abarca esencialmente la llegada de las GPU para acelerar el trabajo al paralelizar todo de una manera muy detallada lejos de las CPU. Y la computación acelerada abarca la idea de optimización completa. Y eso significa que, en nuestro caso, la pila se extiende desde el usuario final, el panel de control, hasta las aplicaciones, pasando por las GPU, la red y el almacenamiento”.

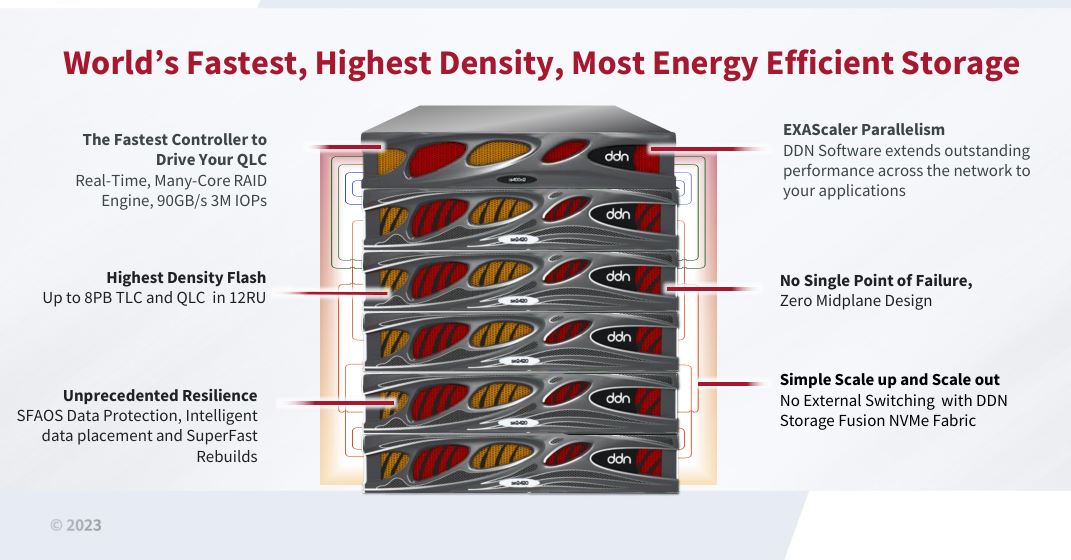

Con la versión QLC de la bahía A1400x2, DDN sube a 8 PB en 12U y anuncia un rendimiento de 3 millones de IOPS. (Crédito SL)

QLC para aumentar la capacidad de almacenamiento

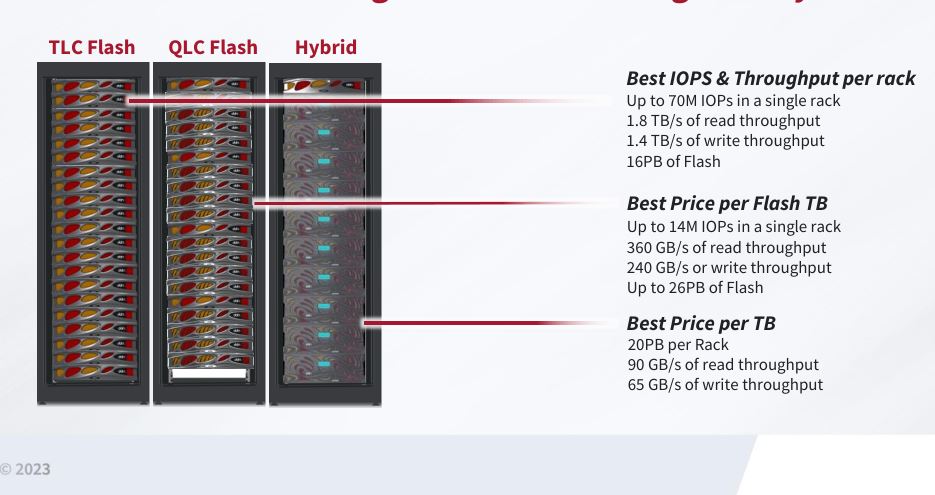

Además de su colaboración con Nvidia, que acaba de actualice sus sistemas DGX con los últimos chips Intel Xeon Sapphire Rapids mientras pones Un pie en la nube para el cálculo de compensación.es decir, DDN actualiza el A1400), para combinar velocidad y capacidad (hasta 1,45 PB en un chasis de 2U y 8 PB en un rack de 12U). “ La tecnología flash de cuatro celdas reduce el coste por gigabyte en comparación con la generación anterior TLC. Aquí tenemos un A1400x2, con un controlador en la parte superior, y admitimos hasta cinco gabinetes de expansión QLC con un sistema de archivos paralelo. Lo que proporciona algo así como ocho petabytes de almacenamiento flash sin formato a un costo mucho menor que TLC (aproximadamente la mitad del precio), al tiempo que garantiza que el rendimiento siga siendo alto para los usuarios finales en términos de IOPS y velocidades de lectura/escritura. Logramos este rendimiento sin utilizar una red back-end compleja y sin conmutación externa”, asegura el CMO. Aunque los SSD QLC son más lentos que los TLC, almacenan más datos, lo cual es muy interesante en los sistemas HPC para IA ya que se procesan grandes volúmenes de datos para alimentar los modelos.

DDN no ha renunciado a los discos duros, que siguen ofreciendo una atractiva relación capacidad/precio/rendimiento con un sistema paralelo. (Crédito SL)

Por supuesto, DDN no es el único proveedor que adopta QLC en sus matrices de almacenamiento (Pure Storage, Vast Data y NetApp también han dado el paso), pero se destaca por intentar lograr un gran avance en el mundo HPC.

Otras noticias que te pueden interesar