Con una quincena de anuncios de productos en su última conferencia Dash 2024 a finales de junio en Nueva York (que reunió a 3.000 participantes), el especialista francés en observabilidad, pero también en gestión del rendimiento de aplicaciones (APM), seguridad, etc., Datadog ha hecho todo lo posible. "Hemos ampliado significativamente nuestra cartera, pero siempre con la vista puesta en ampliar nuestra filosofía básica en torno a la observabilidad para identificar los problemas que pueden encontrar nuestros clientes", explica Yrieix Garnier, vicepresidente de productos de Datadog. Porque además de su posicionamiento histórico en este segmento de mercado (en el que compite desde hace años con otros líderes del sector como Cisco/Splunk, BMC, New Relic, etc.), el editor francés ha añadido muchas más cuerdas a su arco con el tiempo. "Hemos ampliado a APM, gestión de registros y seguridad para completar nuestra plataforma de datos única manteniendo toda su consistencia", continúa Yrieix Garnier.

Esta acumulación de soluciones y funciones adicionales no se hace en detrimento de las necesidades históricas de los clientes, sino todo lo contrario, ya que según la editorial, la mayoría de sus clientes utilizan al menos dos de sus soluciones y algunos llegan a acumular entre 8 y 10. "Desde hace varios años, añadimos valor a nuestros productos con innovaciones que se extienden a todas nuestras áreas", afirma Yrieix Garnier, precisando de paso que Datadog destina más de 600 millones de dólares al año a su investigación y desarrollo.

Observabilidad de LLM en GA y escalado automático de Kubernetes en versión beta

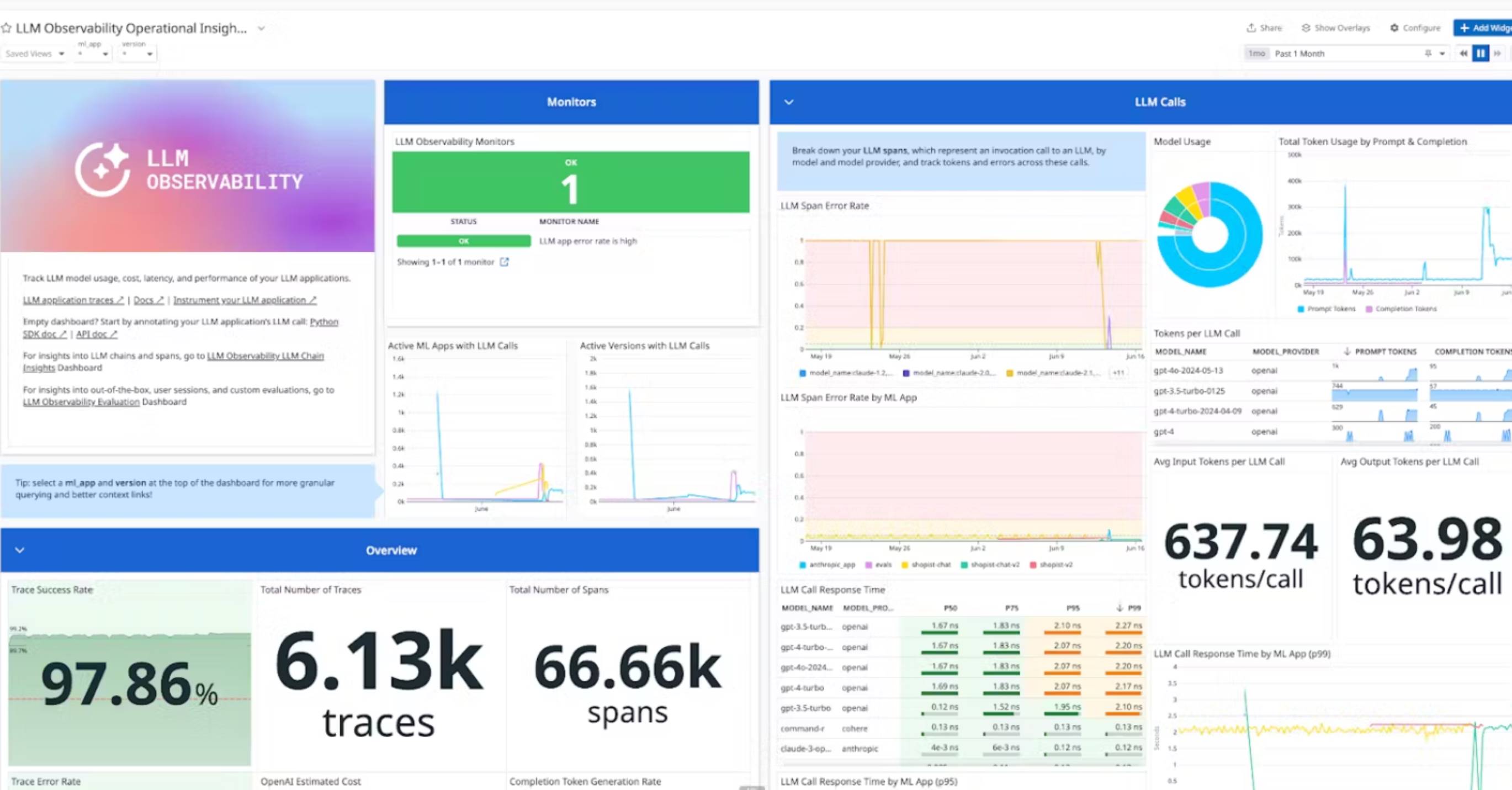

Entre los anuncios que se hicieron durante la conferencia Dash, algunos se destacan. Empezando por su solución de observabilidad dedicada a LLM (LLM Observability) La observabilidad de las aplicaciones desarrolladas con LLM y GenAI permite seguir todas las fases de su desarrollo hasta su puesta en producción para poder informar de todos los problemas, explica Yrieix Garnier. Los tipos de problemas detectados son variados: problema de calidad de un chatbot, alucinación, toxicidad de una respuesta, fallo de seguridad, etc. Esta observabilidad se basa en criterios relevantes para la empresa y personalizables en función de sus expectativas. "Esto permite, por ejemplo, en el caso de una tienda online, detectar un problema de calidad con una respuesta de chatbot porque el LLM en el que se basa no ha sido entrenado en un catálogo en particular", explica Yrieix Garnier. Cabe destacar que la solución de observabilidad LLM de Datadog es agnóstica y funciona igual de bien con OpenIA GPT, Claude Anthropic o Google Gemini.

Panel de observación de LLM. (crédito: Datadog)

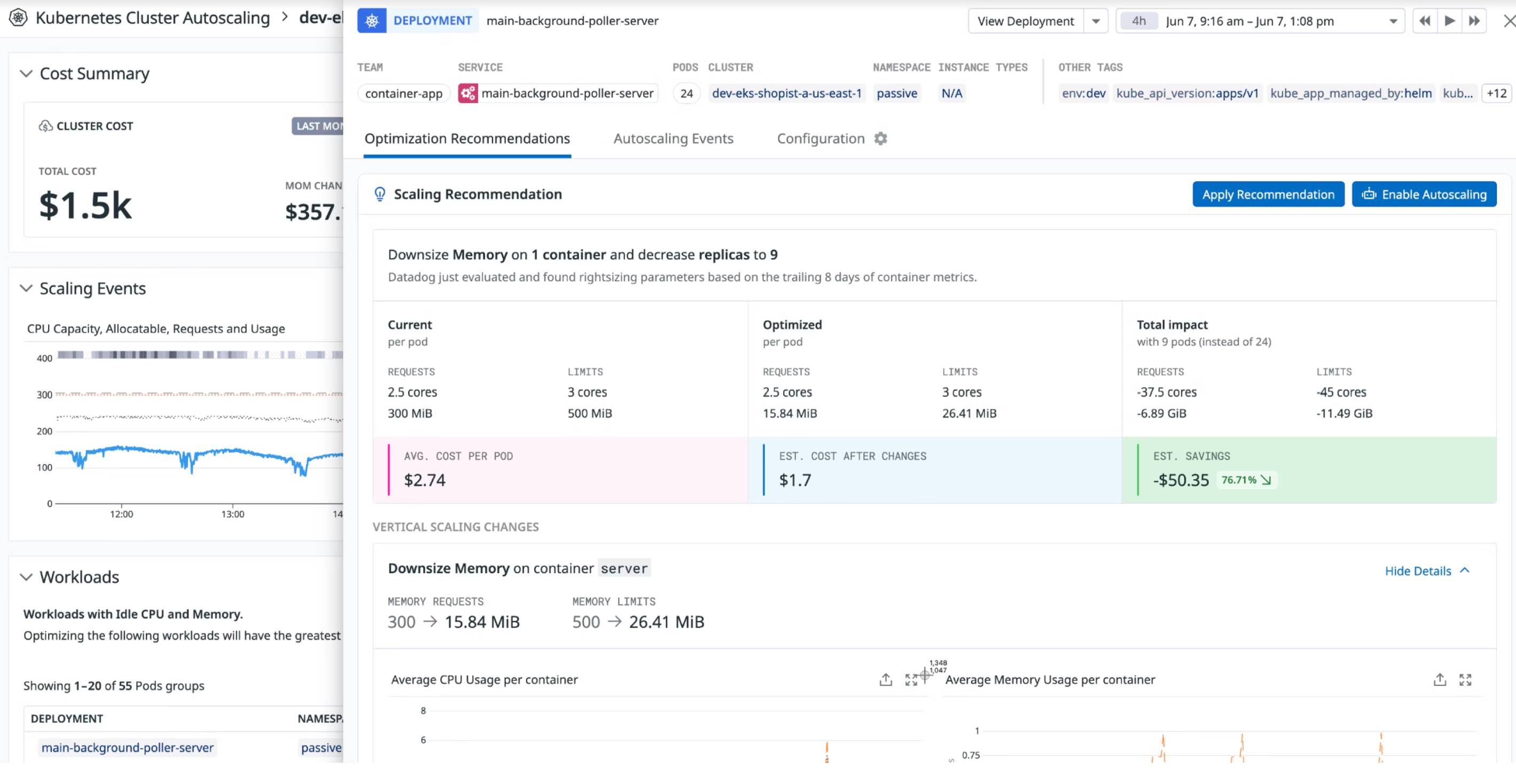

La función de escalado automático de recursos de Kubernetes (Kubernetes Autoscaling) está llegando a la versión beta. ¿Su objetivo? Aumentar la visibilidad de los clústeres de contenedores y determinar automáticamente su aprovisionamiento (CPU, memoria, etc.) en función de su nivel de uso. "Esto permite utilizar menos recursos del servidor y asignar exactamente la cantidad y el tipo de recursos necesarios para ejecutar las instancias de Kubernetes", afirma Yrieix Garnier. Confiando en la relevancia de su oferta, Datadog también utiliza este producto para sus propios fines internos. "Nos dimos cuenta de que el 65% de los clústeres de clientes utilizan menos de la mitad de los recursos que se les asignan y el escalado automático reduciría la cantidad de instancias innecesarias, reduciría la huella de servidor y generaría ahorros de electricidad", explica el directivo. Datadog no es el único al que le ha convencido, también es el caso de varias decenas de clientes del editor.

Panel de control de escalado automático de Kubernetes. (crédito: Datadog)

Otras noticias que te pueden interesar