El especialista en la casa del lago tiene ambiciones en la IA generativa. Hace dos semanas presentó un LLM (modelo de lenguaje grande) llamado Muñequita. A diferencia de GPT, este modelo no compite por la cantidad de parámetros. Dolly funciona tomando un modelo de código abierto existente de 6 mil millones de parámetros (en comparación con los 175 mil millones de GPT 3.5). Dato curioso, el nombre del modelo. Ladrillos de datos se refiere a la primera oveja clonada, ya que es un clon del modelo Alpaca desarrollado por académicos de Stanford, basado a su vez en LLAMA de Meta. Las pruebas realizadas con Dolly arrojaron resultados bastante relevantes, señala Databricks, que también se jacta de haber entrenado el modelo por menos de 30 dólares.

Hoy, la compañía lanza Dolly 2.0, un sistema de 12 mil millones de parámetros basado en la familia de modelos pythia de EleutherAI y refinado exclusivamente en un nuevo conjunto de datos de seguimiento de instrucciones generados por humanos de alta calidad, obtenidos mediante crowdsourcing entre los empleados de Databricks. El modelo completo está disponible gratuitamente, incluido el código de entrenamiento, el conjunto de datos y los pesos del modelo, “todos aptos para uso comercial”, especifica el proveedor en un comunicado de prensa. En pocas palabras, cualquier organización puede crear, poseer y personalizar LLM que puedan hablar con las personas, sin tener que pagar por el acceso a la API ni compartir datos con terceros.

Un conjunto de datos de Databricks

Para que conste, Dolly 1.0 fue entrenada por la modesta suma de 30 dólares utilizando un conjunto de datos que el equipo de Stanford Alpaca había creado utilizando la API OpenAI. Este conjunto de datos contenía los resultados de ChatGPT y, como señaló el equipo de investigadores, los términos de servicio pretenden evitar que alguien cree un modelo que compita con OpenAI. Entonces, para solucionar este problema, Databricks comenzó a buscar formas de crear otro conjunto de datos. Según el artículo de investigación de OpenAI, la empresa descubre que el modelo InstructGPT original se entrenó en un conjunto de datos que incluía 13.000 demostraciones de instrucción siguiendo el comportamiento. Inspirándose en esta experiencia, Databricks buscó lograr un resultado similar con sus empleados.

Su conjunto de datos de capacitación de código abierto, llamado databricks-dolly-15k, fue creado por más de 5000 empleados del grupo durante marzo y abril de 2023. "Estas grabaciones de capacitación son naturales, expresivas y están diseñadas para representar una amplia gama de comportamientos, desde lluvia de ideas y desde generación de contenido hasta extracción y síntesis de información”, se especifica en detalle, databricks-dolly-15k contiene 15.000 archivos generados por humanos de alta calidad. pares de solicitud/respuesta diseñados específicamente para escalar LLM. Según los términos de la licencia databricks-dolly-15k (Licencia Creative Commons Attribution-ShareAlike 3.0 Unported), cualquiera puede usar, modificar o ampliar este conjunto de datos para cualquier propósito, incluidas las aplicaciones comerciales.

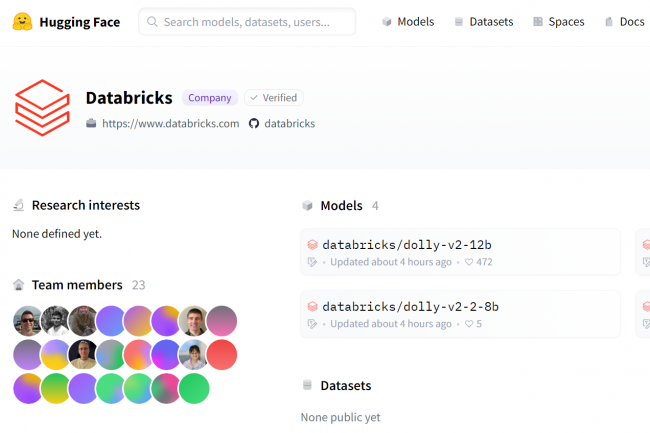

Disponible en GitHub y Hugging Face

Para descargar el modelo Dolly 2.0, simplemente vaya a página abrazando la cara (biblioteca de PNL de código abierto que ofrece una API que accede a varios modelos previamente entrenados) de Databricks y visite el directorio Dolly en databricks-labs para descargar el conjunto de datos databricks-dolly-15k. Este último también es disponible en GitHub.

Otras noticias que te pueden interesar