El avance de Deepseek ha causado un poco de revuelo en el mundo de LLM. Al punto de que varias alternativas han surgido como se muestra Alibaba con Qwen 2.5 o Mistral con su SLM pequeño 3. En este concierto, es necesario contar con Tülu 3 dibujado por A2I (Allen Institute for AI). Este instituto de investigación sin fines de lucro fue creado en 2014 por Paul Allen, cofundador de Microsoft con Bill Gates. El último modelo se llevó a más de 405 mil millones de parámetros y compite según la organización con Deepseek V3 y GPT-4O de OpenAI. Presentado en noviembre pasado, la primera versión de Tülu 3 pretendía igualar el rendimiento de Claude d'Anthropy y Gemini por Google.

Publicado en código abierto, Tülu 3 405B se destaca de sus competidores por un enfoque diferente al post-entrenamiento. AI2 se basa en el "proceso de aprendizaje de refuerzo de recompensas verificables (RVLR)". Este método utiliza resultados verificables, como la resolución correcta de los problemas matemáticos, para refinar el rendimiento del modelo. Se ha asociado con las preferencias directas (DPO) para ajustar directamente los modelos de acuerdo con las preferencias humanas y los datos de entrenamiento cuidadosamente seleccionados (ajuste fino supervisado).

Buenos resultados y un enfoque de código abierto completamente abierto

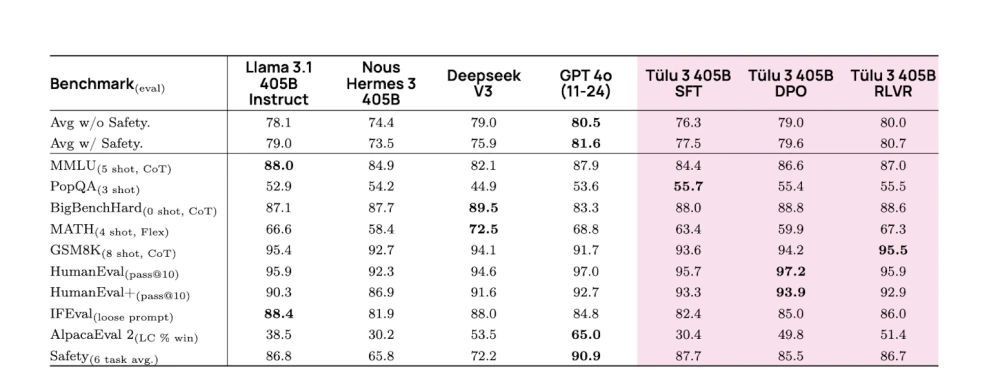

A nivel técnico, este enfoque proporciona mejoras como un tratamiento paralelo más efectivo en 256 GPU, sincronización optimizada de los pesos LLM y la distribución equilibrada de los cálculos en 32 nudos. El sistema basado en RVLR ha obtenido mejores resultados en 405 mil millones de parámetros que los modelos equivalentes. También logró resultados particularmente buenos en GSM8K (conjunto de datos en varios diplomas de ciencias o literarios), superando a Deepseek V3, Llama 3.1 y Hermes 3 (Creado por Tohfa Siddika Barbuiya, investigador en Australia). Cabe señalar que la efectividad de la técnica RLVR aumenta con el tamaño del modelo, lo que sugiere las posibles ventajas para un modelo más grande. En comparación, Deepseek se vuelve más eficiente al destilar modelos más pequeños, como Recientemente indicó Alexei Grinbaum, directora de investigación de CEA.

Las evaluaciones Tülu 3 405B en comparación con la competencia, realizadas por AI2, con los diferentes tipos de optimización del modelo. (Crédito de la foto: AI2)

Otro activo de Tülu 3, para ser realmente de código abierto. De hecho, Deepseek o Llama también se definen como abiertos, pero parte del código no está disponible, en particular datos de capacitación. "No expresamos conjuntos de datos cerrados", dijo Hannaneh Hajishirzi, investigador de la Universidad de Washington y miembro de A2I, en un blog. Ella agrega: "" En cuanto a nuestra primera versión de Tülu 3 en noviembre de 2024, publicamos Todo el código de infraestructura ». Este enfoque brinda a los usuarios la capacidad de personalizar fácilmente su tubería a partir de la selección de datos de evaluación. Si el modelo 405B está disponible en la página AI2 Tülu 3, también es posible probar la funcionalidad en AI2 Space de parque infantil.

Otras noticias que te pueden interesar