Unas semanas después de Intel y su Xeon 6, AMD anunció sus últimos procesadores dedicados a la inteligencia artificial y el cálculo de alto rendimiento durante su evento AI avanzado en San Francisco, en particular la quinta generación de sus chips Epyc 9005 Turin (de 8 a 192 núcleos con una frecuencia de hasta 5 GHZ) para los servidores y aceleradores gpu. Los compromisos por parte de grandes clientes y socios, como Microsoft, OpenAI, Meta, Oracle y Google Cloud, también marcaron este evento. Las CPU EPYC de quinta generación están disponibles en dos configuraciones distintas, las cuales son parte de la misma familia 9005, también llamada Turín. La versión de escala tiene núcleos Zen 5 optimizados para el máximo rendimiento, según AMD. Los modelos de escala están equipados con corazones compactos Zen 5C, un concepto introducido este año con la línea Bérgamo Zen 4C. Intel adopta una estrategia similar con sus corazones de rendimiento y eficiencia, pero sus núcleos de efectividad se obtienen al eliminar ciertas instrucciones, lo que puede representar riesgos para la compatibilidad de las aplicaciones. AMD, por su parte, obtuvo sus corazones compactos al limitar el tamaño del caché y la velocidad del reloj, mientras conservaba todas las instrucciones.

Las CPU Zen 5 tienen hasta 128 núcleos y 256 hilos y se fabrican con el proceso TSMC de 4 nm. Grabado en 3 nm, todavía en TSMC, los chips Zen 5C ofrecen hasta 192 núcleos y 384 hilos. Los procesadores Zen 5 tienen un consumo de energía máximo de 500 vatios, mientras que los modelos 5C de 390 vatios. Por el lado de los músculos, AMD afirma que su procesador estrella, el EPYC 9965 a 192 núcleos, es 2.7 veces más rápido que el competidor Xeon de Intel, el Platinum 8952+ (Capas de esmeralda o un xeon de la quinta generación). AMD también afirma que el video codifica cuatro veces más rápido, el rendimiento 3.9 veces mayor en las aplicaciones de cálculo de alto rendimiento, y hasta 1.6 veces más rendimiento por corazón en entornos virtualizados.

Los instintos atacan a Nvidia

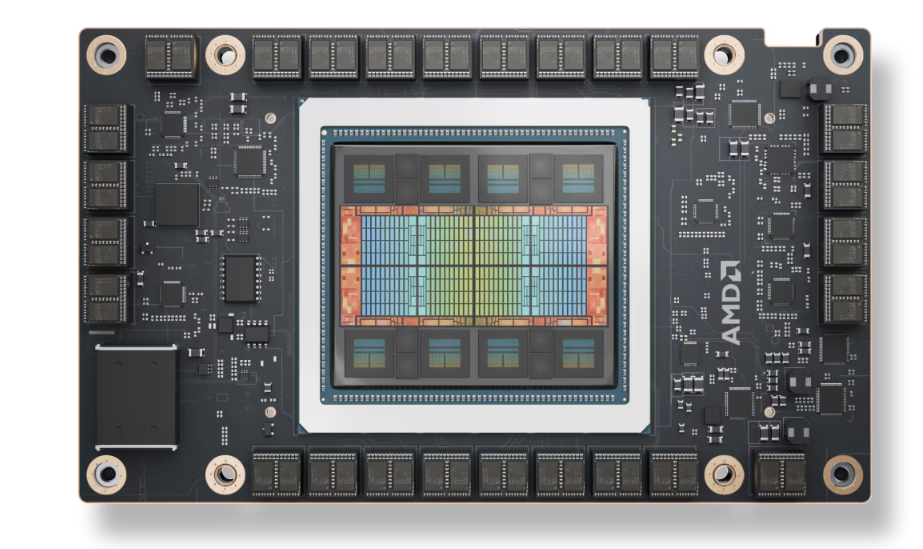

AMD busca librar una guerra contra dos frentes, tanto contra Intel como Nvidia. La compañía tiene la intención de competir con Nvidia en el campo de los aceleradores para la inteligencia artificial con su GPU instinto. Aunque solo tiene una fracción del mercado de Nvidia, AMD todavía ha registrado éxitos, especialmente con el supermercado más rápido del mundo, la frontera. Para lograr este objetivo, AMD comercializa el instinto MI325X con una capacidad y un ancho de banda de memoria más alto que el del instinto MI300X, que se lanzó en diciembre pasado. El MI325X se basa en la misma arquitectura de GPU de ADNc 3, con 192 GB de gran ancho de banda HBM3 y 5.3 TB de ancho de banda de memoria, contra 3.9 Tb/s para el MI300X. AMD afirma que el rendimiento de inferencia de IA en MI325X proporciona una capacidad de tratamiento más rápida del 40 % con un modelo mixtral con 8 grupos y 7 mil millones de parámetrosen comparación con la tolva H200 de Nvidia (ahora excedida por Blackwell Chip y GB200 Acelerators). El MI325X también tiene una latencia 30 % menor con un modelo mixto de 7 mil millones de parámetros, y una latencia 20 % menor con un modelo LLAMA 3.1 de 70 mil millones de parámetros.

Los aceleradores de instinto MI325X, basados en la arquitectura de ADNc 3, operan 192 GB de memoria HBM3. (Crédito AMD)

Para progresar en el mercado de HPC, AMD planea lanzar una plataforma de ocho nodos para el próximo año, similar a los servidores NVIDIA DGX. Con ocho GPU MI325X conectado a través de la fabricación infinita de AMD, esta plataforma ofrecerá 2 TB de memoria HBM3E, 48 TB de ancho de banda de memoria total, 20.8 petaflops de rendimiento en FP8 y 10.4 petaflops de rendimiento en FP16, según el proveedor de Santa Clara. El MI325X se enviará a Dell Technologies, Lenovo, Supermicro, Hewlett Packard Enterprise, Gigabyte y varios otros proveedores de servidores del próximo año, dijeron la compañía.

Otras noticias que te pueden interesar