En vivo desde Las Vegas. Aprovechando su conferencia en Las Vegas, Copo de nieve ha ampliado el alcance de Snowpark, su marco de desarrollo, presentado en junio de 2021 y disponible para todos desde finales de enero de 2022. Este último ayuda a los desarrolladores a crear canales y aplicaciones escalables, así como flujos de aprendizaje automático directamente en la plataforma utilizando sus lenguajes favoritos. y bibliotecas. Durante el evento, la empresa anunció Snowpark Container Services ampliando su marco a través de un tiempo de ejecución de Kubernetes o Docker para diferentes aplicaciones. En este contexto, el editor se ha asociado con docenas de proveedores externos de software y aplicaciones, incluidos Alteryx, Astronomer, Dataiku, Hex, Nvidia, SAS, por nombrar algunos, para ofrecer a los clientes acceso seguro a una amplia gama de productos. y soluciones dentro de su cuenta Snowflake.

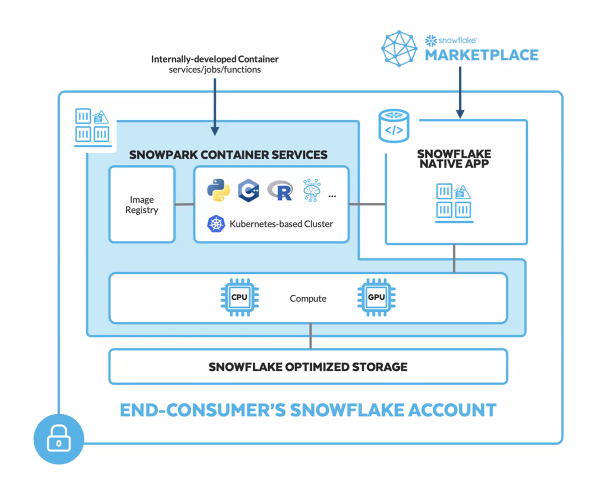

Snowpark Container Services ofrece así acceso a un amplio catálogo, que incluye modelos de lenguajes grandes (LLM), portátiles y herramientas MLOps. Por ejemplo, en términos de aceleración informática, los usuarios podrán confiar en las GPU de Nvidia y el software de inteligencia artificial para ejecutar más cargas de trabajo dentro de la plataforma de Snowflake. Para David Wallace, director de investigación de datos y análisis de clientes de IDC, este acceso es esencial hoy en día: “En un contexto donde la cantidad de datos de clientes en los almacenes de datos continúa creciendo, el acceso de autoservicio a la información es esencial”. Además, Snowpark Container Services se puede utilizar como parte de la oferta de aplicación nativa (versión preliminar pública en AWS). En este caso, los desarrolladores pueden distribuir aplicaciones que se ejecutan completamente dentro de la cuenta Snowflake de su cliente final. “Los avances de los productos de Snowflake están revolucionando la forma en que los clientes construyen en la nube de datos, permitiendo a los científicos de datos, ingenieros de datos y desarrolladores de aplicaciones beneficiarse de una amplia programabilidad y amplitud de casos de uso para que puedan construir, probar e implementar todo lo que puedan soñar, sin compromiso”, dijo Christian Kleinerman, vicepresidente senior de Snowflake Products.

Snowpark Container Services es un complemento de Snowpark que ayuda a los desarrolladores a guardar e implementar archivos estáticos no editables ("imágenes de contenedor") en Snowflake. (Crédito: CS)

Facilitando la vida diaria de los desarrolladores, una y otra vez

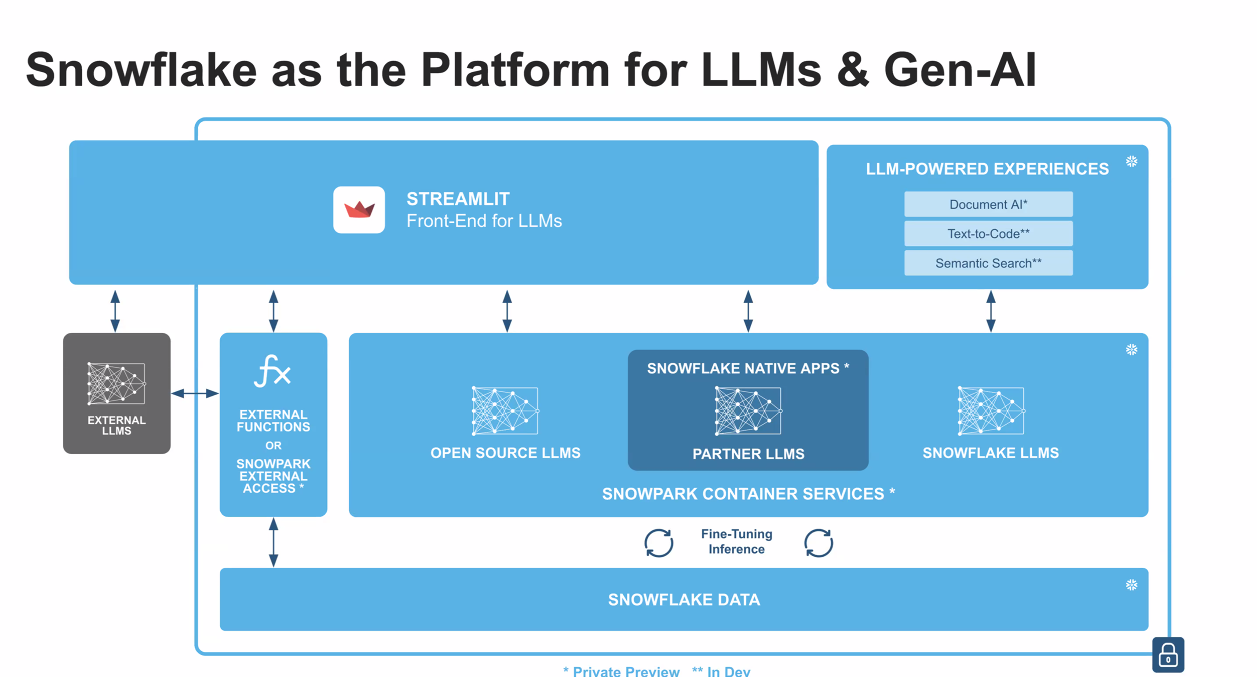

Al ampliar las capacidades para ejecutar una variedad de cargas de trabajo, incluidas aplicaciones completas, alojamiento LLM y capacitación de modelos, Snowflake abre claramente las posibilidades. El anuncio hecho deuna asociación con Nvidia a principios de semana es prueba de ello. A través de esta colaboración, los clientes de Snowflake tendrán acceso a Nvidia AI Enterprise, el pilar de software de la plataforma Nvidia AI, a través de Snowpark Container Services. La plataforma incluye más de 100 marcos, modelos previamente entrenados y herramientas de desarrollo como PyTorch para capacitación, Rapids para ciencia de datos y Triton Inference Server para implementaciones de producción de IA. De hecho, para el lanzamiento de este producto, Snowflake ha creado un círculo restringido de asociaciones para probar su tecnología en diferentes entornos con distintos casos de uso. Amplitude, especialista en análisis de productos, ya ha anunciado una aplicación nativa en Snowflake que utiliza Snowpark Container Services. Con esta aplicación, los clientes de ambas empresas pueden acceder más fácilmente a información sobre el comportamiento del usuario en autoservicio, directamente desde su instancia de Snowflake. Esto incluye “comprender mejor cada etapa del recorrido del cliente, estimular el crecimiento de usuarios activos, aumentar la retención o incluso mejorar la monetización”. Este es uno de los primeros casos concretos revelados tras el anuncio del producto.

Snowflake integra su solución Container Services en las distintas fuentes de LLM, así como en su Data Cloud y Streamlit en particular. (Crédito: CS)

Al mismo tiempo, Snowflake anunció otras herramientas dedicadas al desarrollo. Estos avances incluyen un conjunto de API de Snowpark ML para un desarrollo de modelos más eficiente (disponible en vista previa pública), Snowpark Model Registry (Registro de modelos en vista previa privada) para MLOps escalables, integración nativa de Git (vista previa privada) para admitir flujos de trabajo de CI/CD y la interfaz de línea de comandos (CLI) nativa (vista previa privada) para optimizar el desarrollo y las pruebas. Dedicadas a los ingenieros de datos, estas herramientas deberían ayudarlos a trabajar de manera más fácil y rentable con datos que requieren baja latencia, sin tener que ensamblar soluciones o crear canales de datos adicionales. Finalmente, la firma declaró que avanza en el camino de integrar Streamlit, una Start-up comprada por Snowflake por 800 millones de dólares. Este último tenía como objetivo construir un proyecto de código abierto para facilitar la creación de aplicaciones personalizadas para interactuar con datos. Como parte de esta integración, Snowflake dice que los científicos de datos y otros desarrolladores de Python podrán "aumentar el impacto de su trabajo mediante la creación de aplicaciones que cierren la brecha entre los datos y la acción empresarial".

Otras noticias que te pueden interesar