Un año después de lanzar su LLM a 7 mil millones de parámetros, AI Mistral Continúa su exploración de modelos más pequeños. En este nicho, conocido como SLM (modelo de lenguaje pequeño) no es el único. Todos los actores (antrópico, Meta, Google ...) también están presentes y ofrecen modelos capaces de ejecutarse en sistemas móviles, que no son muy gourmet en recursos y especializados en tareas específicas.

El joven brote francés completa su rango con la versión minisral en 3B y 8B. "Estos modelos establecen un nuevo borde en términos de conocimiento, sentido común, razonamiento, pidiendo funciones y eficiencia en la categoría inferior a 10B, y se pueden usar o adaptar a una variedad de usos, la orquestación de flujos de trabajo generativo a la creación de tareas especializadas", explicar Mistral ai.

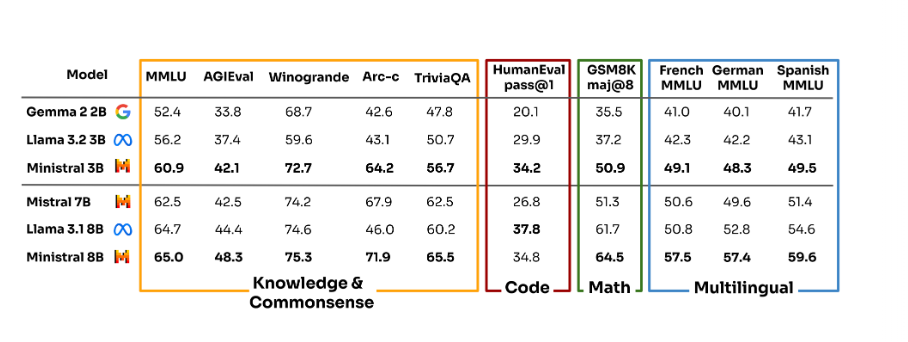

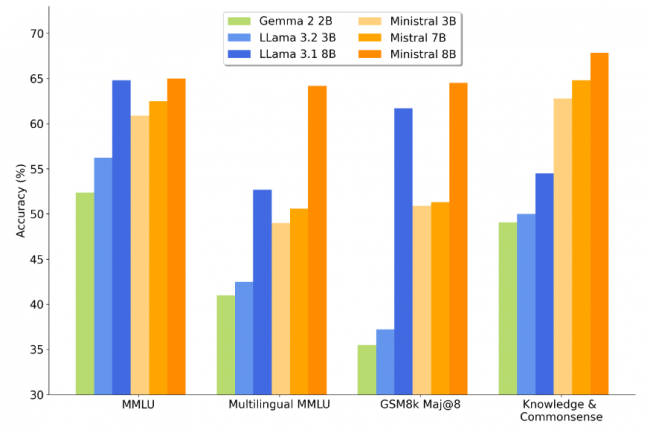

Comparación de los modelos Mini 3B y 8B con Gemma 2 2B, Llama 3.2 3B, Llama 3.1 8B y Mistral 7B en varias categorías. (Crédito: AI Mistral)

De $ 0.04 por millón de tokens en la entrada/salida

Estos últimos modelos también han sido diseñados para satisfacer la demanda de empresas en términos de inferencia local de modelos para salidas variadas en terminales móviles, incluida la traducción, la asistencia vocal, el análisis, la robótica autónoma ... con puntos comunes de la eficiencia de cálculo como una latencia baja.

"Utilizado en conjunto con modelos de idiomas más amplios como Mistral grande, los" ministeriales "también son intermediarios efectivos para llamar a las funciones en flujos de trabajo generativos. Se pueden configurar para administrar el análisis de entrada, el enrutamiento de tareas y la llamada API de acuerdo con la intención del usuario en múltiples contextos", dice el editor. Todos con un costo de uso modesto, en este caso $ 0.04 por millón de tokens (entrada/salida) para Minisral 3B (Licencia comercial Mistral) y $ 0.1 para el Ministro 8B (Licencia comercial y Licencia de Investigación Mistral.

Otras noticias que te pueden interesar