Los Genai y las alucinaciones van de la mano, cualquiera que sea la calidad de la capacitación de modelos de idiomas grandes que subyacen a las herramientas de inteligencia artificial generativa. Es por eso Microsoft presentado esta corrección del martesUna funcionalidad de su herramienta de seguridad de contenido Azure AI que, según ella, los puntos, luego corrige, las respuestas del Genai que no están directamente vinculadas a las fuentes de datos utilizadas para formar una LLM, en otras palabras, alucinaciones. "Permitir que nuestros clientes comprendan y actúen sobre contenido infundado y alucinaciones es crucial, especialmente porque la demanda de confiabilidad y precisión en el contenido generado por la IA continúa aumentando", dijo Microsoft En una publicación de blog.

Si las "herramientas complementarias" pueden ayudar a verificar la precisión de los resultados de LLM, Gartner descubrió que el uso de mejores técnicas de investigación de recuperación (RAG) debería ser un primer paso para mitigar las alucinaciones. "Aconsejamos a los clientes que utilicen la investigación para proporcionar información que arregle la respuesta de LLM en el contexto de la empresa", dijo Jason Wong, analista y distinguido vicepresidente de Gartner. El RAG es un método que crea un modelo Genai más personalizado gracias a una serie de preguntas y respuestas proporcionadas a un LLM, que proporciona respuestas más precisas y más específicas a las solicitudes.

Compatible con Llama y GPT-4O

Además de Google, una serie de nuevas empresas y otros proveedores de servicios en la nube han ofrecido herramientas para monitorear, evaluar y corregir los problemas de los resultados de Genai con la esperanza de eliminar los problemas sistémicos. La corrección es una de varias actualizaciones en Azure AI Studio, una herramienta de evaluación de riesgos y también la seguridad híbrida de contenido de IA Azure (AACS) un SDK integrado para el tratamiento de la IA. Esta herramienta está disponible como parte de la API de seguridad de contenido Azure AI actualmente en beta y puede usarse con cualquier modelo Genai basado en texto, incluidos Meta y OpenAi Meta y GPT-4O. Sin embargo, los analistas son escépticos de la eficiencia de corrección para eliminar los errores. "Las alucinaciones continúan obstaculizando la implementación de la IA generativa", dijo Wong. "Todos los hiperscalers han lanzado productos para aliviar las alucinaciones, pero ninguno promete eliminarlos por completo o incluso alcanzar ciertos umbrales de precisión".

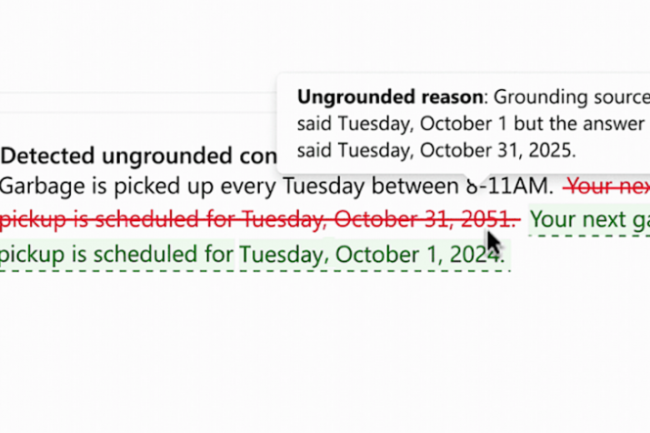

Microsoft presentó corrección por primera vez en marzo. Para usarlo, una aplicación Genai debe conectarse a documentos básicos, que se utilizan en los escenarios resumidos de documentos y preguntas y respuestas basadas en el trapo, dijo Microsoft. Desde entonces, los clientes han estado pidiendo lo que pueden hacer una vez que se detecta información errónea, excepto que los bloqueen. "Esto destaca un desafío importante en el panorama generativo de IA que evoluciona rápidamente, donde los filtros de contenido tradicionales a menudo son insuficientes para responder a los riesgos únicos que plantean las alucinaciones de la IA generativa", escribió Katelyn Rothney, gerente de marketing de productos de Microsoft, En una publicación de blog. Según el sistema de detección de anclaje existente, la herramienta de corrección permite que la seguridad del contenido de AI de Azure identifique y corrija las alucinaciones en tiempo real, antes de que los usuarios de aplicaciones generativas de IA las cumplan. La herramienta funciona señalando primero el contenido infundado. Luego, el sistema de seguridad Azure lanza un proceso de reescritura de tiempo real para revisar las piezas inexactas y garantizar la alineación con las fuentes de datos conectadas.

Eliminar alucinaciones, misión imposible?

"Esta corrección se lleva a cabo antes de que el usuario pueda ver el contenido infundado inicial", dijo Rothney. "Finalmente, el contenido corregido se devuelve al usuario. La naturaleza alucinante de la tecnología Genai, como GPT-4 de OpenAI, Llama 2 de Meta y Palm 2 de Google, se debe al hecho de que sus modelos fundamentales se basan en parámetros o opciones masivas, amorfas y no espectativas de las cuales el algorithm puede elegir respuestas. Si el Genai es más preciso en sus respuestas en sus respuestas en sus respuestas, en sus respuestas, en sus respuestas, a sus respuestas, a las que se produce a la mayor parte a sus respuestas a sus respuestas a sus respuestas a sus respuestas a sus respuestas a las respuestas a las que se produce a la mayor parte a sus respuestas a sus respuestas a sus respuestas a las respuestas a las que se produce a las veces más precisas a sus respuestas a sus respuestas a las que se produce a la vez que es más preciso, a sus respuestas a sus respuestas a sus respuestas a las que se produce a la mayor parte, a las que se produce la información. No se suponía que fuera, solo para poder proporcionar una respuesta, cualquier respuesta.

De hecho, el LLM es similar a los "loros estocásticos"; a medida que crecen, se vuelven más aleatorios en sus respuestas conjeturales o aleatorias. De hecho, los "motores de predicción de la siguiente palabra" simplemente continúan repitiendo lo que se les ha enseñado, pero sin un marco lógico. Un estudio realizado este año por la Universidad de Stanford reveló que el Genai cometió errores cuando respondió preguntas legales en el 75 % de los casos. "Por ejemplo, en una tarea que mide la relación anterior entre dos casos [judiciaires] Diferente, la mayoría de las LLM no mejor que adivinar al azar ". Optimización de la infraestructura de investigación incorporando la investigación léxica y semántica aumenta la probabilidad de que solo la información relevante se transmitirá a la LLM, dijo Wong." Aunque esto puede reducir significativamente la probabilidad de alucinaciones, esto no puede eliminarlos ", agregó", agregó la calidad de la calidad de la calidad de la raga que determina la calidad de la calidad de la operación de la gestión, lo que hace que la calidad sea de gestión esencial de lo que hace la calidad de la calidad de la calidad. Un punto de partida para minimizar las alucinaciones.

Otras noticias que te pueden interesar