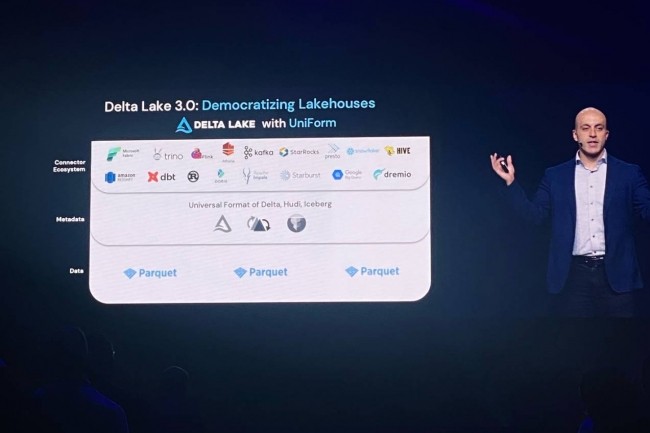

Presentada a principios de semana, la versión Delta Lake 3.0 de la oferta data lakehouse de Ladrillos de datos tiene como objetivo estandarizar los formatos de tablas de datos. "Esta actualización incluye un formato de tabla universal, llamado UniForm, que permitirá a las empresas utilizar el lago de datos con otros formatos de tabla como Apache Iceberg y Apache Hudi". declarado la empresa. A diferencia de los conceptos de lago de datos, que almacena datos en formato nativo, y almacenes de datos, que almacenan datos estructurados (a menudo en formato SQL), la arquitectura de datos del lago de datos ofrece almacenamiento y análisis. "UniForm evita la conversión manual de archivos de diferentes lagos y almacenes de datos al realizar análisis o construir modelos de IA", enfatiza el proveedor. Según los analistas, la introducción de este nuevo formato de mesa es una respuesta de Databricks a su rival Snowflake, que ha elegido las mesas Iceberg, como cada vez más proveedores.

"Con UniForm, Databricks esencialmente dice: si son imposibles de vencer, únete a ellos", dijo Tony Baer, analista principal de dbInsight, quien compara la batalla entre formatos de tablas con la que existe entre iOS de Apple y Android de Android. Google. Sin embargo, este último cree que la adopción de las casas en el lago dependerá del ecosistema que ofrezcan y no sólo de los formatos de las mesas. Y esta adopción es "todavía muy preliminar, porque los ecosistemas acaban de cristalizar y la mayoría de las empresas apenas están empezando a saber qué son las casas en el lago", afirmó Tony Baer, prediciendo una mejora en el próximo año. A diferencia de Tony Baer, Databricks dijo que su Delta Lake se descargó casi mil millones de veces en un año. Según el proveedor, la transición de su oferta Delta Lake al código abierto descargable desde Github Habría permitido a Lakehouse beneficiarse de las actualizaciones de los ingenieros de AWS, Adobe, Twilio, eBay y Uber.

Agrupación de núcleos y líquidos delta

En la actualización Delta Lake 3.0 también se introdujeron otras dos características llamadas Delta Kernel y Liquid Clustering. El primero tiene como objetivo resolver el problema de la fragmentación de los conectores garantizando que se construyan utilizando una biblioteca Delta central que implemente las especificaciones Delta. "Esto evita que los usuarios tengan que actualizar los conectores Delta con cada nueva versión o cambio de protocolo", dijo Databricks.

Según Sanjeev Mohan, analista principal de SanjMo, el núcleo Delta es similar a un kit de desarrollo de conectores que abstrae muchos de los detalles subyacentes y, en su lugar, proporciona un conjunto de API estables. “Es más sencillo y lleva menos tiempo construir e implementar los conectores. Por eso creemos que los integradores de sistemas podrán acelerar el desarrollo y despliegue de conectores, lo que ayudará a ampliar el ecosistema de socios de Databricks”, afirmó el consultor. "En cuanto a Liquid Clustering, resolverá los problemas de rendimiento relacionados con las operaciones de lectura y escritura de datos", dijo Databricks. A diferencia de los métodos tradicionales como la partición estilo Hive, que es compleja debido al diseño de datos fijo para mejorar el rendimiento de lectura y escritura, Liquid Clustering ofrece un formato de diseño de datos flexible que, según Databricks, hará que la agrupación en clústeres sea más rentable a medida que aumente el tamaño de los datos.

Otras noticias que te pueden interesar