Poco a poco, Snowflake va ganando poder en IA. Después de haber presentado El pasado mes de noviembre Cortex (servicio que facilita la creación de aplicaciones basadas en IA), invertido en Mistral AIEl especialista en almacenamiento de datos en la nube está lanzando un LLM llamado Arctic. El nombre puede resultar confuso, ya que la editorial estadounidense también tiene una familia de modelos con el mismo nombre. Según Shridar Ramaswamy, fundador de Neeva, adquirida por Snowflake en mayo de 2023 y El sucesor de Frank Slootman en febrero pasado Como director ejecutivo, “Arctic supone un hito importante para la empresa y los equipos de investigación de IA, ya que aumenta el rendimiento y la transparencia”.

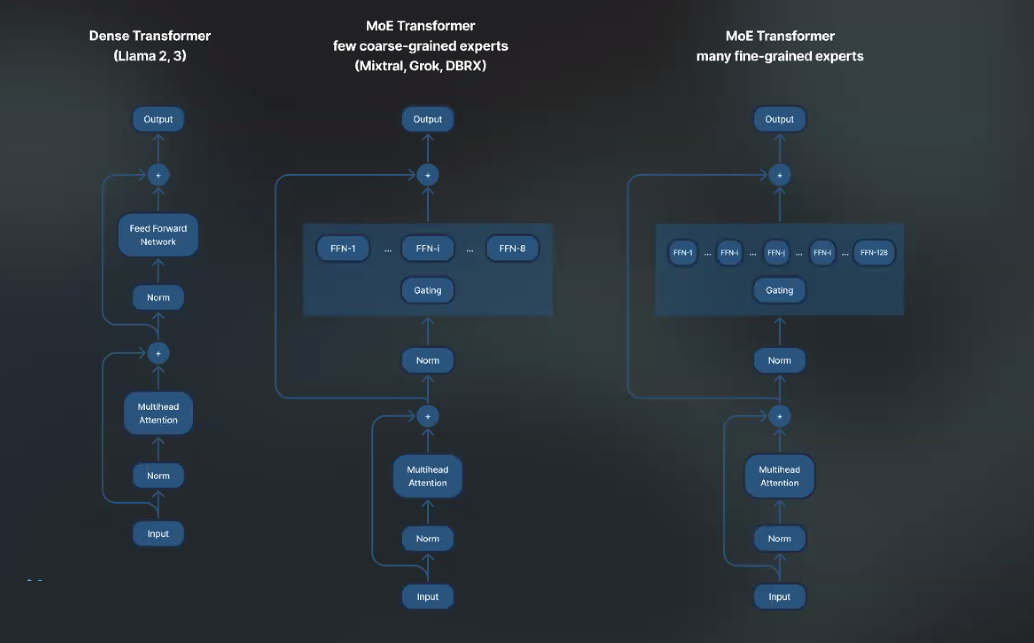

En términos de capacidad, el LLM de Snowflake incluye 480 mil millones de parámetros. Pero es en la arquitectura de código abierto elegida donde la empresa pretende marcar la diferencia apoyándose en el MoE (mix de expertos). Yuxiong He, ingeniero emérito de Snowflake y creador de la biblioteca de optimización de aprendizaje profundo Deepspeed, intenta una metáfora hospitalaria para explicarlo: "al principio, los pacientes son recibidos por un médico generalista que no necesariamente tendrá el diagnóstico correcto y los remitirá a un experto (cardiólogo, psiquiatra o reumatólogo). Este último también puede pedir consejo a expertos aún más especializados (cirugía cardíaca, alergólogo, etc.)". En el caso de Arctic, las tareas de IA se dividen en varios componentes (expertos). Cada experto está diseñado para un trabajo específico y los resultados son más precisos. El modelo es capaz de movilizar a 128 expertos que pueden activar cada uno 17 de los 480 mil millones de parámetros durante la inferencia y el entrenamiento.

Snowflake utiliza la arquitectura MoE para su Arctic LLM. (Crédito de la foto: Snowflake)

Se reivindica una formación optimizada y transparencia

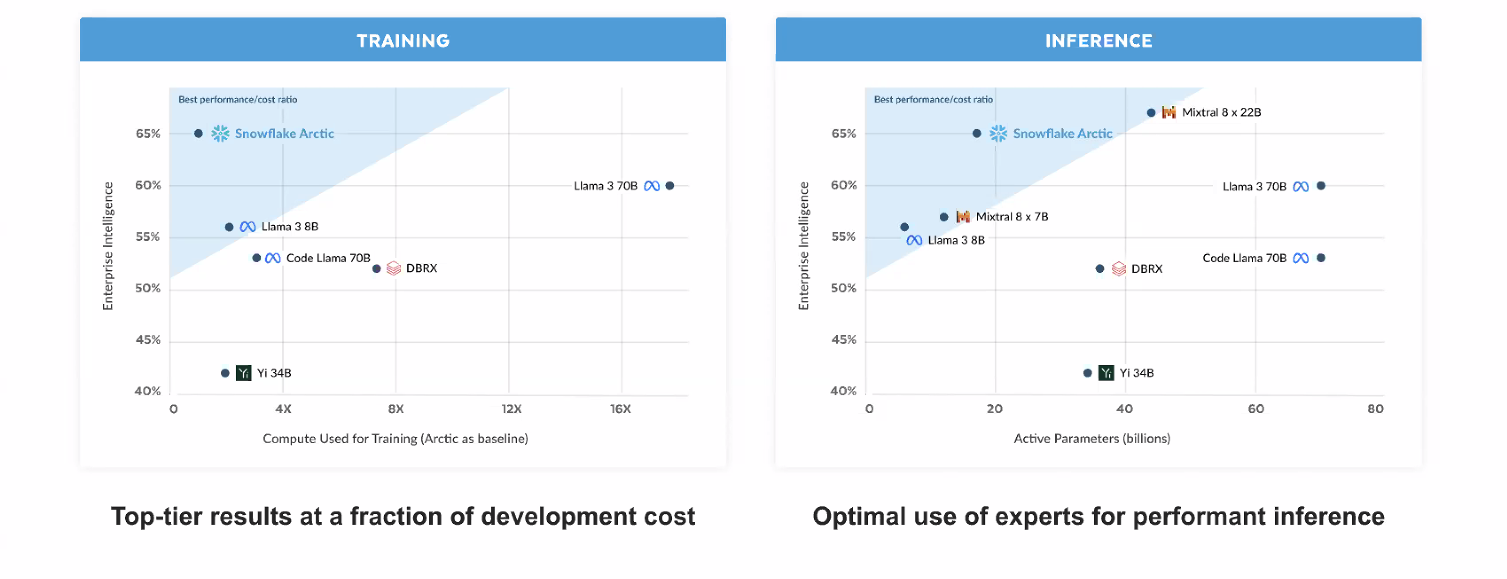

Esta elección de arquitectura (adoptada por otros editores de LLM como Mixtral 8x7B o Llama) aporta varios beneficios: inferencias más eficientes y entrenamiento más económico. El equipo de Yuxiong afirma haber desarrollado Arctic en menos de 3 meses y haber gastado una octava parte del coste de entrenar modelos comparables. El LLM se entrenó en instancias AWS P5. Snowflake está orientando Arctic para usos empresariales como consultas SQL o generación de código y obtiene un mayor rendimiento en estas áreas. El otro aspecto en el que insiste la firma estadounidense es el carácter "verdaderamente" abierto de su LLM. Publica el peso de su modelo, así como los detalles de la investigación que llevó a su entrenamiento bajo la licencia Apache 2.0. Tiene previsto publicar otros elementos próximamente.

Costes de desarrollo y rendimiento de Arctic en comparación con la competencia. (Crédito de la foto: Snowflake)

Arctic está disponible dentro del mencionado Cortex y será accesible en otras plataformas: AWS, Hugging Face, Lamini, Microsoft Azure, el catálogo de API de Nvidia, Perplexity, Together AI. Con Arctic, Snowflake entra así en la guerra de LLM con un pequeño retraso en comparación con competidores directos como Bloques de datos (con DBRX) o las diferentes variaciones de Llama de Meta.

Otras noticias que te pueden interesar