Inteligencia artificial Mistral no se duerme en los laureles. Después habiendo conseguido recaudar 600 millones de euros - y superando de paso la valoración teórica de 6.000 millones de euros - la start-up francesa ha multiplicado los lanzamientos de modelos lingüísticos en los últimos meses, entre ellos Mezcla 8x22B o CodísticoEste último, especializado en generación de código, ya tiene un descendiente con Codístico Mamba. Mientras que su predecesor dependía de 22 mil millones de parámetros, el último es un 7B y, por lo tanto, se basa en la arquitectura del modelo de lenguaje Mamba, diseñada para abordar algunas de las limitaciones de los modelos de transformadores, en particular en el procesamiento de secuencias largas. Los casos de uso son variados, e incluyen tanto la finalización o generación de código como la detección y resolución de errores.

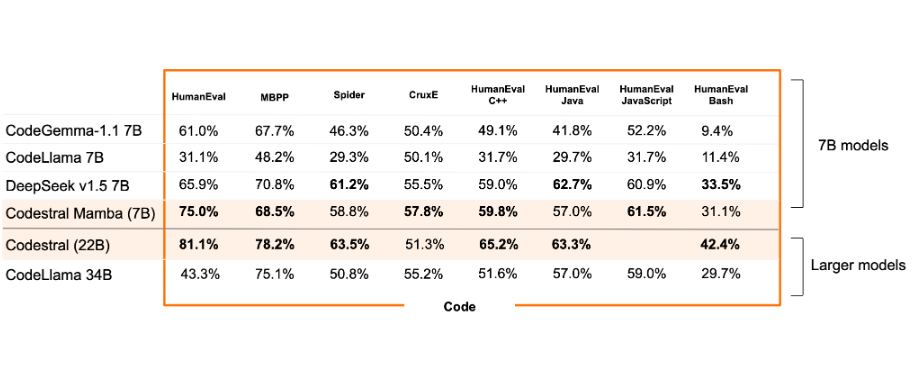

Según la startup francesa, Codestral Mamba tiene la ventaja de la inferencia en tiempo lineal y la posibilidad teórica de modelar secuencias de longitud infinita, y permite a los usuarios utilizarlo de forma intensiva y obtener respuestas rápidas, independientemente de la longitud de la entrada. "Esta eficiencia es particularmente relevante para los casos de uso de productividad de código, por lo que entrenamos este modelo con capacidades avanzadas de código y razonamiento, lo que le permite funcionar tan bien como los modelos basados en transformadores SOTA". explicar Mistral AI. Según los resultados de una comparación realizada por Mistral AI, Codestral Mamba aparentemente logra destacarse en muchas pruebas.

Comparación del rendimiento de Codestral Mamba 7B y Codestral 22B frente a otros LLM de generación de código del mercado. (crédito: Mistral AI)

Posible implementación a través de TensorRT-LLM y próximamente llama.ccp

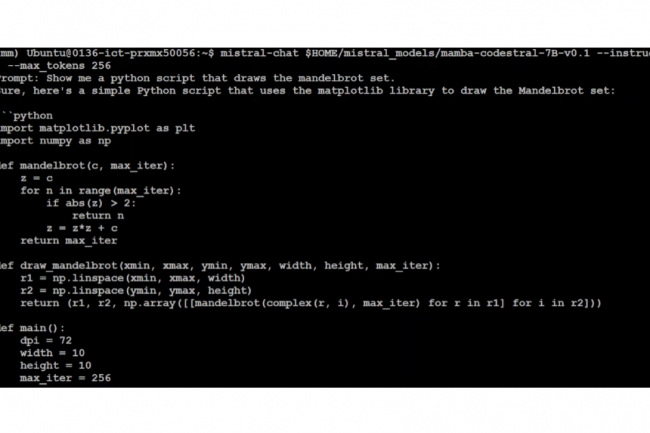

Codestral Mamba ha sido probado con capacidades máximas de recuperación de contexto de 256k tokens. A diferencia de su hermano mayor, Codestral Mamba 7B no se ofrece bajo licencia MNPL o comercial, sino solo bajo Apache 2.0 para fines de prueba e investigación, lo que significa que su código se puede modificar y compartir libremente sin restricciones. Este modelo, Disponible en Hugging Facese puede implementar utilizando el SDK mistral-inference, que se basa en implementaciones de referencia del repositorio GitHub de Mamba, pero también a través de TensorRT-LLM y pronto llama.cpp.

Junto con Codestral Mamba, Mistral AI también anunció Mathstral 7B, un modelo de lenguaje diseñado específicamente para el razonamiento matemático y el descubrimiento científico. Su lanzamiento se produce Unos meses después del de Orca-Math de Microsoft basado en Mistral 7B.

Otras noticias que te pueden interesar