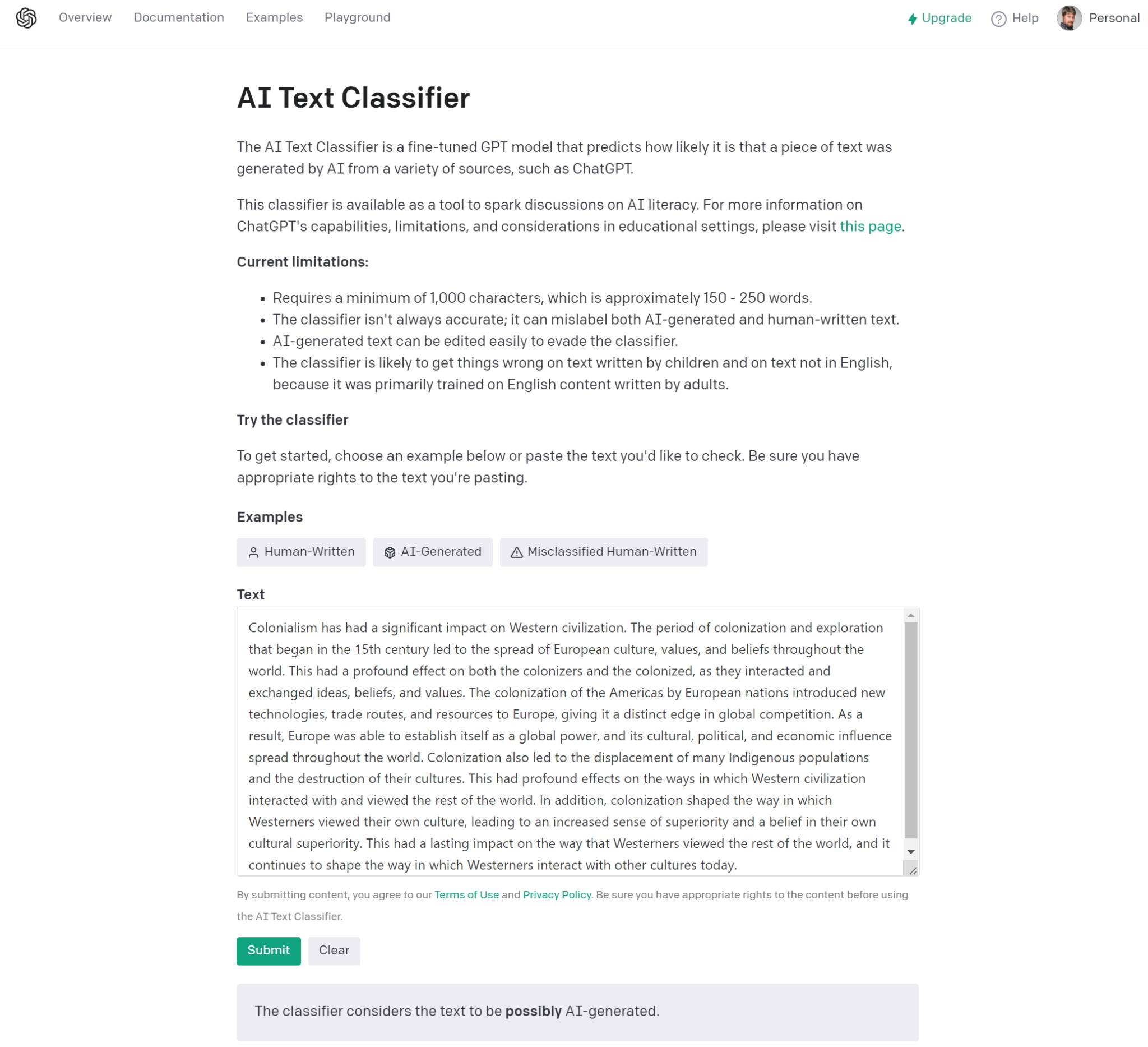

Con Clasificación de texto para chatgpt, Opadai Ingrese a los auditores de baile generados por su chatbot conversacional que fascina tanto como le preocupa. El mundo de la enseñanza está particularmente expuesto a este problema donde los estudiantes percibieron rápidamente las ventajas de ChatGPT. Ayuda que puede asimilarse a hacer trampa en algunos casos. El problema es tratar de determinar qué respuestas fueron escritas por un humano y cuáles por una IA. Sin embargo, la herramienta de detección de Operai tiene una debilidad: es bastante fácil de engañar. En un comunicado, la nueva empresa dijo que la clasificación de texto había identificado el 26 % de los textos escritos por AI como auténticamente humanos, y consideró que el 9 % de los textos escritos por un humano fueron escritos por IA. En el primer caso, esto significa que el servicio no ha tenido éxito, en promedio, para detectar aproximadamente una cuarta parte de las personas que usaron IA sin informarlo.

Además, se acompaña de varias reservas. Primero, cuantas más palabras hay, mejor: "Por debajo de 1,000 caracteres, es probable que la herramienta se equivoque", dijo Openai. Otra restricción, solo funciona con inglés y no puede determinar si el código ha sido escrito por una IA o un humano. "Finalmente, los textos escritos por AI pueden modificarse para escapar del texto clasificado", dijo la firma. En resumen, ella reconoce sin rodeos en su comunicado de prensa "Él no es completamente confiable".

Pruebas de baja confonección

Durante una prueba rápida de nuestro colega de PC World, el analizador no pudo decir si AI había escrito un pasaje elegido al azar de las "Catre-Cœurs" de JD Salinger, pero AI declaró que era muy poco probable que un pasaje similar de "Alicia en el país de las maravillas" de Lewis Carroll fue generado por AI. La herramienta también aceptó un artículo tomado al azar escrito por Brad Chacos, el editor -in -Chief de PCWorld. Desafortunadamente, ChatGPT estaba fuera de servicio cuando intentamos acceder a él, pero el motor de búsqueda emergente You.com, que se unió a su propio IA Chatbot, sirvió como una plataforma de prueba adicional.

Herramienta de detección de OpenAI en acción. (Crédito: Openai)

You.com se diferencia de Chatgpt en el sentido de que él cita (ahora) sus fuentes. Por lo tanto, la orden: "Escribir un texto que explica cómo el colonialismo ha dado forma a la civilización occidental", citó Wikipedia, Britannica.com y un seminario de honor de la Universidad de Tennessee en su chatbot yoochat. Clasificar el texto de OpenAI lo identificó como generado por AI. Encontró el mismo resultado para una historia corta generada por AI en una emu que podría volar. Más tarde, sin embargo, pudimos identificar una respuesta similar a nuestra pregunta sobre el colonialismo en el chatgpt. "La herramienta considera que el texto no está claro si es generado por AI", concluyó. Una solicitud similar de prueba de ficción en ChatGPT, a saber, "escribir una historia corta en un perro que construye un cohete y vuela hacia la luna", también generó la misma respuesta poco clara. Por lo tanto, no solo la herramienta OpenAI genera conclusiones borrosas, sino que no es suficiente determinar qué resultados generan la IA.

Prueba la moderación de la colmena

Operai no tiene el monopolio de la detección de contenido generado por AI. Hay otras soluciones como DetectGPT o Zerogpt. Este es también el caso con la moderación de Hive, una solución creada por un ingeniero de ML de Hive AI, y que parece funcionar. Por un lado, devuelve un porcentaje de confianza, es decir, la probabilidad de que la muestra de texto contenga el texto generado por una IA. En nuestra pregunta sobre el colonialismo (ver arriba), con respuestas de ChatGPT y You.com, Hive Modation dijo que era probable que contenga texto, con un porcentaje de confianza del 99.9 %. La historia corta del perro y su cohete generaron la misma probabilidad del 99.9 %. La herramienta también estimó en 0 % la probabilidad de que los extractos de "Alicia en el país de las maravillas" y "los receptores" generen la IA, como es de esperar. También se aceptó el artículo sobre Nvidia escrito por Brad Chacos de Pcworld.com, con una probabilidad absoluta de 0 % de que fue escrita por una IA.

La moderación de la colmena, por otro lado, proporcionó resultados claros y seguros. (Crédito: moderación de la colmena)

Incluso hemos probado esta pregunta en ChatGPT: "Escriba un texto que explique cómo el colonialismo ha dado forma a la civilización occidental, pero para que no sea obvio que IA lo haya escribido". La moderación no-hive también la ha detectado. De hecho, en todas las pruebas que hemos sufrido, la moderación de la colmena ha identificado cada vez, con un porcentaje de confianza clara, las muestras generadas por la IA y las que no lo fueron. Por lo tanto, incluso si la clasificación de texto debe considerarse debido a su vínculo con OpenAI, parece que la moderación de la colmena es mejor detectar los textos escritos por una IA y aquellos que no lo son. Tenga en cuenta que las promesas abiertas en las próximas versiones de ChatGPT para integrar "Marca de agua" (impresiones) para facilitar esta detección.

Otras noticias que te pueden interesar