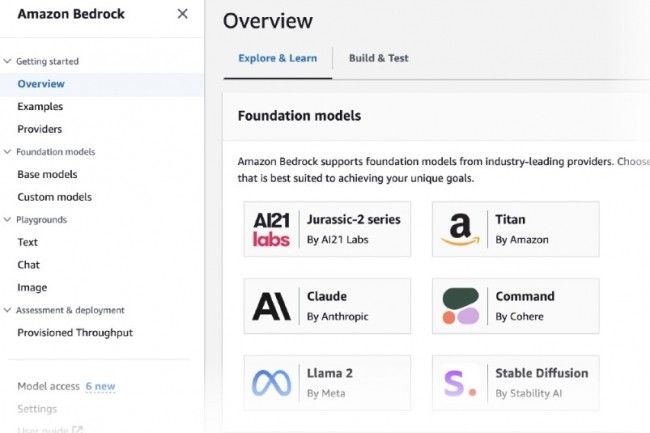

La plataforma de lecho rocoso deAWS El trabajo de creación de sistemas a partir de modelos de lenguaje preentrenados es cada vez más intenso. El grupo anunció que Mistral 7B y Mixtral 8x7B de la start-up francesa Mistral AI estarán disponibles próximamente en este entorno, sin más detalles. Estos modelos se sumarán a otros que ya se ofrecen, como AI21 Labs, Anthropic, Cohere, Meta, Stability AI y Amazon. "Con estos dos modelos de Mistral AI, tendrá la flexibilidad de elegir el LLM óptimo y eficiente para su caso de uso con el fin de construir y escalar aplicaciones de IA generativa utilizando Bedrock", anotado Servicios de AWS.

Mistral 7B es el primer modelo base de Mistral AI, que admite tareas de generación de texto y capacidades de código. Está optimizado para una baja latencia con bajos requisitos de memoria y un alto rendimiento para su tamaño. "Este modelo es potente y admite una variedad de casos de uso, desde resumen de texto hasta clasificación, finalización de texto y finalización de código", dijo AWS. Mixtral 8x7B es un modelo de mezcla dispersa de expertos (MoE) diseñado para resumen de texto, preguntas y respuestas, clasificación y finalización de texto y generación de código.

Otras noticias que te pueden interesar