Arista Networks ha proporcionado algunos detalles sobre el lanzamiento de su tecnología Etherlink que respaldará las redes Ethernet capaces de satisfacer las demandas de las cargas de trabajo impulsadas por IA. La plataforma Etherlink incluirá una amplia gama de sistemas 800G y tarjetas de línea basadas en el sistema operativo EOS del proveedor, que eventualmente incluirán funciones Ethernet supercargadas compatibles con las especificaciones del Ultra Ethernet Consortium (UEC), explicó el CEO de Arista, Jayshree Ullal, en una publicación reciente en su blog. "A medida que UEC completa sus extensiones para mejorar Ethernet para cargas de trabajo de IA, Arista asegura a sus clientes que puede ofrecer productos habilitados para UEC que pueden evolucionar fácilmente hacia estándares futuros a medida que el Ultra Ethernet Consortium avanza hasta 2025", escribió Ullal.

Fundado el año pasado por AMD, Arista, Broadcom, Cisco, Eviden, HPE, Intel, Meta y Microsoft, el Consorcio Ultra Ethernet ahora incluye más de 50 proveedores. El consorcio desarrolla tecnologías para aumentar la escala, la estabilidad y la confiabilidad de las redes Ethernet para satisfacer las demandas de la IA de redes de alto rendimiento. A finales de este año, el consorcio planea publicar especificaciones formales que se centrarán en una serie de mejoras escalables de Ethernet, incluida una mejor entrega de paquetes y opciones de múltiples rutas, así como funciones modernas de congestión y telemetría. "En toda la cartera Etherlink de Arista, las funciones habilitadas para UEC incluirían equilibrio de carga dinámico, control de congestión y entrega confiable de paquetes", dijo Ullal.

Reducir la latencia y la congestión

“Las cargas de trabajo de IA están impulsando la operación 'colectiva', donde Allreduce y All-to-All son los tipos colectivos dominantes. Con GPT-4, los modelos actuales ya están escalando de miles de millones a billones de parámetros. Por supuesto, hay otros, como Google Gemini, Llama (código abierto) y Grok (xAI)”, dijo Ullal. “Durante el ciclo de cómputo, intercambio y reducción, el volumen de datos intercambiados es tan grande que cualquier desaceleración debido a la mala calidad de la red puede tener un impacto crítico en el rendimiento de la aplicación de IA. La topología de IA de Etherlink permitirá que cada flujo acceda a todas las rutas al destino simultáneamente con equilibrio de carga dinámico a velocidades de varios terabits”, dijo. “Hoy, Arista Etherlink admite un radio de 1.000 a 100.000 nodos de GPU, y crecerá a más de un millón de GPU en el futuro”, agregó el ejecutivo.

Según el CEO, las plataformas Etherlink de Arista tienen otras dos características clave: latencia predecible y gestión de la congestión. En cuanto a la latencia predecible, “la transferencia masiva rápida y confiable desde el origen al destino es fundamental para la finalización de todas las tareas de IA. La latencia por paquete es importante, pero la carga de trabajo de IA depende más de la finalización oportuna de un paso de procesamiento completo. En otras palabras, la latencia de todo el mensaje es fundamental. Los mecanismos de control flexibles utilizan todas las rutas de Etherlink, desde la NIC hasta el conmutador, para garantizar una comunicación predecible de extremo a extremo”. En cuanto a la gestión de la congestión, la gestión de la congestión en las redes de IA es un problema común de “incast”. “La congestión puede ocurrir en el último enlace del receptor de IA cuando varios remitentes descoordinados le envían tráfico simultáneamente. Para evitar puntos calientes o colisiones de flujo en costosos clústeres de GPU, se están definiendo algoritmos para estrangular, notificar y distribuir uniformemente la carga a través de múltiples rutas, mejorando la utilización y el costo total de propiedad de estas costosas GPU con una estructura VoQ”, dijo Ullal. La estructura de cola de salida virtual (VoQ) de Arista presenta un mecanismo de programación distribuida que garantiza que los flujos de tráfico se enruten a través de puertos de conmutación congestionados.

Análisis de tráfico a nivel de microsegundos

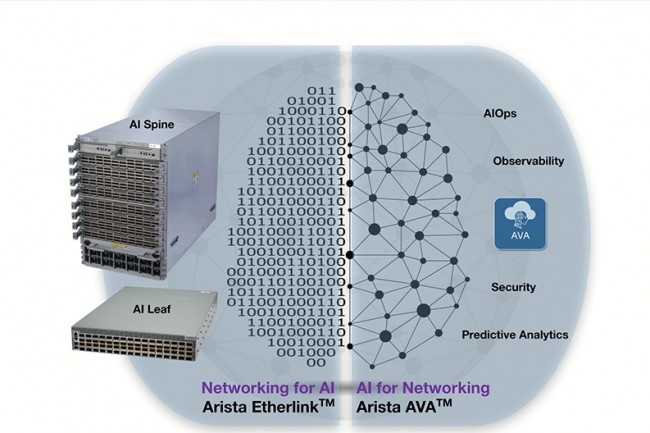

“La red de IA de Arista también se basa en una combinación de nuestro sistema operativo EOS central y su sistema de asistencia virtual autónoma (AVA) basado en lenguaje natural e IA generativa para proporcionar información sobre la red”, agregó la directora ejecutiva. “Con un sistema experto impulsado por IA que automatiza la resolución de problemas complejos, el análisis de la causa raíz y la protección contra amenazas, Arista AVA imita la experiencia humana a escala de la nube”, dijo. “El sistema de asistente virtual autónomo comienza con datos de referencia en tiempo real sobre el estado de los dispositivos de red y, si es necesario, paquetes sin procesar. AVA combina nuestra profunda experiencia en redes con un conjunto de técnicas de IA/ML, que incluyen ML supervisado y no supervisado y procesamiento del lenguaje natural (NLP). La aplicación de AVA a las redes de IA aumenta la fidelidad y la seguridad de la red a través de la detección y respuesta autónomas de la red y la observabilidad en tiempo real”.

En cuanto a la pila de software EOS de Arista, Ullal dijo que puede ayudar a los clientes a construir clústeres de IA resistentes. “EOS ofrece algoritmos de equilibrio de carga mejorados y mecanismos de hash que asignan el tráfico desde los puertos de entrada del host a los enlaces ascendentes para que los flujos se reequilibren automáticamente en caso de una falla del enlace”, escribió Ullal. “Nuestros clientes ahora pueden elegir los campos de encabezado de paquetes para una mejor entropía y un equilibrio eficiente de las cargas de trabajo de IA”. Otro aspecto crítico de la fase de entrenamiento para grandes conjuntos de datos utilizados para mejorar la precisión de LLM, dijo Ullal, es la visibilidad de la red de IA. “Además del analizador de latencia basado en EOS que monitorea el uso del búfer, el analizador de IA de Arista monitorea los contadores de tráfico a nivel de microsegundos, lo que ayuda a identificar y abordar microrráfagas difíciles de detectar en intervalos de unos pocos segundos”, señaló Ullal.

Repensando las redes para la IA

En general, “dadas las cargas de trabajo masivamente paralelizadas” que pueden causar congestión, los clústeres de entrenamiento de IA requieren un enfoque fundamentalmente nuevo para la construcción de redes. “La congestión de tráfico en una sola transmisión puede causar un efecto dominó que ralentice todo el clúster de IA, ya que la carga de trabajo tiene que esperar a que se complete la transmisión retrasada. Los clústeres de IA deben diseñarse con una capacidad masiva para acomodar estos patrones de tráfico de GPU distribuidas, con latencia determinista y estructuras Deep Buffer sin pérdidas que puedan eliminar la congestión no deseada”, explicó Ullal.

Otras noticias que te pueden interesar