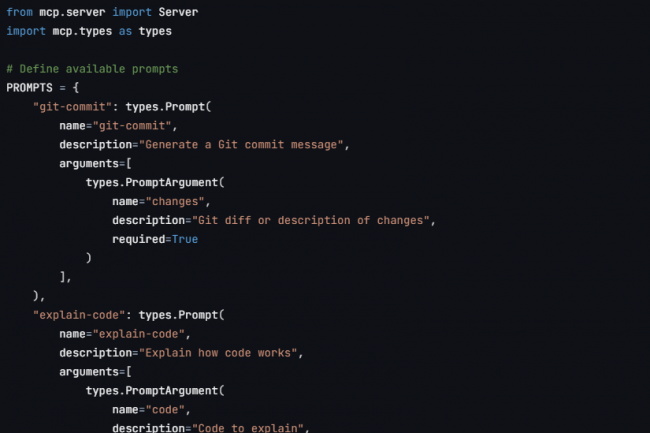

"Proponga un estándar universal y abierto para conectar sistemas AI a fuentes de datos, reemplazando las integraciones fragmentadas por un solo protocolo". Esta es la última promesa de Anthrope con su protocolo de contextualización de modelo (Protocolo de contexto del modelo, MCP) que él Acabo de revelar. "Ya sea que construya un IDE alimentado por IA, mejore una interfaz CAT o cree flujos de trabajo de IA personalizados, el MCP proporciona una forma estandarizada de conectar LLM al contexto que necesitan", Anuncio antrópico en su página del proyecto GitHub. Este MCP gira en torno a tres componentes: la especificación del protocolo y los kits de desarrollo de software (SDK), la administración del servidor MCP local en las aplicaciones de escritorio Claude, así como un código abierto de servidores MCP.

Como expresado Anthrope, MCP proporciona un medio estandarizado para aplicaciones para compartir información contextual con modelos de idiomas, exponer herramientas y capacidades a los sistemas de IA y crear integraciones y flujos de trabajo compuestos. Este protocolo utiliza mensajes JSON-RPC 2.0 para establecer la comunicación entre hosts (aplicaciones LLM que establecen conexiones), clientes (conectores dentro de la aplicación de host y servidores (servicios que proporcionan contexto y capacidad). El editor también ha compartido servidores MCP preconstruidos para sistemas comerciales populares como Google Drive, Slack, Git, Post-Gres y Puppeteer. En menos pruebas.

Consideraciones de seguridad y confianza a tener en cuenta

Según el proveedor, este protocolo "permite capacidades potentes gracias al acceso arbitrario a los canales de ejecución de datos y código", sin embargo, requiere varias consideraciones importantes en términos de seguridad y confianza. Estos se dividen en 4 categorías:

Consentimiento y control de los usuarios : Los usuarios deben consentir explícitamente para el acceso a los datos y su explotación, y comprenderlo, pero también mantener el control sobre los datos compartidos y sobre las acciones que se toman. Los gerentes de implementación deben proporcionar interfaces de usuario claras para el examen y la autorización de actividades;

Confidencialidad de datos : Los hosts deben obtener el consentimiento explícito del usuario antes de exponer los datos del usuario a los servidores. Los hosts no deben transmitir los datos relacionados con un tercero sin el consentimiento del usuario. Los datos del usuario deben estar protegidos por controles de acceso apropiados;

Seguridad de la herramienta : Las herramientas realizan códigos arbitrarios y deben tratarse con la prudencia que es esencial. Los hosts deben obtener el consentimiento explícito del usuario antes de invocar cualquier herramienta. Los usuarios deben comprender lo que hace cada herramienta antes de autorizar su uso;

Checks de muestreo LLM : Los usuarios deben aprobar explícitamente cualquier solicitud de muestreo de LLM, controlar si tiene lugar o no, pero también el mensaje efectivo que se enviará y los resultados que el servidor puede ver. Anthrope también indica que el protocolo limita intencionalmente la visibilidad del servidor en las indicaciones.

"Aunque MCP en sí no puede aplicar estos principios de seguridad a nivel del protocolo, los responsables de la implementación deben: integrar en sus flujos de consentimiento de aplicaciones y una autorización sólida, proporcionar una documentación clara sobre las implicaciones en términos de seguridad, implementar controles de acceso y protecciones de datos apropiadas en las mejores prácticas en términos de seguridad en sus integraciones y tener en cuenta la privacidad en el diseño de sus características". Queda por ver si los gerentes y desarrolladores de proyectos de IA interesados en este protocolo de contexto modelo tendrán en cuenta todo o parte de estas precauciones de uso.

Otras noticias que te pueden interesar