Solo tomó un puñado de días para El martillo de la marea profunda Pon el mundo sin arriba. Mientras Los estados van a la ofensiva Para analizar ambos impactos de esta IA, tanto en términos de seguridad como de confidencialidad de datos - con más de un millón de datos confidenciales ya expuestos - La competencia suministra sus armas.

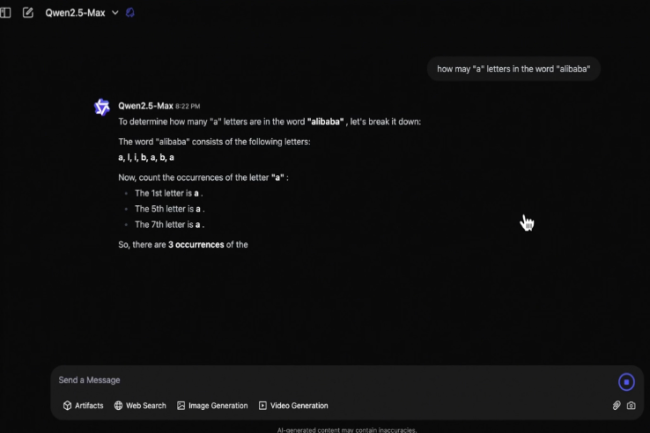

Alibaba Muscle Qwen 2.5

Entre ellos, el compatriota Alibaba se reaccionó rápidamente, incluso en la mitad del Año Nuevo Lunar (donde los chinos están de permiso) con la presentación del gran modelo de idioma Qwen 2.5 Max. Según la compañía, sería más eficiente que Veterano V3 y LLAMA 3.1 405B de Meta o incluso GPT 4O de OpenAi. El LLM se basa en una arquitectura MOE (mezcla de expertos) y ha sido prevenido en 20,000 mil millones de tokens. Luego fue refinado con el fortalecimiento supervisado y humano.

Por su parte, la Asociación del Instituto Allen para AI (AI1) presentó Tülu 450b que "que" alcanza un rendimiento competitivo o superior a los de Deepseek V3 y GPT-4O ". El cuerpo agrega que su modelo también supera a los competidores como LLama 3.1 405B instrucciones Y tenemos 3 405b, en muchos criterios de referencia.

Los miembros de la cara abrazados diseccionan R1 de Deepseek

Saltando sobre la disposición en código abierto por Deepseek de su LLM razonando R1 (licencia MIT), la comunidad libre está activa para desentrañar todos los secretos. Para esto, en la cara abrazada, el Proyecto Open-R1 fue creado para diseccionar el modelo chino y conocer los detalles más pequeños. Elie Bakouch, uno de los ingenieros que abrazan frente a la cabeza de este proyecto, explicado En TechCrunch, que R1 no es completamente de código abierto. De hecho, muchos componentes utilizados para construirlo, así como los datos sobre los que se formó no se han hecho públicos.

Una vaguedad que, según el ingeniero, evita que la comunidad se inspire o lo mejore. Se ha establecido un trabajo de ingeniería retro para descubrir los elementos faltantes. Para hacer esto, la iniciativa se basará en un servidor de investigación de Face Dediced, el clúster de ciencias, alimentado por 768 GPU NVIDIA H100. El proyecto Open-R1 ha despertado mucho interés hasta ahora, su página de GitHub había obtenido más de 100,000 estrellas en solo tres días después de su lanzamiento.

Mistral empuja a su SLM pequeño 3

Muy discreto desde el lanzamiento de Deepseek, Mistral, juzgado por la voz de su cofundador y CEO Arthur Mensch de que el modelo de la sociedad china "era un elemento importante y complementario de la tecnología de código abierto". Sin embargo, Mistral no tiene la intención de competir en R1 frontal, pero prefiere centrarse en modelos más pequeños. Es en este contexto que La compañía francesa presentó una pequeña 3.

Con 24 mil millones de parámetros y código abierto, "puede servir como un modelo básico sólido para sacar capacidades de razonamiento", explica Mistral. Su pequeño tamaño no excluye un buen rendimiento al anotar puntos contra otros como Llama 3.3 70B o GPT-4O. La oportunidad de recordar que en la guerra que los proveedores de LLM están comprometidos, la batalla solo se juega (en realidad) solo por el rendimiento pero de uso y adecuación de las necesidades.

Otras noticias que te pueden interesar