Akamai Technologies se ha asociado con Neural Magic para acelerar las cargas de trabajo de IA en su plataforma de distribución en la nube, optimizando el rendimiento de modelos complejos en servidores rentables basados en CPU en lugar de costosos aceleradores de GPU (por ejemplo, $40 000 para un Nvidia H100). Como parte del acuerdo, Neural Magic se unirá al programa de socios de Akamai, que hace que los servicios interoperables sean fácilmente accesibles en su plataforma CDN. En el caso de Neural Magic, su software es capaz de ejecutar de manera eficiente modelos de inferencia de IA en hardware de CPU de consumo. Como explicó Akamai, el software de Neural Magic acelera la inferencia de IA utilizando tecnologías de esparcimiento de modelos automatizadas, disponibles como un motor de inferencia de CPU.

El especialista en CDN ofrecerá ahora el software de Neural Magic con su plataforma de distribución de contenido. “La solución de NeuralMagic, que mejora la ejecución de las cargas de trabajo de IA, estará disponible para los clientes en la infraestructura informática distribuida de Akamai”, afirmó Ramanath Iyer, director de estrategia de Akamai. “Los clientes con grandes modelos de aprendizaje profundo ahora podrán aprovechar una plataforma rentable basada en el borde para implementar aplicaciones de IA con uso intensivo de datos a escala con un rendimiento mejorado y una latencia reducida”, agregó. “Esto significa que los clientes de Akamai podrán aprovechar los beneficios de la informática de borde, incluida una latencia más baja y la residencia de datos, sin tener que depender de recursos de GPU escasos y costosos”, dijo. “Además, a medida que la plataforma se expanda, Neural Magic estará disponible en ubicaciones remotas en el borde de la red hiperdistribuida de Akamai, lo que permitirá que más empresas escalen las cargas de trabajo impulsadas por IA en todo el mundo”, dijo Iyer.

¿Aprendizaje profundo en el borde?

La combinación de estas tecnologías podría resolver un dilema que plantea la IA: exigir procesamiento de IA en el borde (en este caso, la propia red de dispositivos de Akamai). Los expertos en redes generalmente dicen que no tiene sentido invertir en una infraestructura sustancial en el borde si se usa de manera ad hoc. Entregar modelos de IA de manera eficiente al borde también es "un desafío mayor de lo que comúnmente se cree", dijo John O'Hara, vicepresidente sénior de ingeniería y director de operaciones de Neural Magic, en un comunicado. "El hardware especializado o costoso, y los requisitos de energía y entrega que lo acompañan, no siempre están disponibles o no son factibles, por lo que las empresas no se están dando cuenta de los beneficios de la inferencia de IA en el borde. El uso de un procesador menos costoso para hacer este tipo de trabajo de IA cuando es necesario puede ser más fácil de justificar para una empresa".

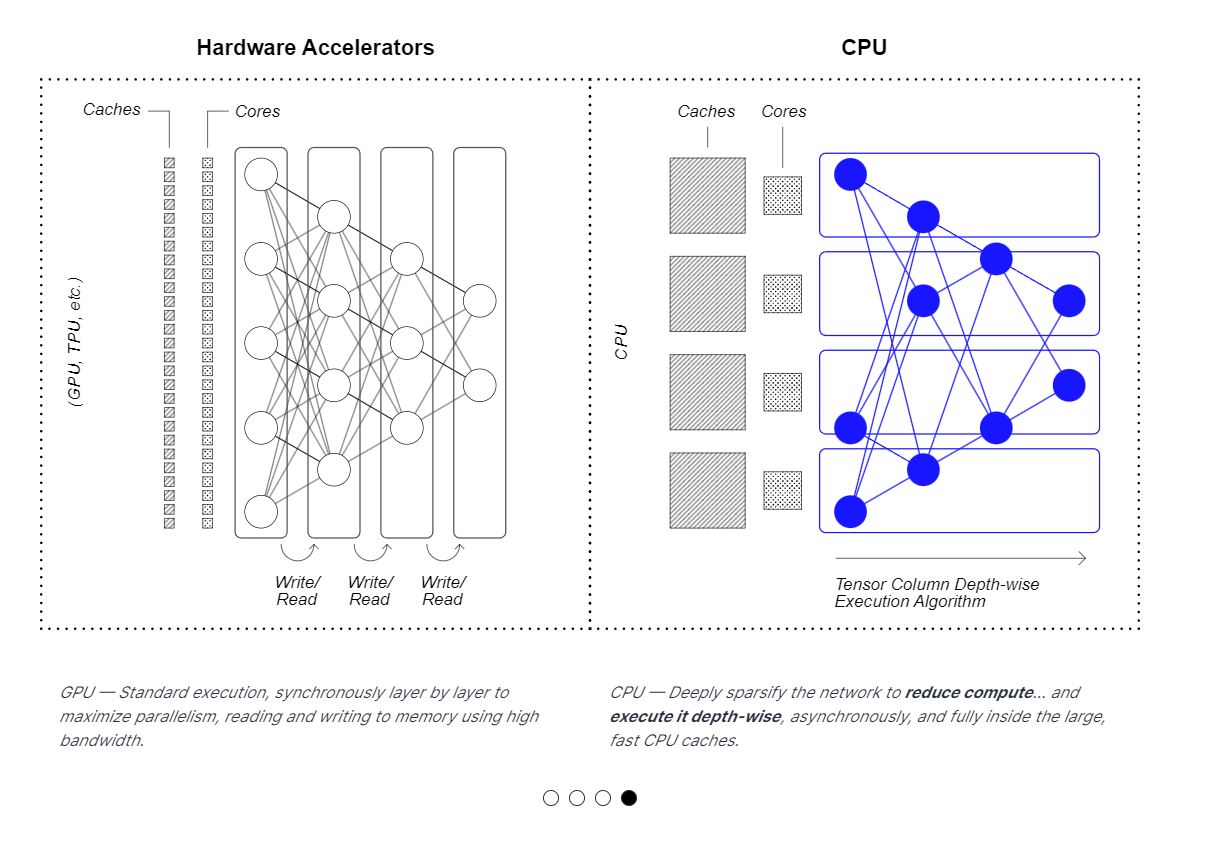

La solución de software de Neural Magic aprovecha al máximo los recursos de la CPU para la inferencia de IA. (Crédito: Neural Magic)

¿La IA se volvió fácil?

Según Iyer, la asociación podría impulsar la innovación en la inferencia de IA en una multitud de industrias. “En esencia, nuestra asociación con Neural Magic se centra únicamente en mejorar la eficiencia de la inferencia”, explicó. “Siempre habrá casos en los que las empresas necesiten una GPU si están entrenando modelos de IA o si su carga de trabajo de IA requiere más computación/memoria. Sin embargo, las CPU también tienen un papel que desempeñar. Ejecutar cargas de trabajo de inferencia de IA en una plataforma basada en CPU definitivamente puede ayudar a las empresas a utilizar sus recursos limitados de manera mucho más eficiente, reduciendo costos y mejorando la confiabilidad”, continuó.

Una mejor IA en el borde también podría tener beneficios en materia de ciberseguridad, ya que “permitiría una inspección más sofisticada del tráfico en el borde de la red”, afirmó Fernando Montenegro, analista principal de Omdia. “Como estamos viendo, los ataques ya no se limitan a explotar vulnerabilidades muy específicas, sino que cada vez incluyen más abusos matizados a nivel de aplicación, por lo que las capacidades de detección de anomalías impulsadas por IA son importantes”, afirmó. “Si asociaciones como esta allanan el camino para que más desarrolladores utilicen el aprendizaje profundo y la IA generativa, eso es positivo”.

Otras noticias que te pueden interesar